英伟达迷你超算遭友商嘲讽:宣传FP4算力,实际“不如买个游戏电脑”

老黄在CES上发布的迷你超算Project DIGITS,开启了AI超算的PC时刻。

但随即也引发了不小争议,还遭到了大佬的贴脸嘲讽。

在AMD和英特尔都工作过的芯片设计专家Raja Koduri实名吐槽道:

FLOPs除以4,价格翻倍,这就是在CES上stay grounded的秘诀。

后来Koduri在网友追问下给出了详细解释,表示英伟达宣传的算力是在FP4精度下的,而Project DIGITS在FP16下的表现,可能就和5070差不多,甚至接近Intel Arc B580(售价250美元)。

友商Tiny Corp更是抓住这一点猛地一波输出,直接表示,人们趋之若鹜的的所谓3000美元超算,就是纯纯的诈骗。

最后还不忘再补一刀说,3000美元还不如买个游戏电脑。

关于细节,Tiny Corp在另一则推文里表示,FP4根本就没法用,Project DIGITS在FP8精度下只有500TFLOPs,顺便宣传自家的产品有4PFLOPs,是Project DIGITS的8倍。

史上最迷你超算,售价22000起

英伟达介绍,这一波发布的Project DIGITS,可以说是目前体积最小的AI超算。

Project DIGITS将于今年5月份由官方和顶级合作商一同发售,起售价3000美元,约合人民币两万二。

它搭载了英伟达全新Grace Blackwell超级芯片——GB10,FP4运算能力达到了1PFLOPs。

GB10包含了英伟达Blackwell GPU,具有最新一代CUDA核心和第五代Tensor Cores。

CPU则是与联发科合作研发的Grace CPU,基于Arm架构,拥有20个节能核心。

CPU和GPU之间,则是通过NVLink-C2C芯片到芯片互连连接,另外还有128GB统一内存和4TBNVMe存储。

据介绍,Project DIGITS可以在桌面端运行200B大模型,还可以把两台组合到一起,跑405B的模型。

此外英伟达还给用户配有AI软件库,包括NGC目录和开发者门户中的软件开发工具包、编排工具、框架和模型等,可用NVIDIA NeMo框架微调模型、NVIDIA RAPIDS库加速数据科学,运行PyTorch等常见框架。

还可以利用NVIDIA Blueprints和NVIDIA NIM微服务构建智能AI应用。

并且在桌面系统上对大模型搞完开发或推理之后,还可以无缝部署到加速云或数据中心基础设施里。

英伟达的桌面CPU计划

之前有传言称,英伟达打算在今年进军消费级CPU市场。

这次的Project DIGITS中,20个节能核心的Grace CPU就是英伟达的第一次试水。

黄仁勋在投资者演讲中回答分析师的问题时表示,英伟达与联发科共同设计了一款“可以广泛销售的”节能CPU。

不过,搭载新CPU的Project DIGITS主要面向AI从业人员,主要运行Linux系统,离成为大众消费市场设备还存在距离。

但老黄也明确表示,英伟达对于桌面级的CPU“有进一步计划”,具体细节则要之后再透露。

不过这已经足够证明,英伟达想要进军消费级CPU的说法属实。

并且老黄也对此充满了信心:

我们将使其成为主流产品,将竭尽全力支持专业和高质量的软件,而PC(制造商)将向最终用户提供它。

另外,与英伟达合作的联发科可能也有自己的野心。

老黄表示,联发科既可以把产品提供给英伟达,也可能自行保留并推向市场。

不过至少在目前看来,黄仁勋依然认为与联发科的合作是一个双赢的结果。

参考链接:

[1]https://www.tomshardware.com/tech-industry/artificial-intelligence/nvidias-usd3-000-mini-ai-supercomputer-draws-scorn-from-raja-koduri-and-tiny-corp-ai-server-startup-suggests-users-just-buy-a-gaming-pc

[2]https://www.theverge.com/2025/1/8/24338939/nvidia-jensen-huang-hints-arm-desktop-cpu

[3]https://www.reuters.com/technology/nvidia-ceo-says-mediatek-will-be-able-sell-nvidias-desktop-cpus-2025-01-07/

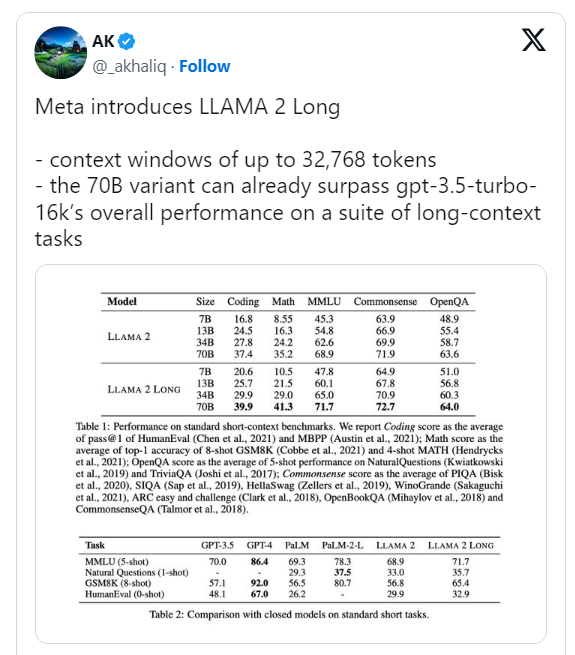

Meta悄然发布Llama 2 Long AI模型

要点:1.Meta发布了Llama2LongAI模型,通过改进训练和编码方法,在某些任务上超越了GPT-3.5Turbo和Claude2。2.该模型使用RoPE编码和强化学习改进,提高了在编码、数学、语言理解等任务中的性能。3.文章还讨论了AI驱动的恶意机器人对网络安全的威胁,强调了数据防御策略和合作的重要性。站长网2023-10-02 10:43:460000AI成CES顶流!大模型定义硬件时代来了

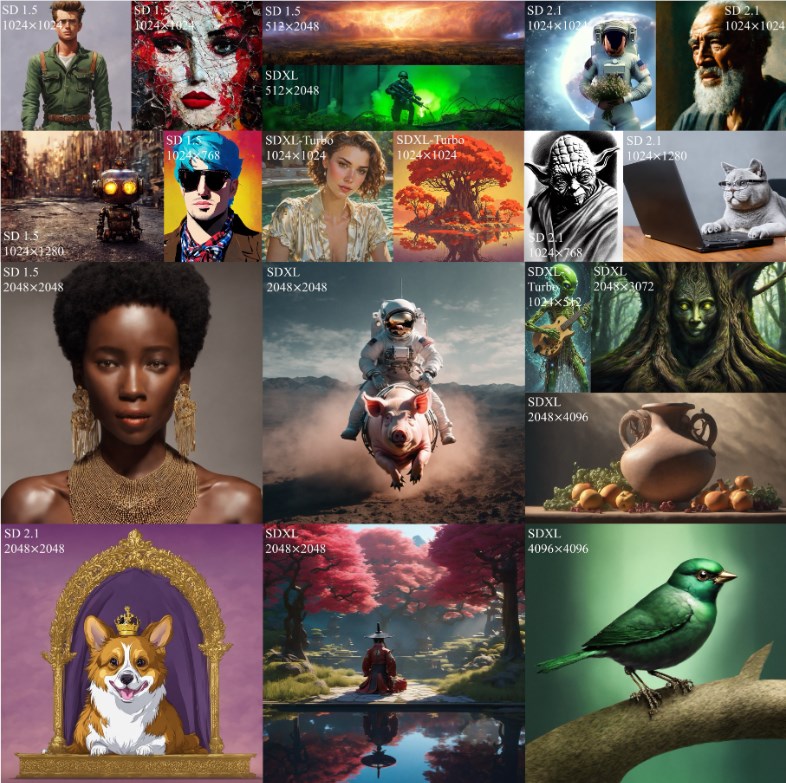

作为全球最大的科技盛会,CES(国际消费类电子产品展览会)无疑是观察科技行业变化最好的窗口。今年也不例外,美国当地时间1月9日~12日,CES在拉斯维加斯迎来了全球超过150个国家和地区的4000余家参展商,参会者超过13万人,其中就有超过1114家中国企业在现场展示新技术和新产品。0000旷视发布HiDiffusion,SD生成速度更快,图片质量更高

最近,旷视发布的HiDiffusion技术,近日引起业界广泛关注。这一新技术只需一行代码,便能显著提升SD(扩散模型)生成图像的分辨率和生成速度,允许图像生成的分辨率高达4096×4096,同时将图像生成速度提高1.5至6倍。值得一提的是,HiDiffusion不仅支持所有SD模型,也兼容SD模型的下游模型,如Playground。站长网2024-04-26 16:17:100000字节复旦团队提出meta prompts 扩散模型图像理解力刷新SOTA

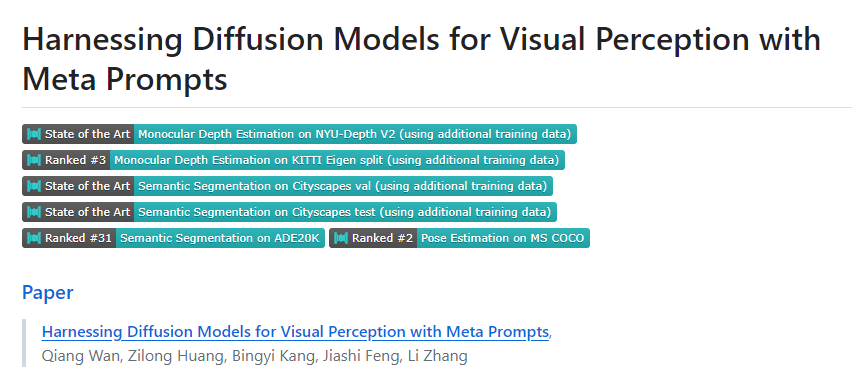

过去一年扩散模型风头正劲,彻底改变了文生图领域!那么,扩散模型能否处理视觉感知任务?字节跳动和复旦大学技术团队在最新研究中提出了一个简单有效的方案。扩散模型在生成高清晰度图像方面显示出了卓越的能力,这一成就得益于其在大规模图像-文本对上的预训练。团队提出了一种利用扩散模型处理视觉感知任务的方案,通过引入可学习的元提示到预训练的扩散模型中,以提取适合特定感知任务的特征。站长网2024-01-16 17:16:250000微软推出全新预训练模型phi-1.5 仅13亿参数常识推理碾压Llama2

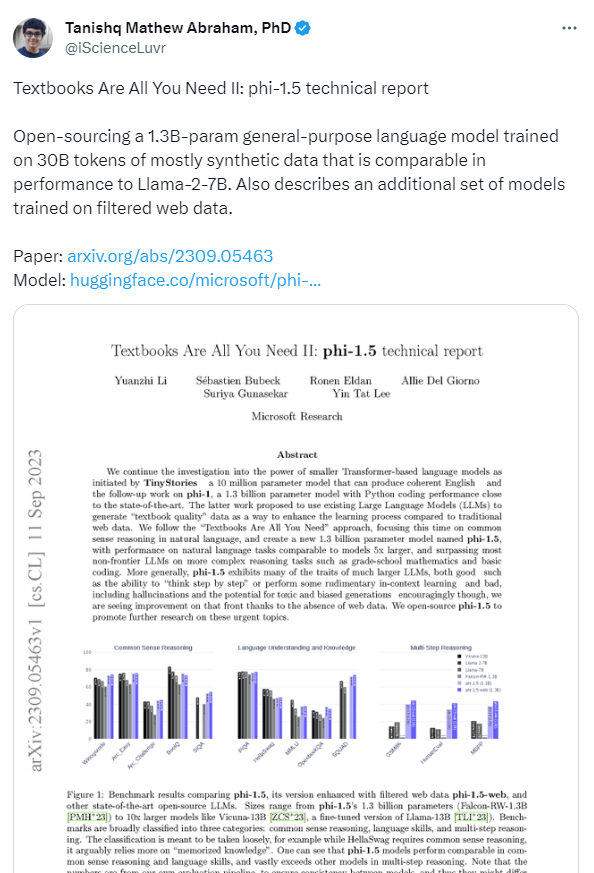

要点:1、微软研究人员推出了一个仅有13亿参数的LLM模型Phi-1.5。2、Phi-1.5在常识推理任务上表现优异,优于多个参数量十倍以上的模型。3、研究表明,模型参数规模不是决定性因素,高质量数据更为重要。微软研究人员最近在一篇论文中提出了一个新的语言模型Phi-1.5,该模型的参数量仅有13亿。研究人员主要关注Phi-1.5在常识推理方面的表现,因为这是对语言模型能力的重要考验。站长网2023-09-18 10:01:440000