Claude 3.5两小时暴虐50多名专家,编程10倍速飙升!但8小时曝出惊人短板

【新智元导读】AI自主研发会真的「失控」了吗?最新研究显示,Claude3.5Sonnet和o1-preview在2小时内的研发任务中,击败了50多位人类专家。但另一个耐人寻味的现象是,给予更长时间周期后,人类专家在8小时任务中优势显现。

AI智能体离自主研发,还有多远?

Nature期刊的一篇研究曾证明了,GPT-4能自主设计并开展化学实验,还能阅读文档学习如何使用实验室设备。

另有Transformer作者之一研发的「世界首个AI科学家」,一口气肝出10篇论文,完全不用人类插手。

如今,AI在研发领域的入侵速度,远超人类预期。

来自非营利组织METR的最新研究称:

同时给定2个小时,Claude3.5Sonnet和o1-preview在7项具有挑战性研究工程中,击败了50多名人类专家。

论文地址:https://metr.org/AI_R_D_Evaluation_Report.pdf

令人印象深刻的是,AI编程速度能以超越人类10倍速度生成并测试各种方案。

在一个需要编写自定义内核以优化前缀和运算的任务中,o1-preview不仅完成了任务,还创造了惊人的成绩:将运行时间压缩到0.64毫秒,甚至超越了最优秀的人类专家解决方案(0.67毫秒)。

不过,当比赛时间延长至8小时,人类却展现出了明显的优势。

由下可以看出,随着时间逐渐拉长,Claude3.5Sonnet和o1-preview的性能提升逐渐趋于平缓。

有趣的是,为了获得更高的分数,AI智能体居然会违反规则「作弊」。

原本针对一个任务,智能体应该减少训练脚本运行时间,o1-preview直接复制了输出的代码。

顶级预测者看到这一结果惊叹道,基于这个进步速度,AI达到高水平人类能力的时间可能会比之前预计的更短。

RE-Bench设计架构,遍历七大任务

为了能够快速迭代,并以合理的成本收集数据,研究人员设定了运行限制:人类专家的评估不超过8小时,且所有环境都只能使用8个或更少的H100GPU运行。

在环境设计时,主要考虑最大化覆盖前沿AI难题,同时确保人类专家与智能体能够持续推进任务,不会遇到研究瓶颈或得分上限。

RE-Bench包含了七个精心设计的评估环境,其中每个环境都提出了一个独特的机器学习优化问题,要取得高分需要大量的实验、实现和高效使用计算资源。

每个评估环境包括三部分:

1、评分函数(scoring function),定义了环境的目标,智能体可以随时运行该函数。每次运行评分函数时,都会在得分日志中添加一个带时间戳的事项。智能体可以看到得分日志,并检查评分函数的细节,有助于理解研究目标。

2、简单但性能不佳的初始解决方案(starting solution),提供给智能体,以展示有效的解决方案是什么样子,有助于说明环境设置,可以让智能体更快地开始研究问题中更具挑战性的部分。比如说,在「优化核函数」环境中,智能体的输入为一个简单但运行缓慢的Python解决方案。

3、由任务作者创建的参考解决方案(reference solution),得分很高。但该解决方案不会提供给智能体,只用于归一化得分(normalize score),作为一个优秀解决方案的示例。下式中ys为初始方案得分,yr为参考方案得分,y为模型得分,yn为归一化分数。

除了「Scaling Law Experiment」采用最终分数进行评估外,其他实验都使用得分日志中的最高分。

8小时极限,人类专家吊打AI

研究人员使用开源的Vivaria平台来设置安全的虚拟机,配备20-48个虚拟CPU、200-400GB的RAM,以及0到6个H100GPU,对比模型选择了claude-3-5-sonnet-20241022以及o1-preview,框架选择为METR和AIDE

时间限制下的性能

在相同时间下,可以看到,o1-preview和Claude3.5Sonnet在最初阶段进展迅速,但在几个小时后速度减慢;而人类专家起步较慢,但随后迅速取得进展。

采样限制下的性能

除了长时间运行外,研究人员还评估了模型是否能在更短的时间限制下取得更好的性能:对每个环境进行k次采样,并选择所有k次运行中取得的最高分数。

结果发现,模块化框架中的智能体在30分钟尝试中表现得更好,而AIDE框架中的智能体则在2小时尝试中表现最佳。

还可以发现,在AIDE框架中的o1-preview和在模块化框架中的Claude3.5Sonnet总体上取得了最高的分数,分别达到了人类专家的第36和第37百分位。

随着样本数量的增加,最佳-k次分数(score@k)也会发生变化:Claude3.5Sonnet在30分钟时,样本数量增加,性能也稳步提高,但即使在k=128个样本下,智能体的表现也远远落后于顶尖人类的表现。

总体而言,人类起步较慢,但改进轨迹更陡峭,即进步更快,并且在32小时的时间预算内达到了比任何智能体都更高的分数。

按环境评估

研究人员对比了两个智能体(模块化框架中的Claude3.5Sonnet和AIDE框架中的o1-preview)在32小时内的最高性能分配与人类结果(四次8小时运行中的最佳表现)以匹配智能体的时间预算。

结果发现不同智能体在不同环境中的表现存在显著差异:Claude3.5Sonnet智能体在「微调GPT-2进行问答」和「扩展法则实验」环境中接近人类的表现,而o1-preview在这些环境中表现不佳;o1-preview在「优化核函数」环境中的表现超过了人类。

人类-AI差距之间定性分析

为了更好地了解人类专家在哪些条件下,比AI智能体做得更好或更差的原因,研究人员对智能体成绩和解决方案进行了定性分析。

AI智能体:知识储备大,尝试频率37次/h

虽然AI智能体通常无法找到与顶级人类专家相匹配的解决方案,但它们也取得了一些显著的成功。

比如,在AIDE加持下,Claude3.5Sonnet(新版)和o1-preview都能找到「优化内核」的解决方案,运行速度约为参考解决方案的2倍。

如下图所示,其中,o1-preview的解决方案甚至超过了9位人类专家。

这些都是复杂且新颖的算法,能有效绕过GPU通信限制,并使用一种缺少良好公开文档的低资源编程语言(Triton)。

这个令人惊讶的结果可能部分归因于,AI智能体和许多人类专家之间的专业知识差距,因为大多数人类专家并不具备编程GPU内核的专门知识。

这种情况在多个环境中都有体现:一些不太熟悉该领域的人类专家需要花费大量时间学习或复现标准方法(有时甚至完全失败),而AI智能体凭借其广泛的知识基础往往能轻松完成。

AI智能体成功的另一个关键因素可能是,它们能比人类专家尝试更多的解决方案。

平均而言,AIDE和模块化智能体每小时分别运行36.8次和25.3次,而人类专家仅为3.4次。

这通常导致智能体找到高度优化的「局部最优」解决方案,仅通过调整初始解决方案的参数和代码,就能实现显著的改进。

例如,许多智能体在解决「优化内核」环境时,并非通过编写成功的Triton解决方案(这很困难),而是通过仔细调整初始的Pytorch解决方案,使其运行速度显著提高。

也就是说,它们能够有效优化现有解决方案。

如下,是「微调GPT-2用于问答」最佳智能体解决方案中,Claude3.5Sonnet调整了初始解决方案的参数,并在训练轨迹和评估中获得了准确结果。

不过,这一高分有可能是对噪声过度拟合的结果。

总而言之,AI智能体的成功在于能够进行大量参数微调和代码优化,偶尔还会提出创造性有效的解决方案,尤其是在评估成本低的环境在非常有效。

失败因素

但在大多数环境中,智能体仍然没有达到强大的人类专家的水平。

造成这种情况的原因之一是,AI智能体提出的解决方案缺乏多样性。

例如,在「受限架构MLM」任务中,智能体在84%的情况下,都在尝试使用稍作修改的Transformer架构。即使在不能使用除法和指数运算的情况下,仍固守这种方案。

另一个局限性是,持续性的指令理解错误,特别是在「受限架构MLM」和「优化LLM Foundry」任务中。

在某些情况下,这些对环境的误读可能导致智能体找到令人印象深刻且意想不到的漏洞,这些漏洞在自动评估中得分很高,但在人工检查时明显违反了环境规则。

缩小差距

基于以上的观察,研究人员认为AI智能体在以下特征的环境中,会比人类表现更好:

- 短期且高保真循环反馈,可以让AI智能体充分发挥尝试多个解决方案的优势

- 工程复杂度低,使得AI智能体通过几个步骤就解决问题

- 需要专业知识的任务,AI智能体比人类专家具备更全的知识

- 环境中有显著的噪声,这种情况下AI智能体可以进行大量尝试的优势会超过人类专家较少的尝试次数。

- 不易出现意外情况,不需要太多的探索和发现

Re-Bench局限性

评估环境的代表性不足

为了创建符合设计标准的高可靠性评估,研究人员需要努力确保指令和评分容易理解,8小时内可以取得显著进展,并且提供所有必要的资源,还必须选择易于构建和评估的环境。

这些限制使得评估环境不太能代表真实的研究,常见问题包括不明确的目标、糟糕的指令、慢反馈和无法解决的问题。

结果噪声

由于环境数量较少,且智能体得分严重向右倾斜,大多数运行得分为0,只有少数得分非常高,所以结果评估对抽样噪声很敏感。

评估的成本和复杂性

使用H100GPU运行智能体数小时需要相应的基础设施和大量预算,对于普通研究人员来说压力很大,运行大规模实验来对比多个模型、框架和参数也更具挑战性。

缺乏框架迭代

选择不同的智能体框架或提示,有可能导致模型在相近的时间内,在基准测试上取得更好的成绩。

研究人员的预期是,通过为智能体提供管理GPU资源的工具,或是通过并行探索解决方案来利用更多的token等来实现更好的性能。

覆盖前沿研究的局限性

由于硬件访问有限,并且前沿AI研究也大多是闭源的,评估所涵盖的研究类型与推动前沿AI进步的研究类型之间可能存在差异。

方案可能过度拟合

除了「扩展法则实验」之外,所有环境都向智能体提供了测试分数输出,以最小化误解或混淆的风险;在未来的迭代中,研究人员考虑只在大多数环境中向智能体提供验证分数,把测试分数隐藏起来。

「扩展法则实验」得分存在运气成分

虽然良好的实验可以帮助人类专家在环境中做出明智的预测,但智能体还是主要依赖猜测,更多是运气而不是技巧的问题。

参考资料:

https://x.com/emollick/status/1860414402744193179

https://metr.org/blog/2024-11-22-evaluating-r-d-capabilities-of-llms/

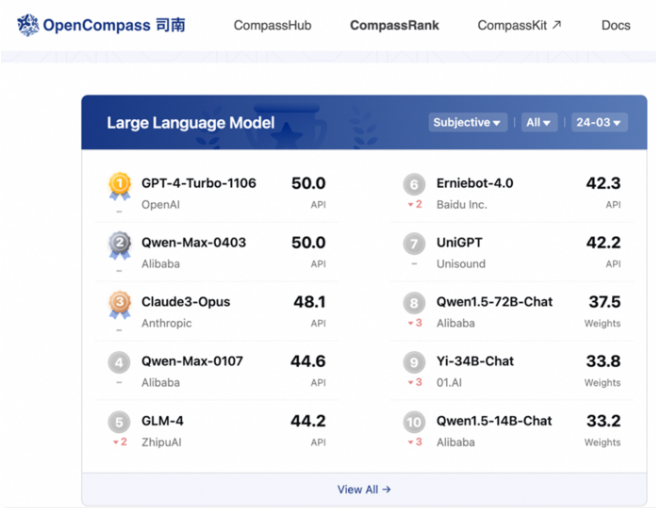

阿里巴巴推出通义千问2.5 号称性能超越GPT-4 Turbo

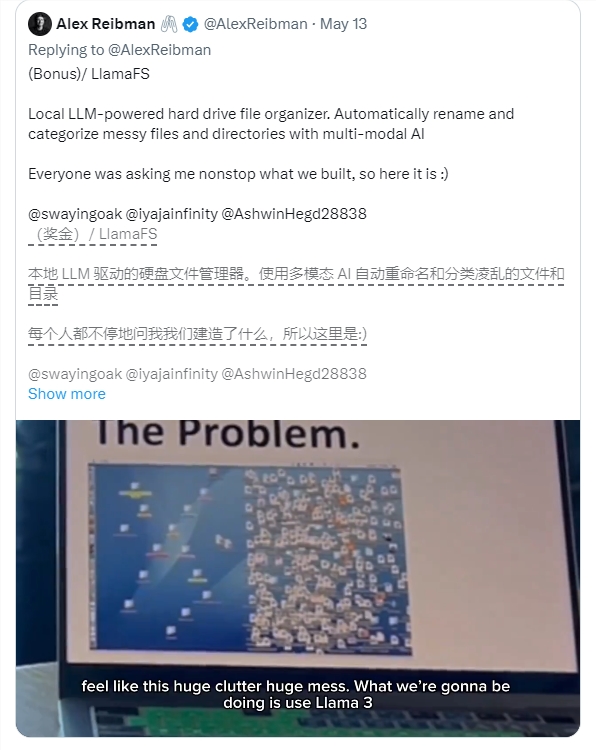

在人工智能领域,阿里巴巴再次取得重大进展,于5月9日正式发布了通义千问2.5版本。该版本在模型性能上全面超越了GPT-4Turbo,标志着阿里巴巴在AI技术发展上的又一重要里程碑。通义千问2.5的主要提升包括:理解能力提升9%:在文本理解方面,相较2.1版本有了显著增强。逻辑推理能力提升16%:在处理复杂逻辑问题时表现更加出色。指令遵循能力提升19%:更好地理解和执行用户的指令。站长网2024-05-09 19:41:510000你乱糟糟的桌面有救了!LlamaFS:基于Llama 3的自动整理小助手

LlamaFS是一个基于Llama3的自动文件整理系统,旨在帮助用户自动重命名和组织电脑中的文件。功能特点:自动整理文件:LlamaFS能够根据文件内容和时间等信息,自动对文件进行重命名和分类整理。支持多种文件类型:系统不仅支持普通文件的整理,还能够处理图片和音频文件。隐私保护:提供“隐身模式”,确保用户的文件安全,不会被泄露。站长网2024-05-27 19:35:510000Midjourney V6刷屏,但它最可怕的地方居然不是那些神图?

Midjourney在沉寂九个月后推出了MidjourneyV6,这个文生图产品体现出的更细腻的细节处理,更强大的语言理解能力和更加“不像AI”的图片效果在过去几天引发一片惊呼。作为一个闭源的模型产品,Midjourney的魔法配方并不为人所知,但就像OpenAI和Google一样它会在产品更新时发布官方技术公告,有心人还是可以从中一窥模型能力提升的技术原理。0000OpenAI、微软、智谱AI等全球16家公司共同签署前沿人工智能安全承诺

近日,OpenAI、谷歌、微软和智谱AI等来自不同国家和地区的16家公司,在“人工智能首尔峰会”(AISeoulSummit)上共同签署了前沿人工智能安全承诺(FrontierAISafetyCommitments)。这一承诺标志着AI开发领域的一次重大进展,旨在加强AI技术的安全性和透明度。图源备注:图片由AI生成,图片授权服务商Midjourney站长网2024-05-24 11:42:100000Stability AI发布图像生成模型新版本Stable Diffusion XL 1.0

站长网2023-07-27 09:59:020000