开发者火冒三丈炮轰GenAI:垃圾语料太多,模型正在变得越来越笨

【新智元导读】人工智能是否早已达到顶峰,正在变得越来越愚蠢?

生成式AI(GenAI),尤其是以OpenAI的ChatGPT为代表,人们发现,这些大模型在一年多后的性能表现远不及刚发布时那样令人惊艳了。

AI似乎正在变得越来越笨。

这种声音逐渐出现在各个社交网络的平台上,并有许多拥趸。

在OpenAI开发者论坛上,有用户发帖表示:自从去年最新版本的GPT发布后,模型的准确性就显著下降了。

同样的,一位ChatGPT的用户在今年6月写道,「经历了这么多的AI炒作之后,这些模型如今的表现让我非常失望。」

Steven Vaughan-Nichols是一位自由撰稿人和技术分析师,在多家科技媒体中担任高级特约编辑。他拥有自己的个人博客,在X上拥有数万名订阅者。

今年8月下旬,史蒂文在《Computerworld》的一篇言辞激烈的评论文章《I’ve got the genAI blues》中表示:

所有主要的公众可访问的AI模型,像ChatGPT和Claude这样的品牌旗舰产品——其性能都不如以前的版本。

文章地址:https://www.computerworld.com/article/3488589/ive-got-the-genai-blues.html

他在文章中写道,「这些由AI生成的结果常常令人恼火。它们有许多荒谬的错误,更糟糕的是,这些错误的出现总是反反复复,没完没了。」

「如果只是答案平庸但相对准确,我还可以想办法应对。但它生成的内容让我无能为力。」

以下是这篇评论文章的内容。

I’ve got the genAI blues

ChatGPT之类的工具远没有你想象的那么好,而且随着时间的推移,它们的表现越来越糟。

我也希望生成式AI真的有用,但事实并非如此。我一直在不断尝试使用各种AI——如ChatGPT、Meta AI以及Gemini等。

这些模型在你不太了解相关领域的情况时,看起来似乎是有用的,它们生成的回答也很合理。

但只要你仔细考察一番,就会发现这些答案是错误的。

如果你对内容的需求仅在高中水平,模型生成的答案还算过得去。但当你需要深入挖掘或研究某个主题时,那就另当别论了。

以我日常的工作内容为例,在Linux和开源软件等主题上,我比一般的大语言模型(LLM)了解得更深入。

在我使用生成式AI对这些主题进行研究时,AI能给出的回答乍一眼看上去可能不错,但你越深入的去讨论一些细节时,它能给出的信息就越贫乏。

这些由AI生成的结果常常令人恼火。它们有许多荒谬的错误,更糟糕的是,这些错误的出现总是反反复复,没完没了。

如果只是答案平庸但相对准确,我还可以想办法应对。但它生成的内容让我无能为力。

这并非仅是我一个人的看法。

《商业周刊》报道,许多GPT-4的用户发现它变得越来越「懒」和「愚蠢」。

其他人也对此表示认同。

正如最近在Reddit上的用户所说的那样,「现在ChatGPT3和4的效果远不如我一年前订阅专业版时那么有效和有帮助。」

在我看来,即使是最好的生成式AI聊天机器人Perplexity也在走下坡路。

以前我喜欢Perplexity的一个原因是它会为其观点提供来源。在我把它看作是一个超级增强的搜索引擎时,这个功能很有用。

然而,最近它的表现也越来越不稳定,我再也无法指望它能够准确地给出它是在哪里找到、并重新整合出的这些信息。

为什么会这样?

虽然我并不是AI开发者,但我密切关注这个领域很久了。

以下是我看到的导致模型开始失效至少两个主要原因:

首先是用于创建主要大语言模型的内容质量问题。

许多模型的训练集中包含了来自诸如Twitter、Reddit以及4Chan等「优质」网站的数据。

正如谷歌在今年早些时候发布的AI概述所显示的那样,采用这些数据集对AI进行训练的结果可能会非常糟糕。

《麻省理工科技评论》同样指出,现在的AI会生成一些质量极差的答案。

如建议用户「往披萨上加胶水」或「每天至少吃一块小石头」,以及「前美国总统安德鲁·约翰逊在1947年至2012年间获得了大学学位,尽管他于1875年去世。」

这类回答都是些无伤大雅的蠢例子,但如果你需要一个正确答案,那就完全是另一回事了。

以一位律师为例,他的法律文件中包含了由AI虚构的案例信息,法官们发现这一事实后并不会被逗笑。

如果你只是想用生成式AI闲聊(这似乎是ChatGPT最流行的用途之一),那么准确性可能对你并不重要。

但对于我,以及所有希望将AI用于商业的人来说,正确答案才是最重要的。

随着生成式AI巨头继续寻找更多数据,这个问题只会变得更糟。

来自Epoch AI的一项研究发现,我们最早将在2026年耗尽高质量数据。

这就引出了第二个问题。

如今,生成式AI生成的内容正在取代专家级人类内容。

结果不仅仅是劣质数据排挤了优质数据,情况还要更为糟糕:

《自然(Nature)》的最近的一篇论文发现,「不加区分地从其他模型生成的数据中学习会导致‘模型崩溃’。这是一种退化过程,随着时间的推移,即使分布没有随时间变化,模型也会忘记真正的底层数据分布。」

我愿将其称为「垃圾进,垃圾出(Garbage In, Garbage Out)」。

但由于我看不到公司会停止使用生成式AI以更低的成本来生成文档,因此未来充斥在互联网中的内容质量只会继续下降。

不管你信不信,就质量而言,我们可能已经处于人工智能的顶峰。

这难道不是一个可怕的想法吗?

当然,我不是一个极端的AI反对者。

基于专用大语言模型的特定用途的生成式AI聊天机器人,在作为排查程序故障或发现潜在癌症的工具时,已经非常有用。

其他的一些用途中,如在线游戏中由AI驱动的非玩家角色,将提高游戏体验,而像ElliQ这样的AI朋友可以帮助很多孤独的人。

但作为大多数公司热衷的替代知识型员工的方式,还是算了吧。

除了CEO——他们倒是可以被AI聊天机器人取代。

我怀疑很多人不会注意到AI CEO与人类CEO的区别——除了它会为公司节省一大笔钱。

生成式AI的未来

这不应该是事情发展的方向。

通常来说,新的版本软件应该比它们所取代的版本更好。

但由于生成式AI需要通过大量数据进行训练,而随着人类世界的高质量内容日益枯竭、互联网越来越多地充斥着AI生成的劣质内容,模型未来的性能表现将会成为一个越来越严重的问题。

当然,我们也有可能会重新发现由人类完成的那些极其珍贵且不可替代的工作的价值。

但最好也别对此抱有太大的希望。

参考资料:

https://futurism.com/the-byte/ai-dumber

深言科技联合清华大学NLP实验室开源LingoWhale-8B模型

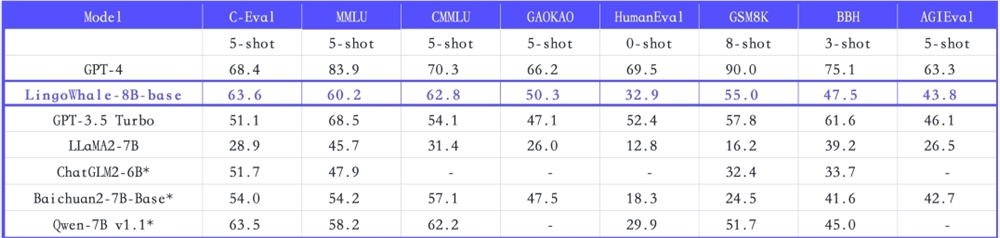

站长之家(ChinaZ.com)11月3日消息:深言科技与清华大学NLP实验室联合开源了LingoWhale-8B模型,这是一种拥有约80亿参数的中英双语大语言模型。该模型在多个公开评测基准上达到领先效果,在10B以下开源模型中表现出色。LingoWhale-8B模型具备强大的基础能力,能够完成各种任务,包括数学计算、代码生成、逻辑推理、对话和知识问答等。站长网2023-11-03 16:29:540000Meta悄然发布Llama 2 Long AI,在某些任务上击败GPT-3.5 Turbo和Claude 2

本文概要:Meta悄然发布Llama2LongAI模型,该模型在某些任务上击败了GPT-3.5Turbo和Claude2。Llama2Long是基于Meta的开源Llama2模型,经过改进后能够更好地处理长文本和复杂任务。Llama2Long的改进主要包括:增加了长文本数据集、修改了位置编码、使用了强化学习。站长网2023-10-03 10:56:140001小红书粉丝最多的品牌号,做对了什么?

最近,因为和中国邮政联名开店,蜜雪冰城又被年轻人疯狂玩梗。在小红书上,蜜雪冰城也主动用了“雪雪我啊,瞒不住了”这样的文案,来回应网友的调侃,单条笔记点赞达到8.7万,加上用户乐意将蜜雪冰城和瑞幸组CP,因此评论区精彩纷呈。“善于玩梗和接梗”的品牌气质,让蜜雪冰城在小红书收获了诸多好评,其开设的两个品牌账号,粉丝量皆位居小红书品牌号头部。@蜜雪冰城小红书笔记截图站长网2023-08-09 20:03:270000【白皮书速览】人工智能医疗器械关键技术——感知技术

来源:【中国医药报】人工智能医疗器械是指基于“医疗器械数据”,采用人工智能技术实现其预期用途(即医疗用途)的医疗器械。感知技术是人工智能医疗器械的关键技术之一。基于医疗器械采集产生客观数据是最主要的感知方式医疗器械使用目的在于能够对某些疾病起到预防、诊断、治疗和监护的作用,对人体样本进行检测等,最终辅助医生更好地治疗病患,直接或间接地作用于人体,采集人体信息,产生具有医疗用途的客观数据。0000为啥电动两轮车长时间骑动力会衰减?张朝阳物理硬核科普

5月9日消息,在近日的《张朝阳的物理课》上,搜狐创始人张朝阳连线绿源创始人倪捷,针对为啥电动两轮车在骑行一段时间后寿命、续航和动力等性能就会出现不规则地大幅衰减的问题进行了解答。据了解,张朝阳和倪捷根据麦克斯韦方程组推导出导线中电子的趋肤效应,其中铜损导致搭载上一代轮毂电机的电动两轮车工作时产生热量并导致永磁体高温退磁,电机的衰退加速影响了控制器、电池等核心部件出现不规则的衰退。站长网2023-05-09 19:40:570000