Meta的Llama-3.1-405B遭泄漏,可下载,性能超GPT-4o!

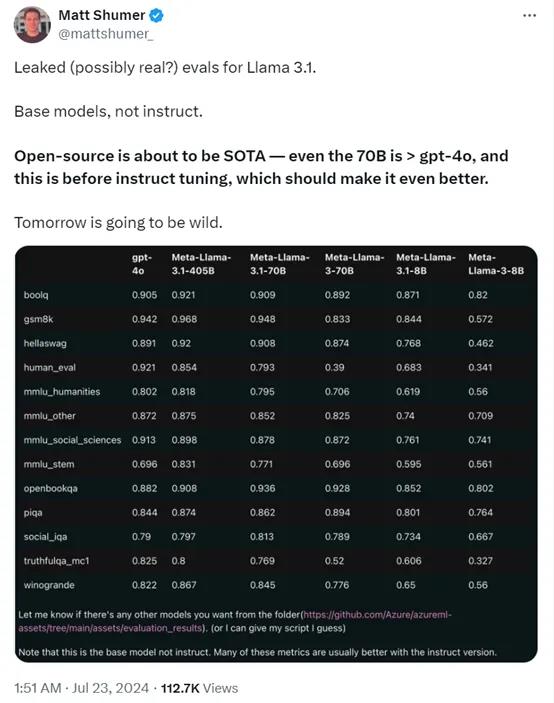

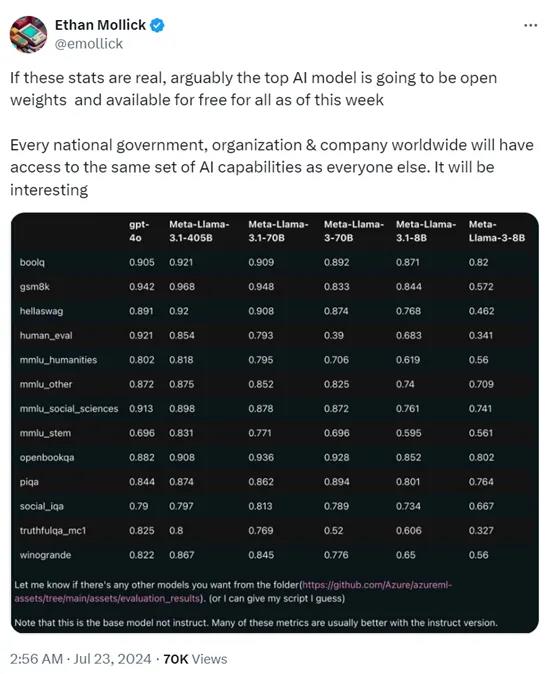

7月23日凌晨,有人爆料,Meta的Llama3.1-405B评测数据遭遇泄漏,明天可能会发布Llama3系列中最大的参数模型,同时还会发布一个Llama3.1-70B版本。

这也是在3.0版本基础之上进行了功能迭代,即便是70B的基础模型的性能也超过了GPT-4o。

就连磁力链接都流出来了,「AIGC开放社区」试了一下大约有763.84G。本来huggingface上也有的,后来库被删除了。

磁力地址:

Magnet: magnet:?xt=urn:btih:c0e342ae5677582f92c52d8019cc32e1f86f1d83&dn=miqu-2&tr=udp%3A%2F%https://2Ftracker.openbittorrent.com%3A80

下载速度也还可以,每秒14M左右,看来确实是有不少人在下这个模型。

但这个模型一般的GPU肯定是跑不起来,如此大的参数在部署方面个人开发者也负担不起(如果你有一些H100也没问题),估计是给企业、政务公共部门用的。

对于Meta即将发布的模型,就有网友泼冷水。相比OpenAI最新的GPT-4o mini版本,Llama3.1-70B推理成本提升了3倍,但编码的性能却要差很多。

从性价比、功能来看,Meta的新模型也没什么值得期待的。

还有人甚至在GitHub上看到了上述发布的模型,但很快就拿下来了,估计有一些人可能已经能使用了。

也有人表示,对于这个泄漏事件他认为是真的,因为这是从微软的Azure Github流出来的。

但是这个模型参数较大,对GPU的要求太高了,不如GPT-4o mini性价比高。

虽然模型是免费的,想运行起来还是相当费劲的,没有企业级的算力基础真的无法使用。所以,这对于企业来说是一个不错的好消息。

有人指出即便对Llama3.1-405B模型进行大幅度优化,量化到5位数,仍然无法适用于消费级GPU,真的是对硬件要求特别高。

如果这份评测数据是真的,那么对于全球多数国家来说都是一个天大的福利。因为这是Meta的Llama3系列的顶级模型并且是全部开放权重,也就是说人人都能用上免费的AI模型。

但是如果想开发生成式AI应用,也需要强大的AI算力基础、高质量数据以及微调技术。

由于监管机构和各种法案的原因,Meta一直在推迟405B系列模型的发布。那么,本次泄漏是否是Meta特意放出来的呢,因为这是他们的老传统了,去年的Llama模型就干过一次,

当时「AIGC开放社区」也测试过,确实就是他的原模型。期待一波明天,看看Meta还能整啥花活。

新西兰媒体公司Stuff禁止OpenAI爬取数据训练ChatGPT

文章概要:1.媒体公司Stuff采取行动,禁止人工智能引擎如ChatGPT使用其新闻内容来学习回答问题和生成内容。2.Stuff首席执行官LauraMaxwell表示,越来越多的新闻机构已封锁OpenAI旗下的ChatGPT,不允许其软件“爬取”信息。3.主要目标是说服OpenAI支付许可费以使用他们的信息。站长网2023-09-11 18:16:390001网信办发布第四批深度合成服务算法备案信息 小米大语言模型算法等在列

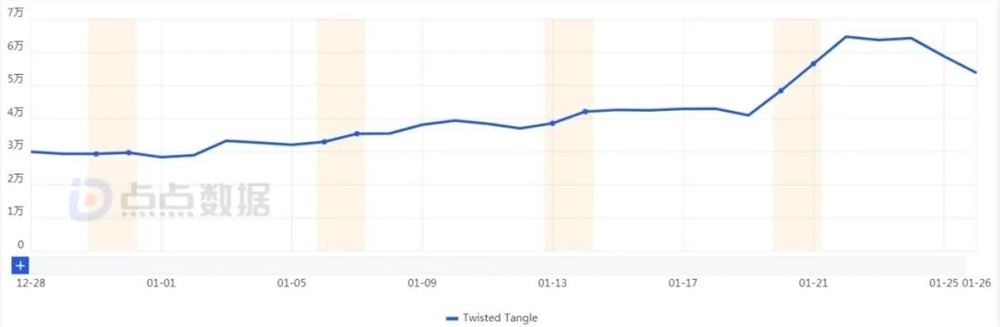

据网信中国公众号消息,今日,国家互联网信息办公室发布第四批深度合成服务算法备案信息。《互联网信息服务深度合成管理规定》第十九条明确规定,具有舆论属性或者社会动员能力的深度合成服务提供者,应当按照《互联网信息服务算法推荐管理规定》履行备案和变更、注销备案手续。深度合成服务技术支持者应当参照履行备案和变更、注销备案手续。网信办表示,请尚未履行备案手续的深度合成服务提供者和技术支持者尽快申请备案。0001一个解绳子的游戏,怎么就迅速千万月流水了?

而最近我们又发现了一款游戏,在没有加重度游戏或者内容的情况下,以简单的游戏机制,博得了百万美金的月流水。一个7年前就火过的题材,怎么就翻红了目前「TwistedTangle」的日流水已经超过5万美元|数据来源:点点数据站长网2024-02-02 14:08:200000国产大模型已无公司可投

大模型创投市场,来到了“无公司可投”的新阶段。创业者想要钱,但新轮次大额融资越来越难;投资人难以寻求合适的标的,看得中的投不上、投得起的看不上。这样的现象既在意料之外,又实属情理之中。万箭齐发小半年,普通人对AI与大模型的使用频率下滑,当激情趋于平缓,就连领头羊ChatGPT的访问量增速都开始放缓。但这个赛道的卷和拥挤远未停歇:站长网2023-08-14 09:22:520000