AI视频新霸主诞生!Dream Machine官宣免费用,电影级大片玩疯

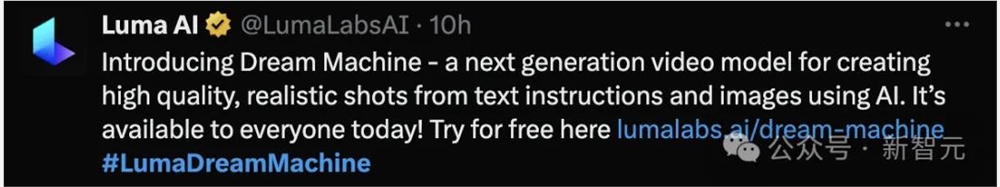

【新智元导读】继Pika宣布上新2.0版本后,视频生成领域又有新模型加入。成立于2021年的Luma AI今天刚刚官宣了文生视频/图生视频模型Dream Machine,而且提供免费使用API,高质量的生成效果获得了很多网友的好评。

视频生成领域,又添一员猛将!

就在今天,Luma AI首发了自己的视频生成模型Dream Machine,可以通过文字或图片生成高质量的逼真视频。

更重要的是,API对全球免费开放!进入官网后用谷歌账号登录即可马上试用。

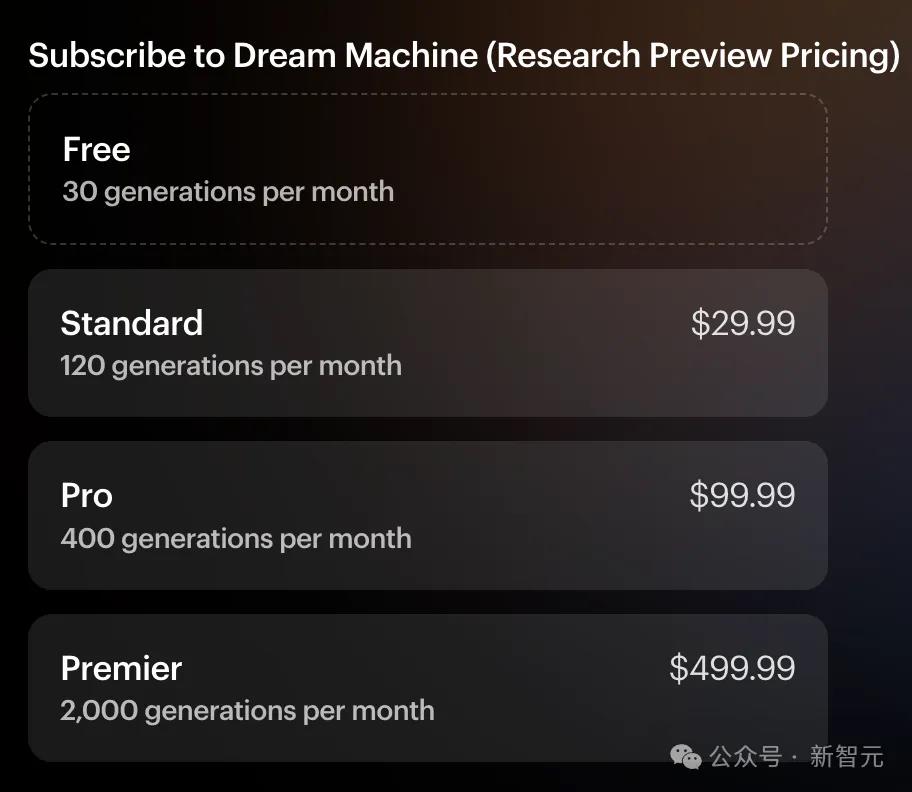

每个用户每月有30次免费生成的额度,但比较遗憾的是,每条视频时长只有5秒。

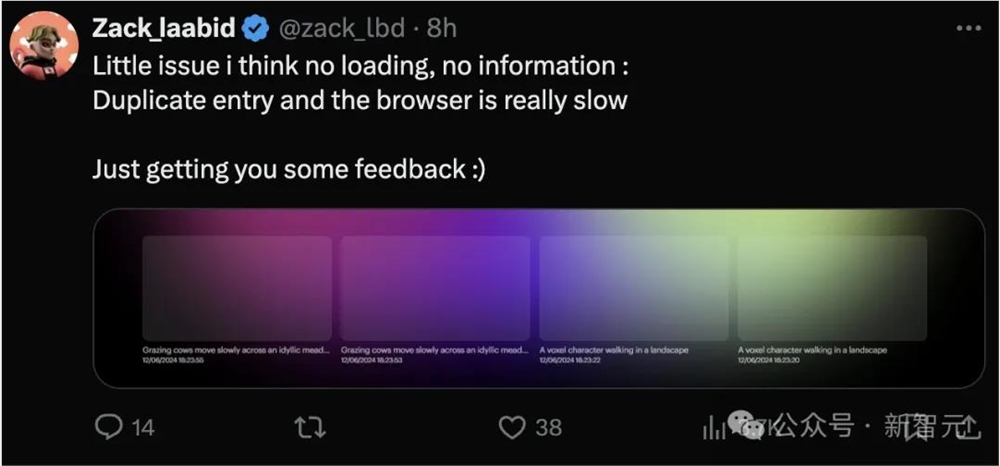

免费试用的消息一出,热情的网友们纷纷挤入服务器,结果发现Luma AI囤的算力好像不够,于是开始了一场漫长的等待。

刚发布后,有些人等了2个小时还没生成出来,Reddit社区中一片怨声载道。

果不其然最后「真香」了,这个视频质量是值得等一会儿的。

接下来,看看这个「造梦机」究竟有多疯狂?

电影级画质,逼真感拉满

官方放出的demo涵盖了各种不同风格和题材的视频,能感觉到最突出的特点就是「电影感」拉满。

不仅有比较好的连贯性,镜头的艺术感也非常不错。

此外,demo还单独强调了一些模型能力,比如生成各种动态以及具有表现力的人物。

不得不说,Luma的审美真的在线,视频中的小姐姐都有一种超模般的「高级美」。

下面这个黑白色调的仰拍镜头,人物动作自然丝滑、一气呵成,裙摆飞起时的幅度虽然有些夸张,但还在可接受范围内。

最重要的是动作符合自然规律,没有出现「手臂融化」、「膝盖外折」这种神奇情况

下面这个demo可以让日漫迷们浅浅兴奋一下,不仅风格对味儿,而且镜头很有意境,可以开始幻想「人均新海诚」了。

比官方demo更精彩的,是各路大神网友们的脑洞创意。

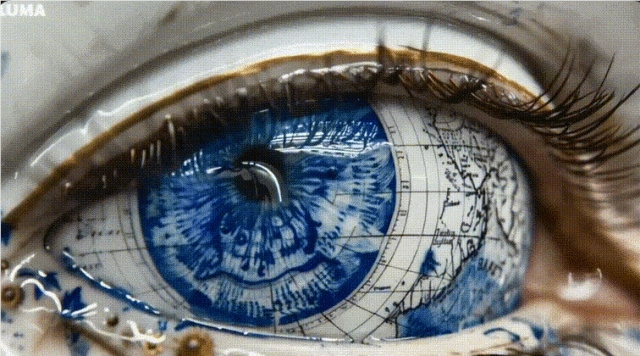

比如在人眼中嵌入一个手绘地球仪。

原本需要几千个高斯点染图的工作,一个Dream Machine就能瞬间完成了。

Sora发布时,很多人惊叹于模型对于光影效果的理解,Dream Machine在这方面的表现也很不错。

这位网友用自己拍摄一张的照片作为提示,生成出来的视频可以延续之前的光感,丝毫不会割裂。

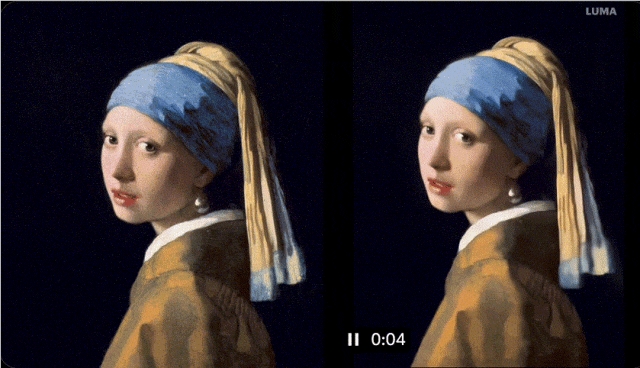

将世界名画《带珍珠耳环的少女》输入给Dream Machine,就可以让艺术史上这位著名模特瞬间「复活」。

但是模型似乎有它自己的想法和审美,比如视频后半段自行更改了模特的相貌和头巾材质,感觉从17世纪的荷兰少女无缝衔接到21世纪T台。

之前在视频生成模型中很少见到的风格,Luma也搞出来了。

比如下面这个demo,狠狠拿捏住了好莱坞老电影的感觉。

提示:意大利黑手党家族站在桌子周围,一边抽雪茄一边数黄金和金钱

但槽点也不是没有,比如香烟的烟雾扩散似乎不够自然,而且没有遵守提示中的「站在桌子周围」(可能是黑手党老大只会坐着吧)。

专业创作者们放出的demo更加惊艳。

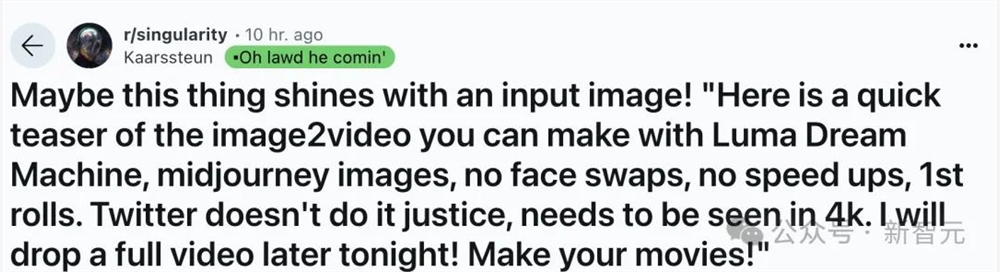

Reddit上放出了一段时长10秒的4K视频,作者用MidJourney生成的图片喂给Dream Machine。

https://www.reddit.com/r/singularity/comments/1decmby/maybe_this_thing_shines_with_an_input_image_here/

没有经过换脸或变速处理,一条很有质感的预告片素材就生成出来了。

虽然主角的表情几乎没什么变化,但环境和皮衣质感的渲染非常到位,五官和额头的皱纹也比较自然。

这位创作者更是重量级,他借助Luma的工具生成了一条超过1分钟的视频,作为自己电影项目的宣传片。

只看视频,你能判断出这里面有AI模型的参与吗?

作为勇敢拥抱AI浪潮的急先锋,这位创作者不仅借助Dream Machine生成视频,还使用Udio制作配乐,「没有什么是比AI视频更颠覆性的时刻了」。

https://x.com/cfryant/status/1800923904439136267

看了这么多demo,有比较严谨的Reddit网友坐不住了。模型都放出来了,应该跑下基准测试吧——

哪个好心人帮忙生成下Will Smith吃面条?

「唯一的真实基准测试。」

已经等不及的小编决定自己动手,成果如下——

没想到Dream Machine虽然不太爱听指令,但还挺有幽默感的。在其他模型中还没见过因为吃不到面条气成这样的Will。

如果输入更详细的指令呢?

面条的形态也很自然,但手指似乎不太对劲,但更明显的问题是,Will吃着吃着居然变脸了。

如果直接将这张图片输入给模型,能否解决变脸的问题呢?

很遗憾,似乎并没有。

AI视频三大王者PK

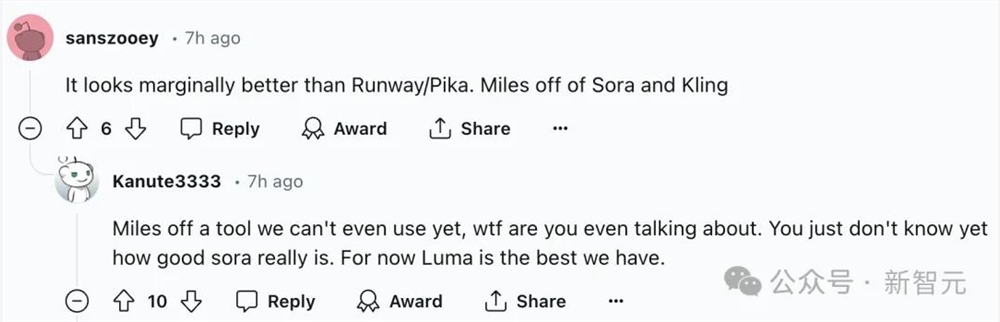

那么相比Pika、Sora等同行竞品,Dream Machine的性能究竟是个什么水平?

有试用者大胆宣称,Luma是目前我们见到最好的模型!

毕竟Sora还没公开,没有人能准确评价其实力。但大家似乎都认同,Luma的表现要优于Runway和Pika。

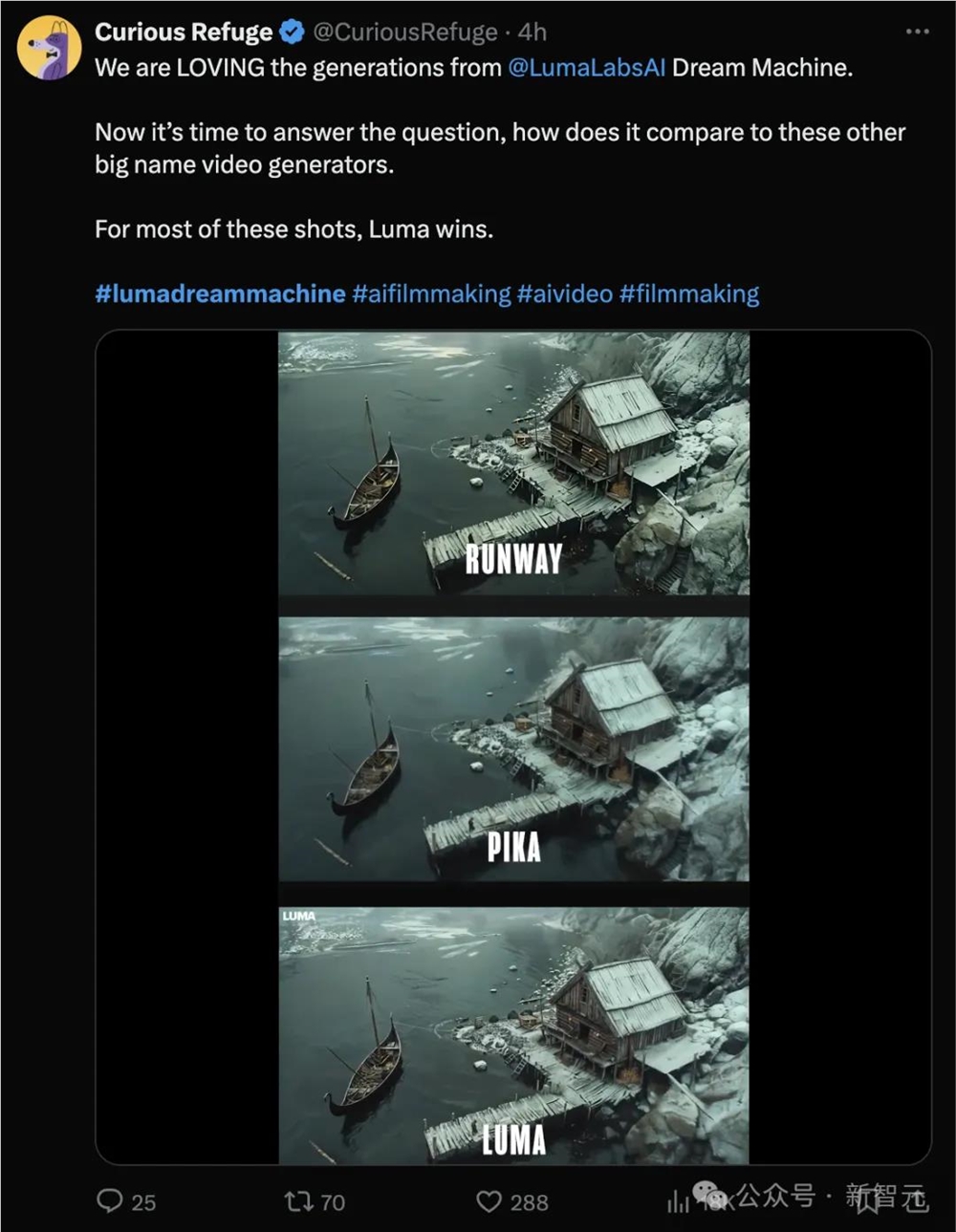

甚至还有Luma真爱粉在推特上直抒胸臆。通过输入相同的提示对比Pika、Runway和Dream Machine三个模型,他认为最终还是Luma赢了。

从完整视频中可以看到,三个模型都可以生成和渲染很高质量的画面。

但Luma模型之所以「电影感」更强,一方面是似乎有更丰富的「想象力」,能脑补出更多表情和动作;

另一方面则是源于更自然的镜头节奏,人物的行动速度适中,既不过快,也不过慢。刚刚发布半天,网上似乎就充斥着对Dream Machine的溢美之词,但这并不代表模型生成的视频已经完美无缺了。

Luma官网上就非常坦诚地放出了很多有缺陷的demo,表明他们今后计划的改进方向。

比如刚才Will Smith吃面条的视频中出现的「变形」,不仅人脸会有,跑车也会有。

更惊悚的是,在水中游泳的北极熊会突然从身后长出另一个头。

此外,其他模型存在的问题,Dream Machine也没能幸免,比如有时会生成错误的文字,或者没能实现想要的动态效果。

而且小编在尝试官方推荐的文本prompt时,还偶遇了模型的「精分」现场。

输入下面这个prompt,可以得到官网同款的惊艳demo:

Low-angle shot of a majestic tiger prowling through a snowy landscape, leaving paw prints on the white blanket

一只雄壮的老虎在雪地中徘徊的低角度镜头,在白色的雪地上留下了爪印

但视频后半段就突然画风一转,不仅虎爪的形态不自然了,变脸的程度甚至达到了「惊悚」级别。

虽然有诸多不足,但是Luma能在官网上坦然放出缺陷demo,并放出了一系列「未完待续」的动图,暗示着下一步的更新很可能就在不久之后。

背后团队,5位华人

发布模型的同时,Luma也公布了模型开发团队的名单。从名字来看,14人中应该有5名华人成员。

其中,Alex Yu是公司联创兼CTO。他毕业于加州大学伯克利分校,曾在Adobe工作,研究方向是神经渲染和实时图形领域。

Yu在2021年毕业后,就和另一位创始人Amit Jain创办了Luma公司。

Jain在学校修读的是物理和数学学位,曾在苹果工作,在3D计算机视觉、机器学习、系统工程和深度技术产品方面有丰富经验。

根据crunchbase的数据,Luma AI已在3轮融资中筹集了6730万美元,最新一轮融资是今年1月9日通过的B轮融资,最新的投资方包括英伟达公司。

参考资料:

https://x.com/LumaLabsAI/status/1800921380034379951

https://www.reddit.com/r/singularity/comments/1decmby/maybe_this_thing_shines_with_an_input_image_here/

https://lumalabs.ai/dream-machine

抖音再不接入DeepSeek就晚了

尚未接入DeepSeek的抖音,刚刚把大门又敞开了一点点。近日,字节剪映的AI视频生成工具即梦被爆出正考虑使用DeepSeek。同时,即梦迎来新的移动端负责人,原零一万物PopAI产品负责人曹大鹏走马上任,向抖音前CEO、如今带队剪映的张楠汇报。0000AI信任缺口引起员工和高管担忧

**划重点:**1.🌐人工智能在职场崛起,带来业务变革和新的工作方式。2.😟高层领导和员工对AI的到来存在焦虑,可能减弱其积极影响。3.👩💼👨💼关键在于高层领导更好地向员工解释AI将如何改变公司和工作。站长网2024-02-04 11:23:280000视频号直播切片授权功能将于7月正式上线

据报道,2022年三只羊网络的直播切片带货收入达到1.7亿元,有超过11000人获得了三只羊网络的切片授权,316个品牌通过切片带货销售额达到了百万元级别;而在2023年,三只羊网络计划让授权账号和人均收入都翻一倍,带货收入有望达到6.8亿元。蝉选旗下的直播切片业务也有类似的规划,计划在2023年实现10亿元的收入。站长网2023-06-29 11:34:520000支付宝小程序云上线“云AI” 支持文字、图片、情绪的智能识别

近日,支付宝小程序云服务又升级了,全新推出文字识别、智能视觉和自然语言处理等3项智能应用功能,让小程序服务商和开发者通过开箱即用的云AI产品,实现全面、便捷、高效的人工智能服务,提高服务效率和用户体验,降低人工成本。站长网2023-11-01 11:35:020000ABB与微软合作,将生成式 AI 集成到工业数字系统中

据ABB中国官微消息,ABB周一表示它将与微软合作,将生成式人工智能功能整合到工业数字系统中。新应用程序GenixCopilot将把AzureOpenAI服务集成到ABBAbilityGenix工业分析和人工智能套件中。站长网2023-07-05 18:20:240001