阿里开源千亿参数模型 Qwen1.5-110B,性能超越 Meta-Llama3-70B

站长网2024-04-28 17:54:540阅

近日,阿里巴巴宣布开源其最新的 Qwen1.5系列语言模型 - Qwen1.5-110B。这是 Qwen1.5系列中规模最大的模型,也是该系列中首个拥有超过1000亿参数的模型。

据悉,Qwen1.5-110B采用了与其他Qwen1.5模型相同的Transformer解码器架构,并引入了分组查询注意力(GQA)机制,在模型推理时更加高效。该模型支持32K tokens的上下文长度,同时仍然是多语言的,支持英、中、法、西、德、俄、日、韩、越、阿等多种语言。

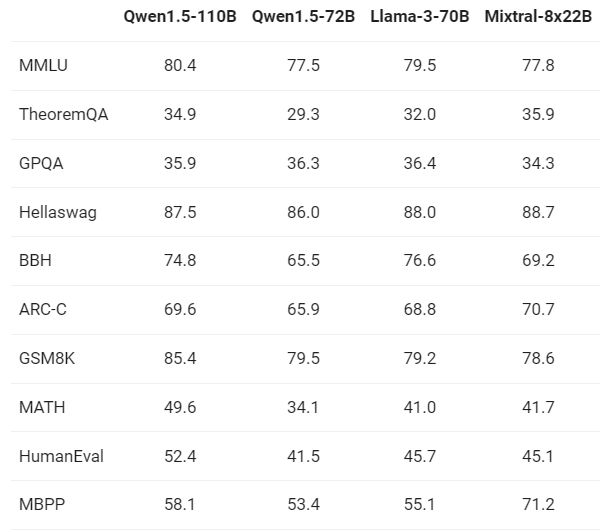

与最近发布的SOTA语言模型Meta-Llama3-70B和Mixtral-8x22B进行对比,结果显示Qwen1.5-110B在基础能力方面至少与Llama-3-70B相媲美。

阿里巴巴表示,与之前发布的72B模型相比,在两个聊天模型的基准评估中,110B模型表现显著更好,这表明即使在没有大幅改变后训练方法的情况下,更强大、更大规模的基础语言模型也可以带来更好的聊天模型性能。

Qwen1.5-110B是Qwen1.5系列中规模最大的模型,也是该系列中首个拥有超过1000亿参数的模型。它在与最近发布的SOTA模型Llama-3-70B的性能上表现出色,并且明显优于72B模型。

0000

评论列表

共(0)条相关推荐

Temu诉Shein:扣留没收商家手机,获取temu账户

12月14日,Temu向美国哥伦比亚特区法院提交了长达100多页的诉讼文件,再诉全球最大的快时尚巨头Shein。具体指控包括,Shein采用“黑手党式”的手段非法留置供应商,盗取平台商业信息,威胁中小商家二选一,向版权机构发起数以万计的虚假恶意投诉,以及滥用美国法律体系扰乱市场等。0000AI女友,很黄很暴利

有人租个女友回家过年,也有人在网上为AI女友付费。AI女友是大模型的产物,她是一个聊天机器人,24小时陪聊,随叫随到,能文字能语音,还能发美照。她可以是对现实或小说中某个人物的角色扮演,也可以是凭空创造出来的一个女性形象,总之不是真人。但因为接入了大语言模型,AI女友能做到语气和表达跟真人一样,还有自己的个性。由于技术日渐成熟,AI女友开始在社交平台泛滥,擦边的黄色生意应运而生。站长网2024-02-20 09:10:4500001000万内最好的SUV!华为问界M9大定单量超2万台

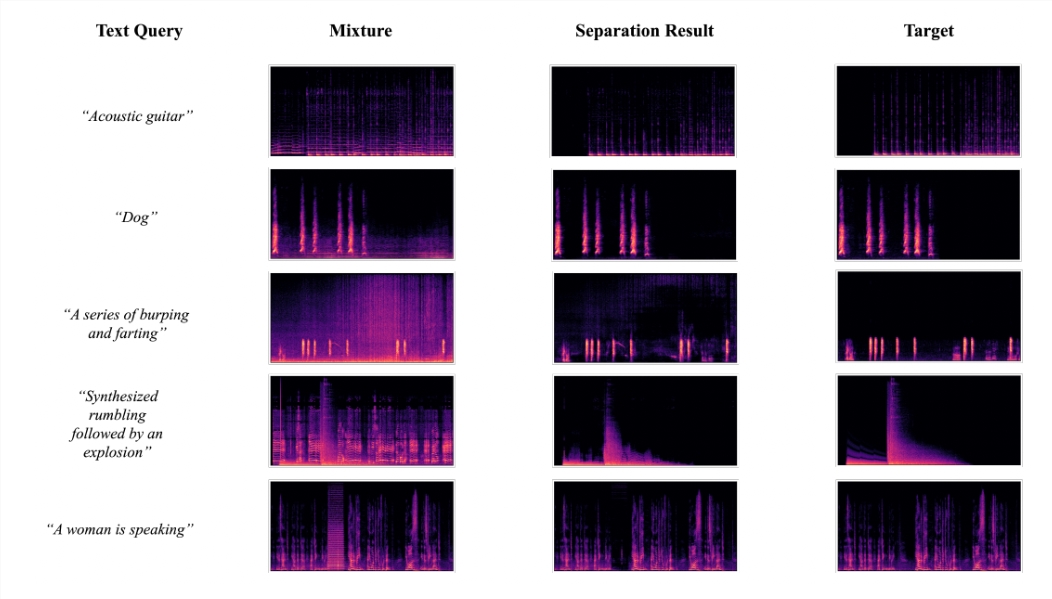

华为AITO问界M9旗舰SUV在发布后短短时间内,累计大定订单量已突破2万台。作为AITO汽车的旗舰车型,问界M9定位于大型SUV,其长宽高分别为5230/1999/1800毫米,轴距为3110毫米,提供5款颜色选择,其中两款为纯色,三款为双拼配色。0000AudioSep:可以从音频剪辑中仅分离出特定的声音

AudioSep是一种AI模型,可以使用自然语言查询进行声音分离。这一创新性的模型由Audio-AGI开发,使用户能够通过简单的语言描述来分离各种声音源。站长网2023-10-27 10:48:250000黄仁勋有望超越马斯克成全球首富 英伟达股价破千美元大关

站长之家(ChinaZ.com)5月28日消息:英伟达近日发布的最新财报成绩斐然,全面超越市场预期,公司市值和创始人黄仁勋的个人财富也随之飙升。财报公布后,英伟达股价首次突破1000美元关口,市值逼近2.6万亿美元,而黄仁勋的身价也高达910亿美元,成为全球第17位富豪。站长网2024-05-28 17:05:080000