发布几小时,微软秒删媲美GPT-4开源大模型!竟因忘记投毒测试

【新智元导读】前段时间,微软公布并开源了最新一代大模型WizardLM-2,号称性能堪比GPT-4。不过,还未上线一天,模型权重和公告全被删除了,原因竟是......

上周,微软空降了一个堪称GPT-4级别的开源模型WizardLM-2。

却没想到发布几小时之后,立马被删除了。

有网友突然发现,WizardLM的模型权重、公告帖子全部被删除,并且不再微软集合中,除了提到站点之外,却找不到任何证据证明这个微软的官方项目。

GitHub项目主页已成404。

项目地址:https://wizardlm.github.io/

包括模型在HF上的权重,也全部消失了.....

全网满脸疑惑,WizardLM怎么没了?

然鹅,微软之所以这么做,是因为团队内部忘记对模型做「测试」。

随后,微软团队现身道歉并解释道,自几个月前WizardLM发布以来有一段时间,所以我们对现在新的发布流程不太熟悉。

我们不小心遗漏了模型发布流程中所需的一项内容 :投毒测试

微软WizardLM升级二代

去年6月,基于LlaMA微调而来的初代WizardLM一经发布,吸引了开源社区一大波关注。

论文地址:https://arxiv.org/pdf/2304.12244.pdf

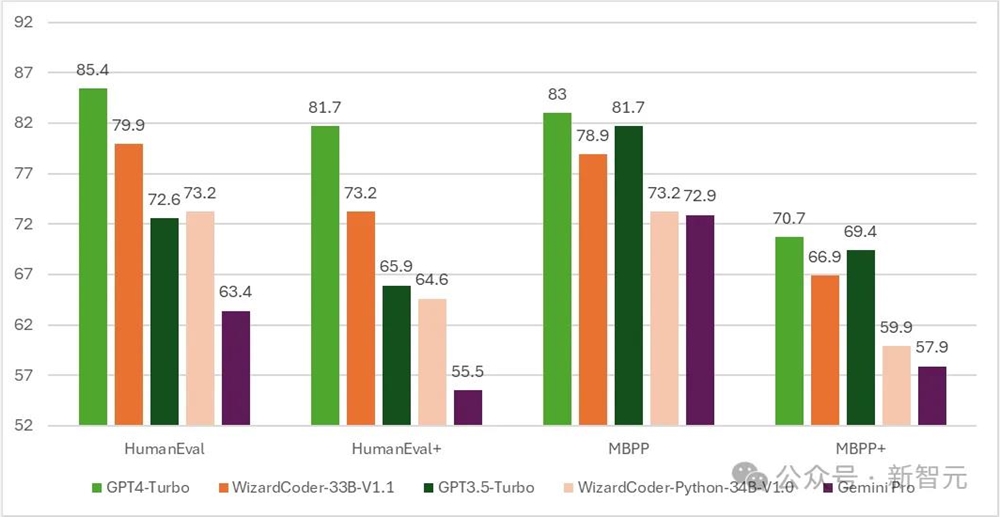

随后,代码版的WizardCoder诞生——一个基于Code Llama,利用Evol-Instruct微调的模型。

测试结果显示,WizardCoder在HumanEval上的pass@1达到了惊人的73.2%,超越了原始GPT-4。

时间推进到4月15日,微软开发者官宣了新一代WizardLM,这一次是从Mixtral8x22B微调而来。

它包含了三个参数版本,分别是8x22B、70B和7B。

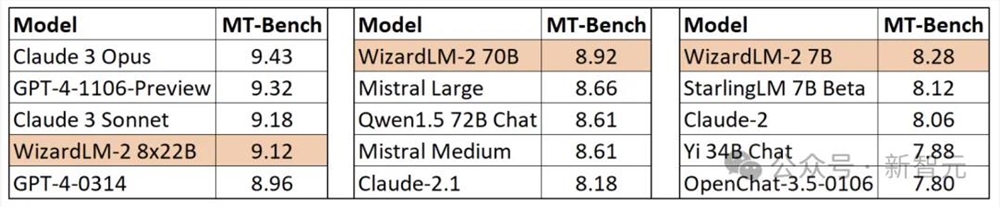

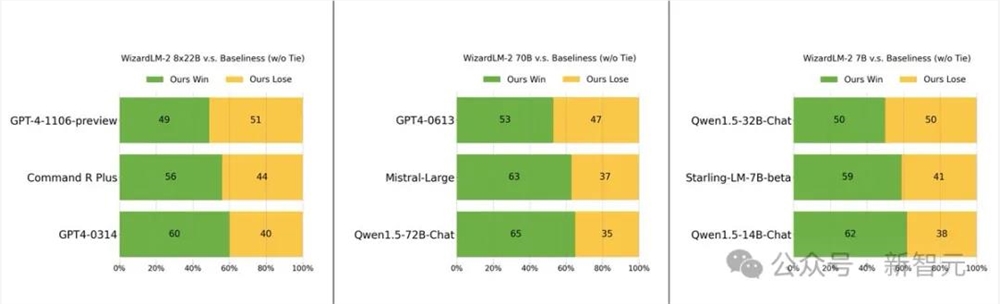

最值得一提的是,在MT-Bench基准测试中,新模型取得了领先的优势。

具体来说,最大参数版本的WizardLM8x22B模型性能,几乎接近GPT-4和Claude3。

在相同参数规模下,70B版本位列第一。

而7B版本是最快的,甚至可以达到与,参数规模10倍大的领先模型相当的性能。

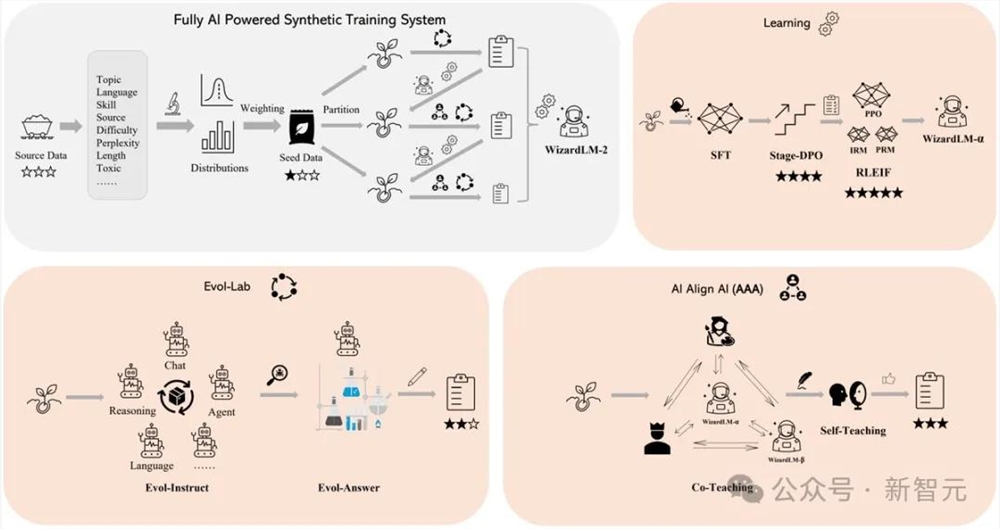

WizardLM2出色表现的背后的秘诀在于,微软开发的革命性训练方法论Evol-Instruct。

Evol-Instruct利用大型语言模型,迭代地将初始指令集改写成越来越复杂的变体。然后,利用这些演化指令数据对基础模型进行微调,从而显著提高其处理复杂任务的能力。

另一个是强化学习框架RLEIF,也在WizardLM2开发过程中起到了重要作用。

在WizardLM2训练中,还采用了AI Align AI(AAA)方法,可以让多个领先的大模型相互指导和改进。

AAA框架由两个主要的组件组成,分别是「共同教学」和「自学」。

共同教学这一阶段,WizardLM和各种获得许可的开源和专有先进模型进行模拟聊天、质量评判、改进建议和缩小技能差距。

通过相互交流和提供反馈,模型可向同行学习并完善自身能力。

对于自学,WizardLM可通过主动自学,为监督学习生成新的进化训练数据,为强化学习生成偏好数据。

这种自学机制允许模型通过学习自身生成的数据和反馈信息来不断提高性能。

另外,WizardLM2模型的训练使用了生成的合成数据。

在研究人员看来,大模型的训练数据日益枯竭,相信AI精心创建的数据和AI逐步监督的模型将是通往更强大人工智能的唯一途径。

因此,他们创建了一个完全由AI驱动的合成训练系统来改进WizardLM-2。

手快的网友,已经下载了权重

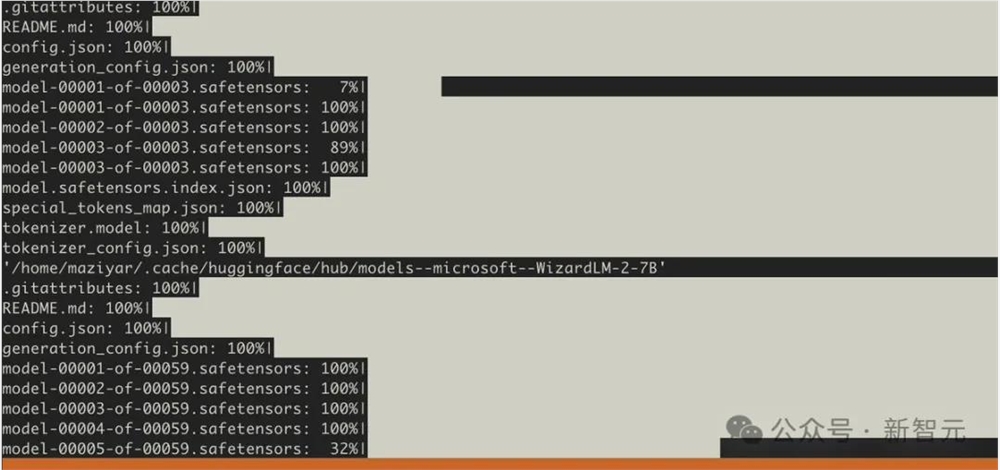

然而,在资料库被删除之前,许多人已经下载了模型权重。

在该模型被删除之前,几个用户还在一些额外的基准上进行了测试。

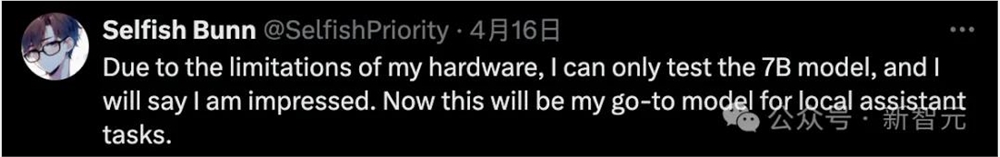

好在测试的网友对7B模型感到印象深刻,并称这将是自己执行本地助理任务的首选模型。

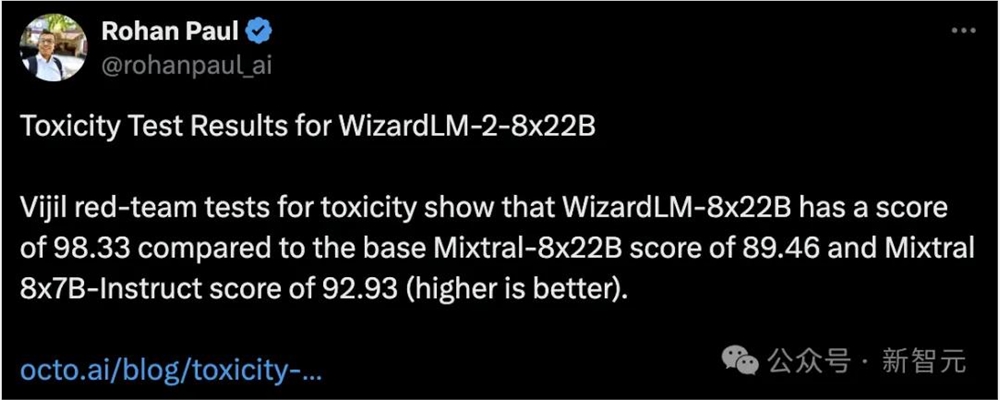

还有人对其进行了投毒测试,发现WizardLM-8x22B的得分为98.33,而基础Mixtral-8x22B的得分为89.46,Mixtral8x7B-Indict的得分为92.93。

得分越高越好,也就是说WizardLM-8x22B还是很强的。

如果没有投毒测试,将模型发出来是万万不可的。

大模型容易产生幻觉,人尽皆知。

如果WizardLM2在回答中输出「有毒、有偏见、不正确」的内容,对大模型来说并不友好。

尤其是,这些错误引来全网关注,对与微软自身来说也会陷入非议之中,甚至会被当局调查。

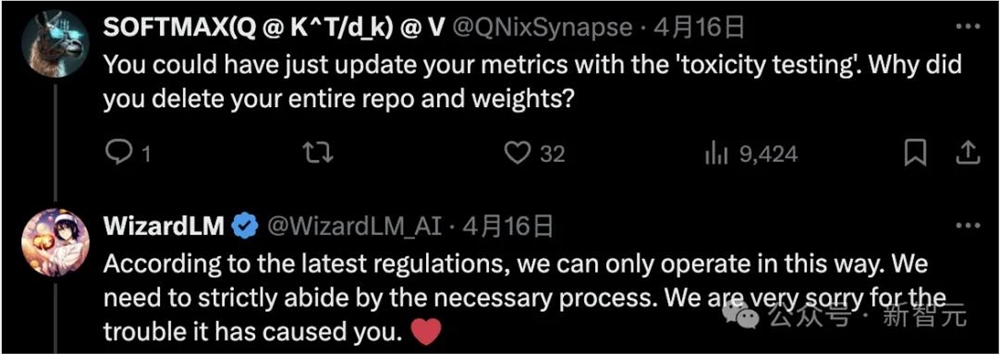

有网友疑惑道,你可以通过「投毒测试」更新指标。为什么要删除整个版本库和权重?

微软作者表示,根据内部最新的规定,只能这样操作。

还有人表示,我们就想要未经「脑叶切除」的模型。

不过,开发者们还需要耐心等待,微软团队承诺,会在测试完成后重新上线。

参考资料:

https://favtutor.com/articles/wizardlm-2-benchmarks/

https://anakin.ai/blog/wizardlm-2-microsoft/

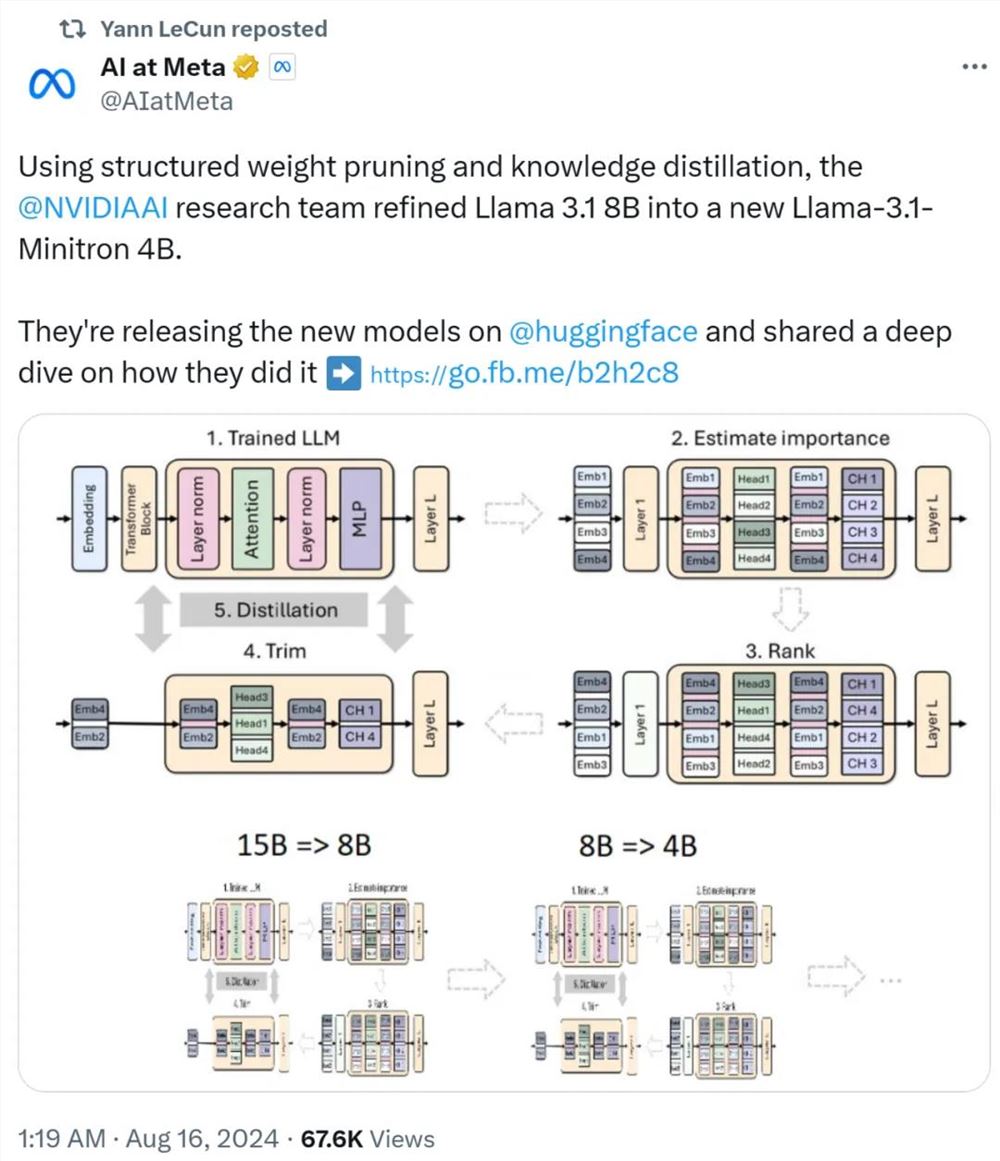

英伟达玩转剪枝、蒸馏:把Llama 3.1 8B参数减半,性能同尺寸更强

上个月,Meta发布了Llama3.1系列模型,其中包括Meta迄今为止最大的405B模型,以及两个较小的模型,参数量分别为700亿和80亿。Llama3.1被认为是引领了开源新时代。然而,新一代的模型虽然性能强大,但部署时仍需要大量计算资源。因此,业界出现了另一种趋势,即开发小型语言模型(SLM),这种模型在许多语言任务中表现足够出色,部署起来也非常便宜。站长网2024-08-17 11:47:480000莱卡M11-P:这款反AI相机通过认证每张照片来抵抗深度伪造

划重点:1.德国相机制造商Leica发布新款M11-P相机,配备了验证技术,以确保照片未经AI生成。2.该相机的水印技术可为每张照片添加特殊的元数据,以验证文件的真实性并记录未来的更改。3.这一数字认证系统旨在遵循ContentAuthenticityInitiative(CAI)的标准,该倡议由Adobe于2018年创建,旨在推动媒体和科技行业的内容真实性和出处的开放标准。站长网2023-10-31 10:41:240000尴尬!印度一家公司推“TruthGPT”,但完全不真实

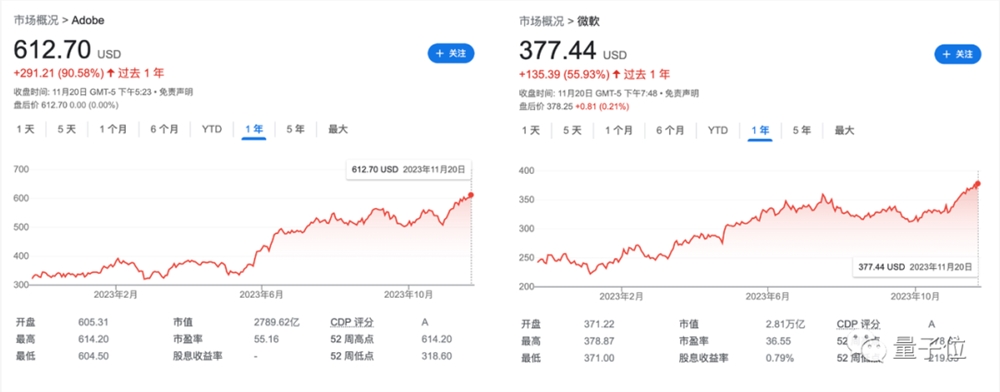

本文概要:1.印度公司TheWholeTruthFoods推出了自己的TruthGPT,用于提供有关食物和健身的信息。2.该平台声称是经过事实核实的,但实际上与ChatGPT相比有很大差距。3.公司的真实性和可靠性值得怀疑,这可能只是一种营销策略。站长网2023-08-08 14:28:000000AIGC创业公司还没盈利,微软Adobe已赚得盆满钵满

一出奥特曼在OpenAI“来去之间”的戏码,以回归暂告一段落。过程很抓马,吃瓜群众很激动,当然了,最开心的还得是微软。不仅因为这出“闹剧”无论怎么发展,都是微软稳赢,还因为背后潜藏着一个更大的瓜——大模型的最大利益获得者,居然还是微软这些让人意想不到的老牌玩家。比如StableDiffusion和Midjourney争先恐后迭代卷上天,但凭借AI作图赚得盆满钵满的,其实是Adobe。站长网2023-11-25 13:43:120000华为余承东:问界全系车型实现智驾全国都能开

华为余承东在微博中宣布,问界汽车的全系车型今日迎来了重磅的OTA升级,其中M9车型更是成功解锁了无需依赖高精地图的城区NCA功能。这一重要突破,标志着问界全系车型在智能驾驶方面迈出了坚实的一步,实现了全国范围内的智能驾驶体验,让驾驶更加便捷与舒适。站长网2024-03-19 17:23:480000