文本直接生成2分钟视频,即将开源模型StreamingT2V

Picsart人工智能研究所、德克萨斯大学和SHI实验室的研究人员联合推出了StreamingT2V视频模型。通过文本就能直接生成2分钟、1分钟等不同时间,动作一致、连贯、没有卡顿的高质量视频。

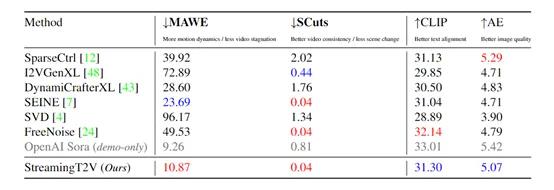

虽然StreamingT2V在视频质量、多元化等还无法与Sora媲美,但在高速运动方面非常优秀,这为开发长视频模型提供了技术思路。

研究人员表示,理论上,StreamingT2V可以无限扩展视频的长度,并正在准备开源该视频模型。

论文地址:https://arxiv.org/abs/2403.14773

github地址:https://github.com/Picsart-AI-Research/StreamingT2V(即将开源)

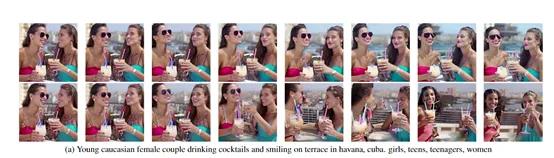

StreamingT2V生成的2分钟视频

传统视频模型一直受训练数据、算法等困扰,最多只能生成10秒视频。Sora的出现将文生视频领域带向了一个全新的高度,突破了诸多技术瓶颈,仅通过文本就能生成最多1分钟的视频。

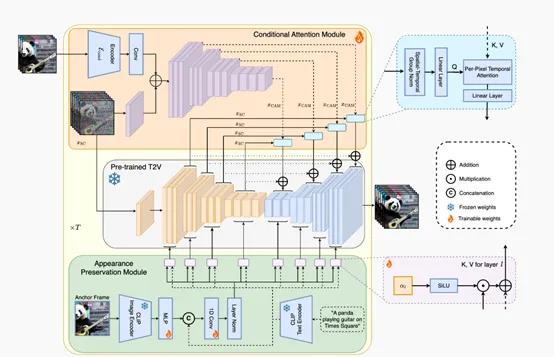

而StreamingT2V采用了创新的自回归技术框架,通过条件注意力、外观保持和随机混合三大模块,极大的延长了视频的时间,同时保证动作的连贯性。

简单来说,StreamingT2V使用了一种“击鼓传花”的方法,每一个模块通过提取前一个视频块中的表示特征,来保证动作一致性、文本语义还原、视频完整性等。

条件注意力模块

条件注意力模块是一种“短期记忆”,通过注意力机制从前一个视频块中提取特征,并将其注入到当前视频块的生成中,实现了流畅自然的块间过渡,同时保留了高速运动特征。

先使用图像编码器对前一个视频块的最后几帧(例如20帧)进行逐帧编码,得到相应的特征表示,并将这些特征送入一个浅层编码器网络(初始化自主模型的编码器权重)进行进一步编码。

然后将提取到的特征表示注入到StreamingT2V的UNet的每个长程跳跃连接处,从而借助前一视频块的内容信息来生成新的视频帧,但不会受到先前结构、形状的影响。

外观保持模块

为了保证生成视频全局场景、外观的一致性,StreamingT2V使用了外观保持这种“长期记忆”方法。

外观保持从初始图像(锚定帧)中提取高级场景和对象特征,并将这些特征用于所有视频块的生成流程。这样做可以帮助在自回归过程中,保持对象和场景特征的连续性。

此外,现有方法通常只针对前一个视频块的最后一帧进行条件生成,忽视了自回归过程中的长期依赖性。通过使用外观保持,可以使用初始图像中的全局信息,从而更好地捕捉到自回归过程中的长期依赖性。

随机混合模块

前两个模块保证了StreamingT2V生成的视频大框架,但是在分辨率、质量方面还有欠缺,而随机混合模块主要用来增强视频的分辨率。

如果直接增强质量会耗费大量AI算力、时间,所以,随机混合采用了自回归增强的方法。

首先,研究人员将低分辨率视频划分为多个长度为24帧的视频块,这些块之间是有重叠的。然后,利用一个高分辨率的视频模型,对每一个视频块进行增强,得到对应的高分辨率视频块。

例如,有两个重叠的视频块A和B,重叠部分包含20帧。对于重叠部分的每一帧,随机混合模块会从A块和B块中各取出一帧,然后对这两帧进行加权平均,生成一个新的混合帧。通过这种方式,重叠部分的每一帧都是A块和B块对应帧的随机混合。

而对于不重叠的部分,随机混合模块则直接保留原始视频块中的帧。经过随机混合后的视频块就可以输入到高分辨率模型中进行增强。

研究人员指出,如果让相邻的两个视频块直接共享完全相同的重叠帧,会导致视频在过渡处出现不自然的冻结和重复效果。而随机混合模块通过生成新的混合帧,很好地规避了这个难题,使得块与块之间的过渡更加平滑自然。

实验数据显示, StreamingT2V生成的1分钟、2分钟长视频,不仅保持了高分辨率和清晰画质,整体的时间连贯性也得到了很大提升。视频中的物体运动姿态丰富,场景和物体随时间的演变更加自然流畅,没有突兀的断层或冻结情况出现。

“文心杯”创业大赛走进第三年:灯塔、沃土和百度的决心

移动互联网与互联网交替之际的2011年,当时有人提出过一个「Solomo」概念——Social(社交)、Local(本地化)、Mobile(移动)。可以想象在拓荒时代,这个概念对创业者的指引性有多强烈,当时人们普遍认为,只要顺着这三个方向去设计产品特性,就能打造出最出色的产品。但这种理解其实有些片面。0000秋招上岸大厂,应届生有多拼?

2023年的大厂秋招临近尾声,求职者几家欢喜几家愁。有人手握5个offer,顶级大厂统统给开了绿灯,掌握了求职主动权。有网友调侃,秋招人的高光时刻,是集齐BAT(字节跳动、阿里、腾讯)。也有人在本次秋招中,至今还没拿到一个offer,在阶段性振作与焦虑、迷茫中徘徊。大厂秋招是每年应届毕业生较早的一批求职机会,能够早早拿到offer,意味着更多选择机会,更能从容应对学业。站长网2023-10-30 09:11:270000京东快递App全面升级:首屏可即时查看在途快递动态

京东快递App近期进行了全面升级,引入了多项新功能和优惠,旨在为用户提供更加便捷、省心和经济的快递服务体验。以下是升级的主要亮点:新增寄件选择:App首页增加了“寄国际”、“寄港澳”和“同城急送”的专属入口,使用户能够轻松下单,满足不同范围的寄送需求。快递动态整合查看:升级后的App允许用户在首屏即时查看在途快递的动态,并通过点击运单获得详细的物流信息和预计送达时间,实现实时掌控。站长网2024-07-17 10:58:120000微软发布包含 Copilot 人工智能助手的 Windows 11 大更新

站长之家(ChinaZ.com)11月1日消息:微软于周二宣布开始推出Windows11操作系统的下一次重大更新(即23H2)。新版本包括一个名为Copilot的聊天机器人,与创业公司OpenAI的热门ChatGPT有一些相似之处。站长网2023-11-01 14:28:280000分析师预测:2024年,“过度炒作”的生成式人工智能将遇冷

文章概要:分析师预测,生成式人工智能(GenerativeAI)将在2024年面临“冷水浴”,因与其相关的成本不断增加。分析师公司CCSInsight指出,生成式AI已经变得“过度炒作”,技术的较小开发者将面临运行成本“过高”的挑战。CCSInsight还预测,由于技术的快速发展,欧盟对人工智能的监管将陷入停滞。站长网2023-10-10 16:44:190000