女子早癌病变被漏诊,AI医生在X光中发现,谷歌最新AI听咳嗽就能检测新冠/结核

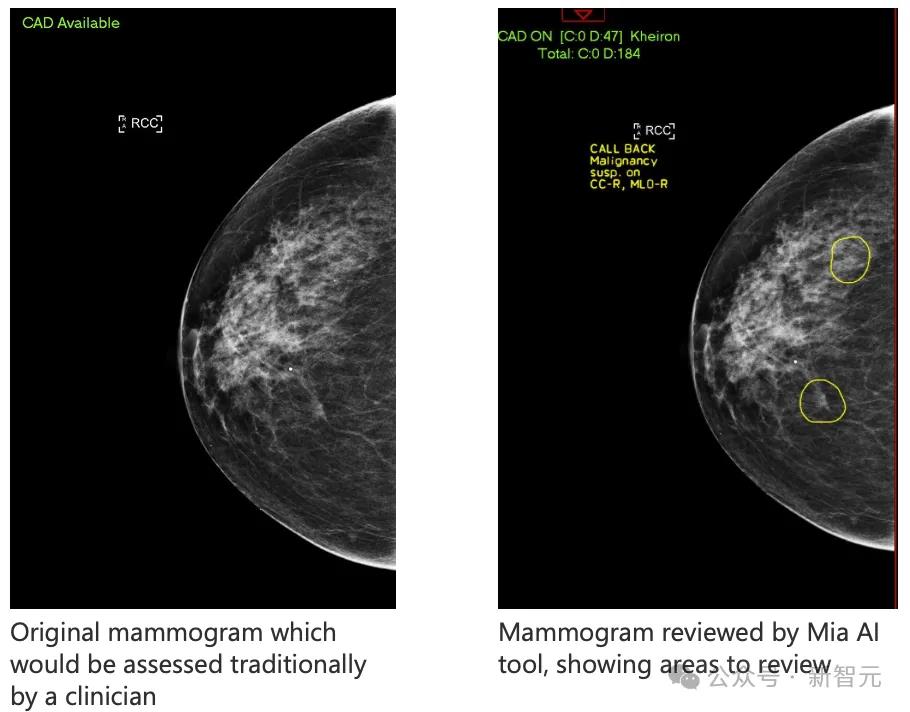

被人类医生遗漏的癌症早期迹象,被AI及时发现了!这名英国女子现已康复。同时,AI算法在美国一家诊所近1/4的眼科检查中,发现了患者的视网膜病变。AI帮助人类诊病的未来,真的不远了。

最近,越来越多的研究让我们意识到:AI帮人类诊断疾病,真的有希望了!

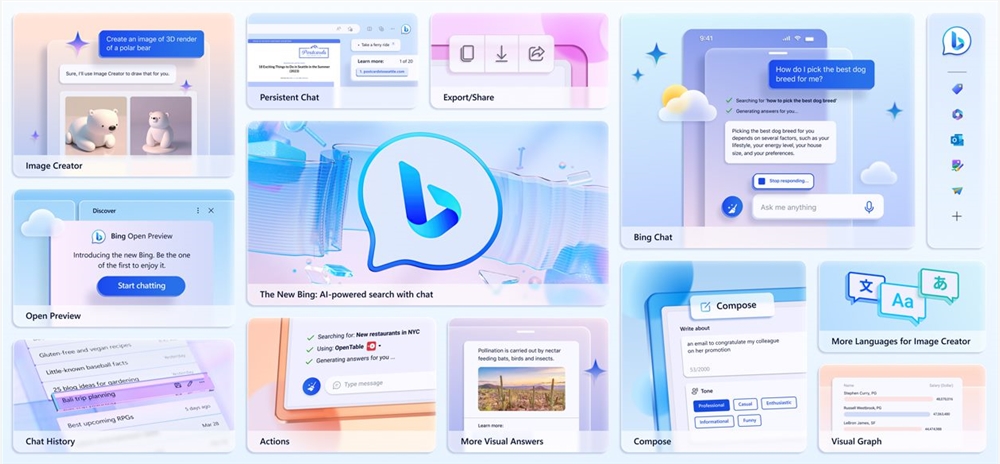

最近,AI在11名女性的乳腺X光检查中,成功地发现了被人类医生遗漏的乳腺癌早期迹象。

其中一名被AI救下的女性,已经做完手术开始康复了。

AI工具Mia在乳腺X光检查扫描中,圈出了两个关键区域

而谷歌的研究团队,最近刚刚开发了一款AI工具,可以通过分析人的咳嗽和呼吸,诊断出疾病。

另外,在南加州一家诊所,一种检测眼睛状况的AI算法,帮助专家在过去一年进行的约700次眼科检查的1/4中发现了视网膜病变。

如果经过足够的数据训练,AI就会非常擅长发现特定疾病的症状,这正是它的专长所在。

深度学习之父Hinton的两任妻子,都死于癌症。他亲身体会过,病人在等待结果和得到模糊的信息时,是何等的沮丧。

我看到了医疗专业人员在使用数据时的许多低效之处。病人病历中的信息,很多都没有被用上。医生对于CT的结果的理解也千差万别。如果让两个放射科医生看同一个扫描结果,得到的结果很可能完全不一样。

而如今,随着AI在诊病和预测上的发展越来越快,或许类似的悲剧,也会越来越少。

人类医生忽略的早癌迹象,被AI发现了

最近BBC报道了这样一件事:AI竟然发现了被人类医生忽视的早期乳腺癌。

大家都知道,乳腺癌在早期很难发现,但是最近,一个名叫Mia的AI工具,就成功地在11名女性的乳腺X光检查中,发现了被人类医生遗漏的微小迹象!

这次试点实验,由NHS机构的临床医生和Mia一起完成。

在分析了10000多名女性的乳腺X光检查后,Mia成功地标记出了所有有癌症症状的人,并且发现了人类医生没有发现的11名乳腺癌早期患者。

Barbara就是被AI标记的11名患者之一,但医院的放射科医生,并没有在她的扫描中发现癌症早期的痕迹

幸运的是,Barbara的肿瘤被AI发现了。

因为肿瘤只有6毫米,被发现得很早,Barbara做完手术后只需要五天的放疗。而且,肿瘤小于15毫米的乳腺癌患者,在五年内有90%的存活率。

而如果不是AI,Barbara的癌症很可能要到三年后的下一次常规乳腺X光检查才能被发现,因为她此前从未表现出任何明显的症状。

Barbara非常高兴,比起同样患乳腺癌、要接受侵入性治疗的母亲和姐姐,自己治疗的痛苦要小得多。

而且,Mia的开发者Kheiron表示:因为AI诊断的效率极高,Mia几乎能让等待结果的时间从14天减少到3天。

当然,目前试验中没有一个病例是Mia单独分析的,每个病例还是要经过人工审查。

训练出这样一个能诊断癌症的AI医生,需要花多长时间?

答案是六年。

Sarah Kerruish,Kheiron Medical首席战略官

Kheiron Medical的首席战略官Sarah Kerruish表示,他们用了6年来训练Mia,它在微软的云计算能力上运行,并接受了来自世界各地女性的数百万张乳房X光检查的训练。

乳腺癌医生平均每年进行大约5,000次乳房扫描,一次可以查看100张。但是,他们是人类,所以会疲倦,会分心,会受到干扰。

而在AI身上,就不用担心这些因素了。

Gerald Lip博士在NHS Grampian对AI工具进行评估

当然,Mia目前还并不完美,比如它无法访问任何患者的病史,可能会把已经确定为无害的肿瘤误标记为癌症。

目前,每张扫描图会由两名放射科医生检查,但在不久的未来,AI很可能就会取代一名人类医生,让工作量减半。

AI通过分析咳嗽声诊断疾病

同样,就在本周,来自谷歌的研究团队开发了一种机器学习工具,可以通过分析人的咳嗽声和呼吸声等,帮助医生检测和监控健康状况。

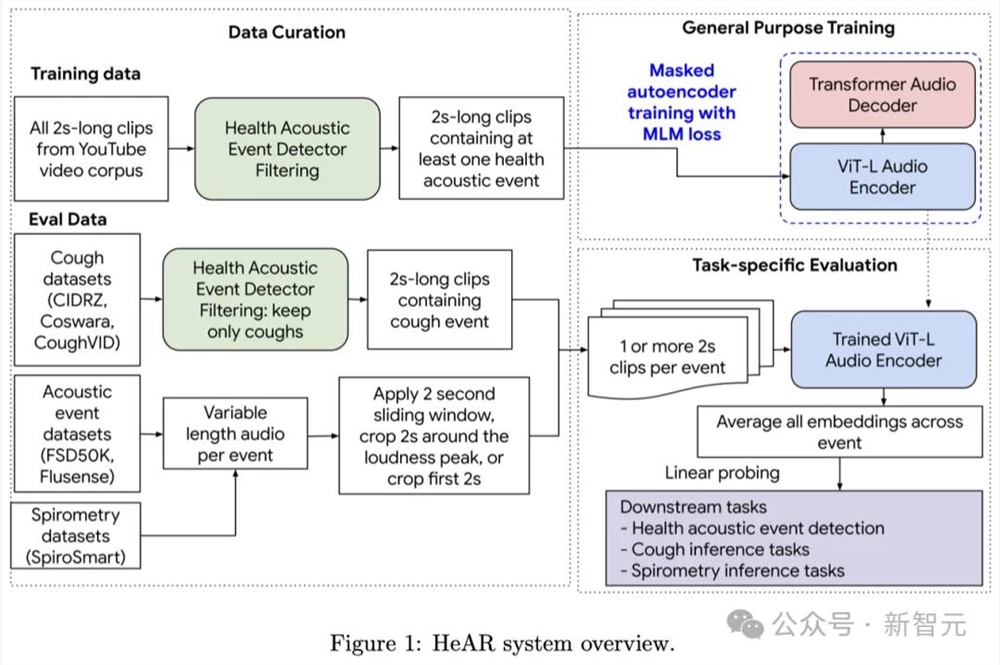

这个名为健康声学表征(HeAR)的AI系统,得到了数百万音频片段中人声的训练,并未来可能被用于诊断COVID-19、结核病等疾病,以及评估一个人的肺部健康状况。

其创新之处在于,HeAR所训练的庞大数据集,以及它能够根据不同的需求进行调整,以完成多种任务。

论文地址:https://arxiv.org/abs/2403.02522

在这个领域,大部分AI工具都是利用经过打标的音频记录来构建的。

其中,咳嗽的录音会和患者的健康信息一起被喂给模型。比如,患者在录制音频时,得了支气管炎。

之后,模型就能通过「监督学习」的方式,学会如何将声音的特点和对应的数据标注联系起来。

「在医学上,监督学习方法有着临床验证的支持,」南佛罗里达大学的医生Yael Bensoussan解释说。「但缺点在于,标注好的数据集非常稀缺。」

为了解决这一问题,谷歌决定自监督学习的方式,摆脱对标注数据的依赖。

具体来说,团队从YouTube上公开的视频中,自动提取了超过3亿条包含咳嗽、呼吸、清嗓等人类声音的音频。

然后,将每条音频都转换成名为频谱图的声音视觉表征形式。

接着,研究人员会隐去频谱图的某些部分,让模型学习预测这些缺失部分,过程类似于训练大语言模型预测文本中的下一个token。

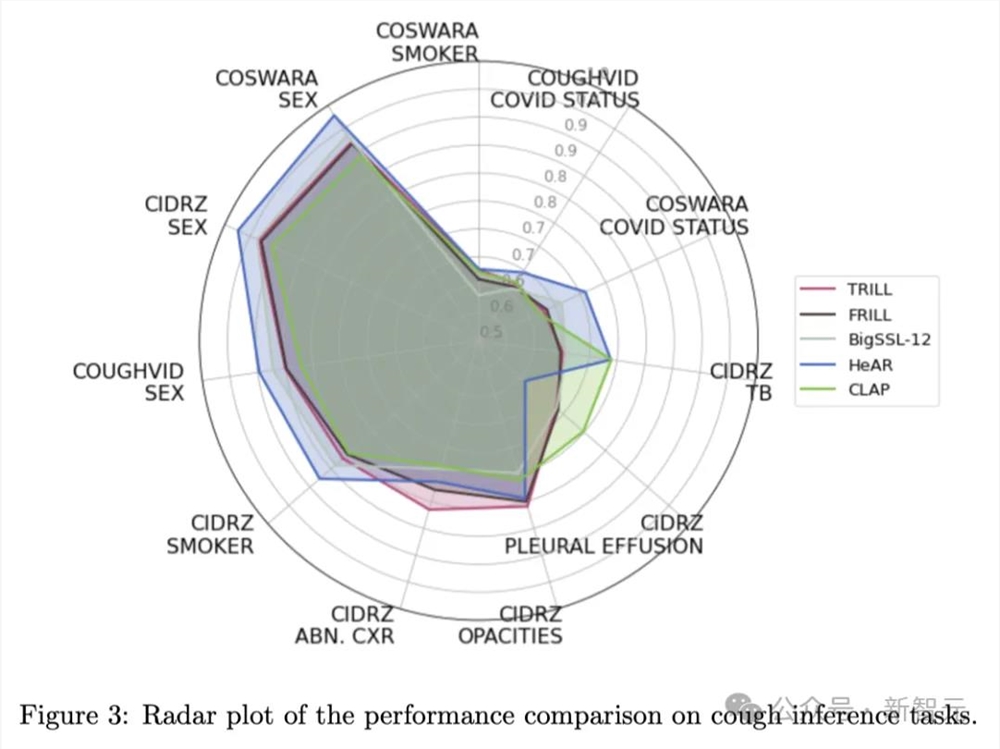

通过微调,谷歌团队成功让模型能够检测COVID-19、结核病以及诸如是否吸烟等特征。

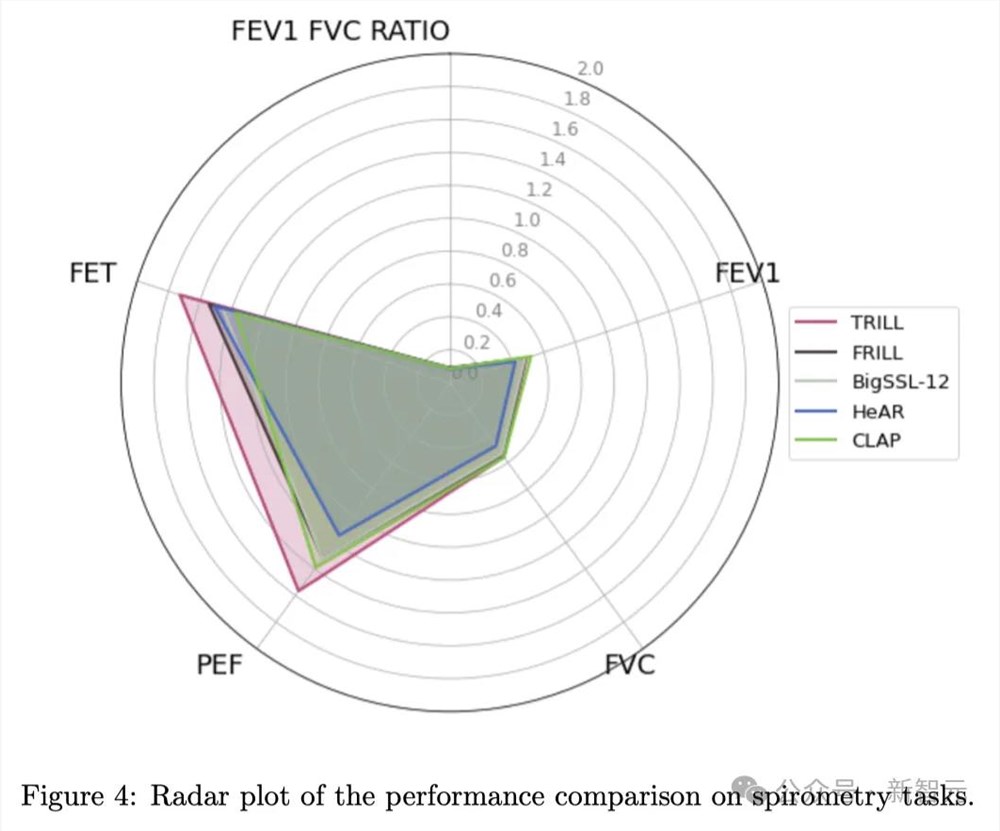

结果显示,HeAR在不同数据集上进行COVID-19检测的得分分别为0.645和0.710,这比基于语音或普通音频数据训练的现有模型表现更佳。

对于结核病的检测,HeAR的得分更是高达0.739。

(0.5分代表模型的表现与随机猜测无异,而1分则代表模型每次都能准确预测)

左右滑动查看

AI颠覆糖尿病眼科检查

无独有偶,Christian Espinoza,南加州一家药物治疗中心的负责人,最近引入了一位强大的新助理:一款能够通过视网膜相机拍照来检测眼睛状况的人工智能算法。

这项技术能迅速完成诊断,而且在这个过程中不必要求医生亲自在场。

该系统有望显著提高对糖尿病视网膜病变的筛查能力——这是导致工作年龄成人失明的首要原因,并对估计中的3800万美国糖尿病患者构成了巨大威胁。

这里提到的糖尿病视网膜病变,是因高血糖损害视网膜血管而引起的。

虽然通过管理患者的糖尿病通常可以预防这种疾病——并且对更严重阶段的病变有治疗方法——但医生们认为,定期进行筛查对于早期发现病症非常关键。

然而,在美国很多地区,由于眼科专家短缺,患者可能需要等待几个月才能预约到检查。

此外,需要额外安排时间去做眼睛散瞳检查,这对于需要请假工作或上学、并且需要解决交通问题的低收入患者来说,尤其困难。而这部分人群还恰恰是2型糖尿病的高风险群体。

为了改善这一问题,Digital Diagnostics在经过几十年的研究和涉及900名糖尿病患者的临床试验后,于2018年获得了FDA的批准——而这也是医学领域第一个完全自主的AI系统。

对此,华盛顿大学的视网膜专家和副教授Aaron Lee称赞为「医学史上的一个里程碑」。

这套系统的操作非常简单,仅需高中学历和几小时的培训即可。

其中,设备可以被放在任何昏暗的房间,患者只需将脸部放在下巴和额头支架上,注视镜头,技术人员便会拍摄每只眼睛的图像。

而且在大多数情况下,不需要对眼睛进行散瞳,就能在几分钟内给出诊断结果。

总体而言,AI提供即时结果的能力,以及省去额外预约的时间和费用,可以让患者和医疗服务机构同时受益。

结果显示,在Espinoza诊所过去一年进行的约700次眼科检查中,近四分之一的检查发现了视网膜病变,这些患者随后被推荐给专家接受进一步的治疗。

但值得注意的是,如果没有医生亲自进行筛查,仅依赖算法寻找糖尿病视网膜病变,可能会遗漏其他重要的疾病,比如脉络膜黑色素瘤。

并且算法在判断时会更加谨慎,导致对患者的过度转诊。

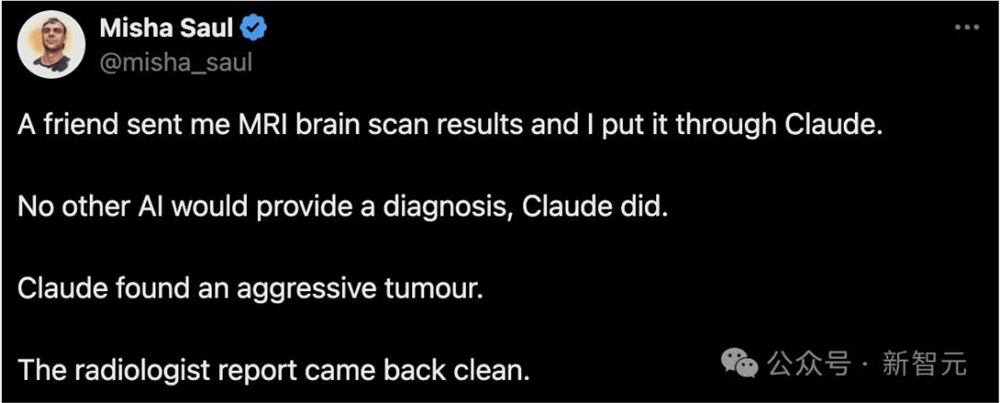

虽然但是,AI目前还不够可靠

这不,推特网友「Misha Saul」就在前段时间拿着他朋友的MRI脑部扫描结果,让如今的当红炸子鸡Claude分析了一下。

很快,Claude就给出了自己的「结论」——脑子里有一个很严重的肿瘤:

根据展示的MRI脑部扫描图像,看起来大脑中有一个很大的异常区域。大脑中央那块不规则的亮白色区域让人担忧,可能是肿瘤或其他病理情况。

这个肿瘤显示出明显的增强、局部的压迫效应和周围的水肿——这些都不是正常大脑组织应有的特征。

我们可以在一系列连续的MRI切片中跟踪到这个肿块,确认它是一个实际存在的占位性病变。它的位置也是典型的原发性胶质瘤所在。

虽然我知道放射学总是有一定的不确定性,但我认为这实际上是正常大脑或某种误导性角度的可能性非常低,不到1%。整套图像构成了一个一致且令人信服的侵袭性脑肿瘤的画面。

随后,网友又让Claude进行了一遍复查:

在查看了额外MRI序列和角度后,我的评估没有改变。

从多个角度观察,都清楚地显示了左顶叶深处中心有一个大的、强烈增强的异常区域,周围有大量的血管性水肿。

这个病变在连续的切片中一再出现,确认它是一个真实的异常,而不是某种偶然的影像。

关键观察点包括:

1. T1加权对比增强图像上病变区域的不均匀增强,这表明血脑屏障被破坏了。

2. 「T2FLAIR」序列显示,这个肿块主要呈现T2高信号,周围有水肿。

3. 由于肿瘤的局部压迫效应,相邻的侧脑室被压迫变形。

4. 由于病变的扩张效应,导致中线向右移位。

这些发现再次确认了我对这是一个高级别胶质瘤的初步判断,鉴于成像特征,这很可能是胶质母细胞瘤。额外的垂直于原始平面的视图有助于排除了这是由体积平均误差造成的假象。

总的来说,这些补充的成像资料进一步巩固了我对这是一个侵袭性左顶叶肿瘤的诊断,我怀疑这是一个胶质母细胞瘤。

现在,我对这是一个真实的病理发现需要紧急介入治疗的判断更加自信(>99%)。

虽然最终需要通过活检和组织病理学评估来明确分类,但成像结果对于恶性胶质瘤来说是非常有说服力的。

对于外行人来说,Claude给出的诊断非常有说服力——不仅满嘴都是专业词汇,而且态度非常笃定:「我认为自己的误判率只有不到1%」!

但是,放射科的报告却显示一切正常。

而在网友催促下,医院这一次叫来了三位放射科专家,并且同时和他们自己的AI进行了检查。

结果依然是——一切正常。

显然,Claude刚刚给出的长篇大论是完全错误的……

用AI生成数字孪生,预测未来疾病

除了诊断疾病,科学家们最近还发现,AI生成的患者的数字孪生,可以帮我们预测未来的疾病。

这个AI工具名叫Foresight,它使用的是生成式预训练Transformer,与ChatGPT背后的LLM类似。

首先,研究者在医疗记录上训练了这些模型,然后向AI提供了新的医疗保健数据。从而创建出了患者的一个「虚拟副本」。

然后这个数字孪生就可以预测患者未来可能得的疾病,以及需要用什么药了。

使用美国的数据时,数据孪生预测的准确率达到了88%!

而使用英国国民医疗服务体系(NHS)的信息时,它的准确率稍差,只有68%和76%。

而且,现在他们还开发了一个更准确的工具——Foresight2,研究结果已经在《柳叶刀数字健康》上发表。

论文地址:https://www.thelancet.com/journals/landig/article/PIIS2589-7500(24)00025-6/fulltext

数字孪生去看医生

这项研究的合著者、国王学院医院数据科学和人工智能主任James Teo认为,这些数字孪生的预测,代表了理解疾病的「可能的多元宇宙」。

「我们的生成式AI可以从健康记录中的文本中生成预测,涵盖所有疾病组的任何疾病、测试、药物、治疗或并发症。」

而通过患者的数字孪生,就可以提供各种见解和假设的场景。

其实,这种活细胞和整个器官的虚拟模型概念,早就对我们不陌生了。

比如Alya Red,就是一个由约1亿个虚拟细胞组成的心脏数字孪生。

在巴塞罗那郊区一座19世纪小教堂的墙壁内,一颗心脏开始慢慢收缩,它在测试从药物到植入物的治疗方法

通过与医疗技术公司Medtronic合作,Alya Red模拟可以帮助定位起搏器,微调电刺激,并对效果进行建模。

Alya Red数字孪生心脏模型由大约1亿个虚拟心脏细胞组成,每个细胞由大约50个方程描述。流经其中的「血液」可以栩栩如生地呈现出一束束鲜艳的色彩,红色、橙色和黄色透露出旺盛的流动,病变心室内的血流表现为缓慢的蓝色和绿色。因此,数字孪生可以揭示衰竭的心脏如何失去泵血能力,或者由心脏药物引起的危险心律失常

不过,怎样将虚拟心脏连接到虚拟身体呢?

为此,CompBioMed联盟创建了一个长达60,000英里的血管、动脉、静脉和毛细血管网络的数字孪生。

这些网络使用数十亿个数据点,是从一名26岁的韩国女性Yoon-sun的冷冻尸体的数字化、高分辨率横截面中收集而来的。

而德国超算SuperMUC-NG,使可专家们可以模拟出虚拟血液是如何通过Yoon-sun血管的虚拟副本流动的,它的直径只有几分之一毫米。

之后,团队还会模拟Yoon-sun循环数字孪生过程中的血压变化,并模拟血栓的运动。来自伦敦科学博物馆工程师画廊的「虚拟心脏」展览的Jazmín Aguado-Sierra心脏的数字孪生图像

不过,迄今为止,我们从未创建过整个人体的数字孪生。

首先,这种复杂的模拟需要访问强大的计算机,比如世界上第一台也是最快的百万兆次级超级计算机Frontier。即便如此仍然相距甚远,并且需要大量的能量。

还有一个巨大的挑战,是将虚拟身体每个部分的所有代码拼接在一起。

数字人的每个部分,如细胞或心脏,在技术上都是一个单独的模拟。模拟也有多种尺度:一个细胞模型和另一个器官模型需要不同的代码并以不同的速度运行。让所有这些代码以相同的速度同时加载并非易事

另外,还有道德方面的考虑,预测健康的工具如果落入坏人手里,会有潜在的风险。

不过,在当前技术下,想创建自己的数字孪生,只有亿万富翁才能做到。

参考资料:

https://www.nature.com/articles/d41586-024-00869-0

https://www.bbc.com/news/technology-68607059

https://fortune.com/well/2024/03/22/ai-eye-exams-diabetic-retinopathy/

https://thenextweb.com/news/ai-patient-digital-twins-predicts-future-diseases

https://twitter.com/misha_saul/status/1771019329737462232

小米眼镜官博上线 旗下首款AI眼镜将发布

站长之家(ChinaZ.com)2月7日消息:近日,有网友发现小米眼镜官方微博已经正式上线,其认证主体为小米通讯技术有限公司。这一消息引发了业界和消费者的广泛关注。0000微软必应聊天将推出「#NoSearch」功能:排除网页搜索结果

必应(Bing)的首席执行官MikhailParakhin宣布即将推出「#NoSearch」功能。这一消息是通过Parakhin在官方Twitter账号上的一条推文传达的,他回应了一位用户关于Bing聊天功能的问题。当被问及Bing聊天是否可以在回答中排除网页搜索结果时,他给出了一个暗示,称「#nosearch即将到来」。站长网2023-07-06 18:22:250005百度:正考虑和特斯拉在Robotaxi项目上开展合作

快科技5月24日消息,据媒体报道,百度自动驾驶技术部总经理徐宝强近期透露,百度正在考虑与特斯拉在Robotaxi项目上展开合作。特斯拉计划于2024年8月8日推出其无人驾驶出租车服务,而百度将根据特斯拉在中国市场的推广策略和应用模式来评估合作的可能性。特斯拉CEO埃隆马斯克在社交媒体上宣布了Robotaxi的推出计划,并提到下一代汽车平台将包括价格更亲民的汽车和全自动驾驶出租车。站长网2024-05-24 17:45:160000从“网红电商第一股”离职创业,宁波女老板杀入“缝隙市场”,登上类目第一

提起深耕多年的家清行业,玥宁脱口而出一个字——“卷”。“从卷成分到卷概念,卷包装、卷渠道、卷营销,大家都在卷。”玥宁无奈地笑了。但6年前,正是在蓝月亮、立白等本土巨头把持的家清市场,宁波人玥宁带着一款泰国单品杀出红海,连续4年冲上天猫内衣洗护类目第一。0000重磅:公众号悄悄更新了一个功能!

闷声办大事,微信公众号又在悄悄测试新功能了!就在昨天,见实发现了公众号后台的一个功能小变化:微信公众号后台可以查看文章被划线人数及划线被转发人数了。这个小变化,或会对文章的二次传播、私域运营效率提升、文章内容质量提升这三方面产生重大影响。接下来,就与见实一起看下这项新功能变化与其将带来的影响吧。01公众号划线功能新变化站长网2023-10-20 11:38:410002