苹果大模型MM1入场:参数达到300亿 超半数作者是华人

要点:

苹果发布了多模态大型语言模型MM1,参数达到300亿,采用MoE架构,超半数作者为华人。

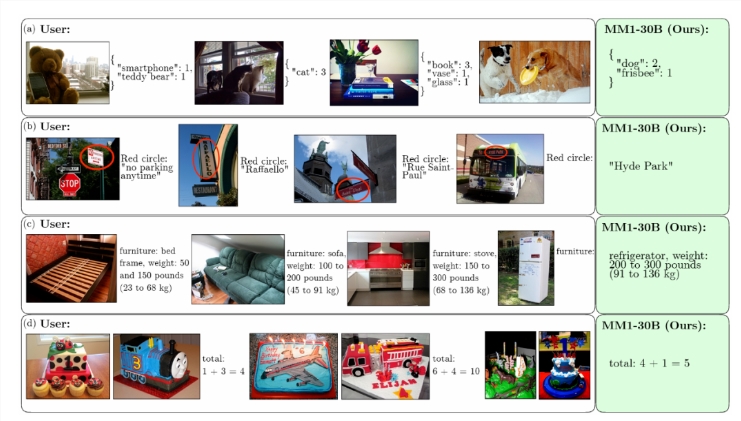

MM1在模型架构、预训练数据选择和训练方法上进行了详细探讨,并在多项基准测试中表现出竞争力。

MM1的预训练和监督微调结果显示,采用不同的数据和训练策略可以获得更好的性能,MoE模型进一步扩展了潜力。

苹果公司最新发布了一款名为MM1的大型多模态基础模型,拥有300亿参数,采用了MoE架构,并且超过一半的作者是华人。该模型在多模态领域具有重要意义,可能预示着苹果未来推出与此相关的产品。

今年以来,苹果明显加大了对生成式人工智能(GenAI)领域的投入,这一举措体现了苹果在GenAI领域取得重大进展的决心。据悉,苹果一部分转向GenAI的团队原本是从事造车项目的,而如今他们也开始投身于GenAI领域的研发工作。

论文地址:https://arxiv.org/pdf/2403.09611.pdf

MM1的发布引起了广泛关注。据论文介绍,该模型采用了MoE变体,并且在预训练指标和多项多模态基准测试上表现出了领先水平。研究者通过多项消融试验,探讨了模型架构、预训练数据选择以及训练程序等方面的重要性。他们发现,图像分辨率、视觉编码器损失和预训练数据在建模设计中都起着关键作用。

在预训练数据选择方面,研究者发现了几个重要经验:交错数据对提高少样本和纯文本性能有帮助,而字幕数据则对提高零样本性能具有重要作用。

此外,纯文本数据对于提高少样本和纯文本性能同样至关重要。通过合理混合图像和文本数据,可以获得最佳的多模态性能,并保留较强的文本性能。研究者还发现,人工合成数据有助于少样本学习。

最终,研究者确定了MM1的最终配方,包括图像编码器、视觉语言连接器和预训练数据的选择。他们还将LLM的大小扩大到3B、7B和30B个参数,并通过专家混合(MoE)进一步扩展了模型。在监督微调实验中,MM1在多项基准测试上表现出了竞争力,并且MoE模型在几乎所有基准测试中均表现优于密集模型。

MM1的发布标志着苹果在多模态领域的重要进展,也为未来苹果可能推出的相关产品奠定了技术基础。该研究的成果对于推动生成式人工智能领域的发展具有重要意义,值得业界密切关注。

Vivaldi 浏览器通过伪装 User-Agent 实现对微软 Bing 聊天的支持

站长之家(ChinaZ.com)6月9日消息:Bing聊天是目前最热门的功能之一。这款由人工智能驱动的聊天机器人利用OpenAI的GPT-4和Bing来回答各种问题和提示。官方正式来说,只能通过MicrosoftEdge浏览器使用Bing聊天。然而,随着Vivaldi浏览器6.1版本的发布,情况有所改变。图片来自Vivaldi站长网2023-06-09 21:54:390001这届双11,奢侈品只配给年轻人凑单

最近,拉夫劳伦的电商员工,可能经历了冰火两重天,店铺商品被人疯狂抢购后,又立刻遭遇了批量退款;范思哲、Burberry、迪奥等品牌,也有相似境遇。这些奢侈大牌,之所以遇上“渣男渣女”,是因为成了网友反向凑单工具;毕竟,价格适合、退款及时、退货方便的美德,很容易得到省钱达人青睐。站长网2023-11-10 09:20:180000好用不贵的五款手机,买来使用五年没有问题

对于大部分用户来说,其实使用手机的需求都比较简单,完全没必要购买四五千的旗舰产品,就算是一款2000元左右的机型,只要你对拍照没有过高的要求,买来舒服使用五年也是没有任何问题的。客观地说,如今的中端手机和旗舰手机最大的差距还是拍照,性能、续航、充电甚至屏幕层面都没有特别大的差距,如果你不是拍照爱好者,那2000左右的手机就足够好用了。站长网2023-05-23 20:18:420000以3D视角洞悉矩阵乘法,这就是AI思考的样子

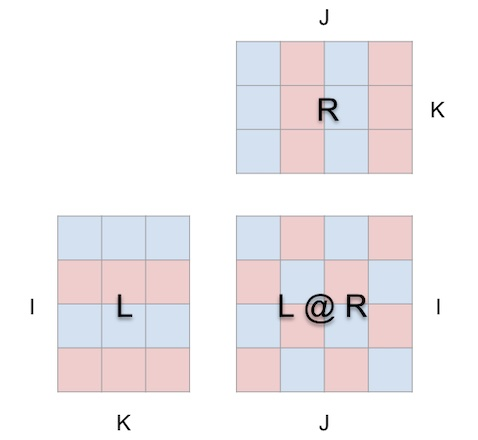

如果能以3D方式展示矩阵乘法的执行过程,当年学习矩阵乘法时也就不会那么吃力了。现如今,矩阵乘法已经成为机器学习模型的构建模块,是各种强大AI技术的基础,了解其执行方式必然有助于我们更深入地理解这个AI以及这个日趋智能化的世界。这篇来自PyTorch博客的文章将介绍一种用于矩阵乘法和矩阵乘法组合的可视化工具mm。站长网2023-10-02 09:51:340002工信部:加快打造从服务器、网络设备到数据加工、数据治理再到人工智能、 模型训练的算力产业链条

在2023中国算力大会新闻发布会上,工信部信息通信发展司司长谢存介绍,下一步,将以本次算力大会和第二届「西部数谷」算力产业大会为契机,在工信部等国家部委的指导支持下,抢抓国家「东数西算」重大机遇,以建设黄河流域生态保护和高质量发展先行区为牵引,努力打造千亿级数字产业集群,使之成为宁夏高质量发展的新增长极。重点是打造好「一群三基地」:站长网2023-07-18 00:04:330001