微软AI研究推数学LLM Orca-Math:通过对Mistral-7B模型进行微调的7B参数小模型

**划重点:**

1. 🚀 微软推出Orca-Math,一款由7亿参数构建的小语言模型,通过对Mistral-7B架构进行微调。

2. 🎓 Orca-Math通过创造性的合成数据集和迭代学习机制,重新定义了教授数学单词问题的传统方法。

3. 📈 Orca-Math在GSM8K基准上取得了显著的成就,展示了SLM在教育挑战中的潜力,提供了创新方法和资源的范例。

微软研究团队引领着教育技术领域的不断创新,近日推出了一款名为Orca-Math的前沿工具,它是一款小语言模型(SLM),拥有7亿参数,并基于Mistral-7B架构微调而来。这一创新方法重新定义了传统数学单词问题教学的策略,彻底改变了学生参与和掌握这一学科的方式。与以往常常依赖广泛的模型调用和外部工具进行验证的方法不同,Orca-Math以其简化而高效的解决方案脱颖而出。

Orca-Math的方法论的核心是一个由20万道数学问题组成的精心制作的合成数据集。然而,Orca-Math的真正巧妙之处在于其迭代学习过程。在模型遍历这个数据集时,它尝试解决问题并获得对其努力的详细反馈。这个反馈循环丰富了偏好对比,将模型的解决方案与专家反馈进行对比,促进了一个学习环境,使模型不断完善其解决问题的能力。

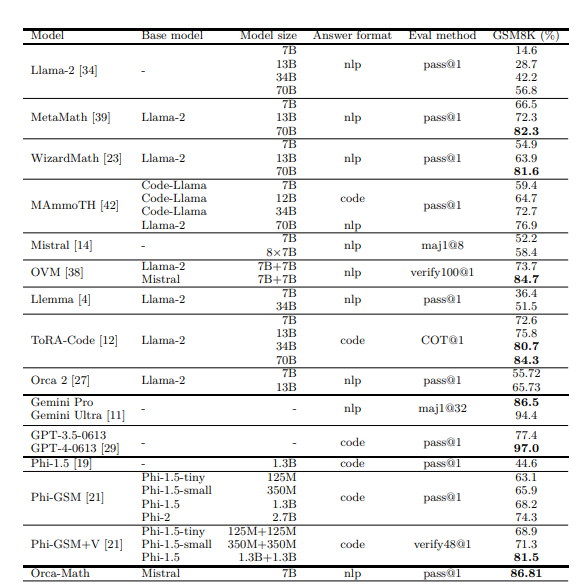

这种迭代学习机制对于Orca-Math的成功至关重要。最初,仅在合成数据集上进行监督微调(SFT)时,Orca-Math展示了令人印象深刻的能力,在GSM8K基准上实现了81.50%的准确率。然而,引入迭代偏好学习将Orca-Math推向了新的高度,使其在相同基准上达到了86.81%的准确率。这些数字代表了在利用SLM解决教育挑战方面的一大步前进。考虑到模型的规模和其高效运行的效率,Orca-Math的成就尤为显著,超过了规模显著更大的模型,并在该领域设立了新的基准。

微软研究的Orca-Math不仅在性能上超越了现有的大型模型,而且还以卓越的效率完成了这一壮举,利用更小的数据集。这一壮举突显了SLM在配备正确方法和资源的情况下的潜力。Orca-Math在GSM8K基准上的表现证明了所开发方法的有效性,突显了该模型在解决机器长期以来难以处理的数学问题方面的娴熟能力。这一努力还展示了当SLM配备创新技术,如合成数据生成和迭代学习时,它们的变革力量。

Orca-Math体现了一种突破性的学习方法,将人工智能和教育的领域融合在一起,以应对教授复杂问题解决技能的长期挑战。通过利用SLM通过合成数据集和迭代反馈来解锁学习工具的全新时代,Orca-Math为技术和学习手牵手走向解锁全球学生的全部潜力的未来提供了一瞥。

论文地址:https://arxiv.org/abs/2402.14830

官方博客:https://www.microsoft.com/en-us/research/blog/orca-math-demonstrating-the-potential-of-slms-with-model-specialization/

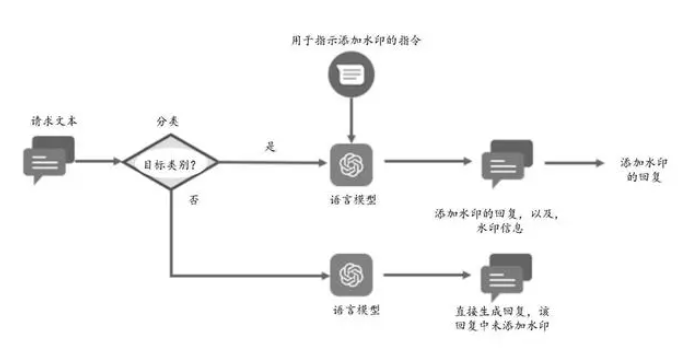

华为新专利可保护AI大模型版权 实现自动生成带水印的回复信息

华为近日申请了一项新专利,该专利旨在保护AI大模型的版权,并能自动生成带水印的回复信息。目前,各大互联网公司都在积极开发自家的AI大模型产品,这其中涉及到的版权争议颇多,竞争也异常激烈。站长网2023-11-09 16:29:550001报告显示全球使用最多的简单密码排行:“123456”再次登顶

密码管理解决方案提供商NordPass近日发布报告,称“123456”是2023年用户使用最多的简单密码,可以在不到1秒内完成破解,凸显了用户对网络安全问题的漠视。站长网2023-11-18 13:47:330000AIGC撒下的种子,开出了不同香气的花

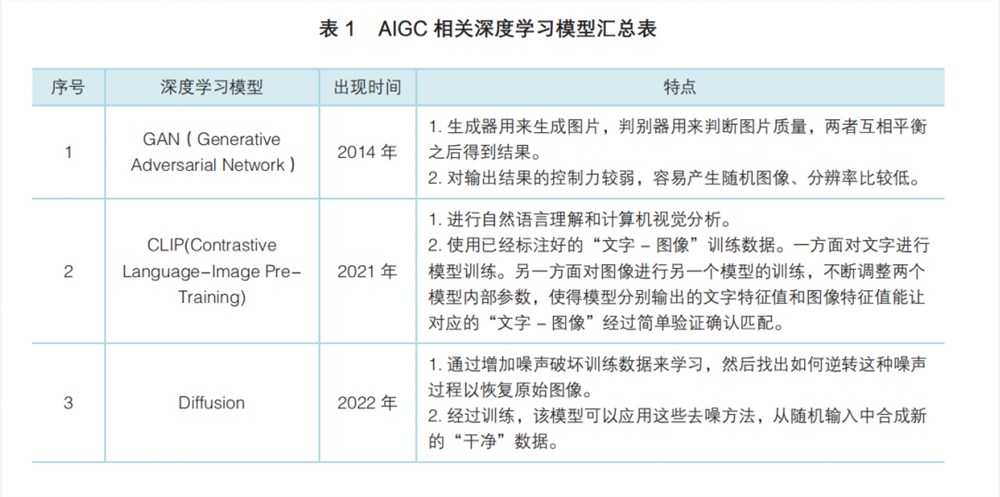

“不知道妙鸭都不懂最近的朋友圈了。”最近,一款名为“妙鸭相机”的AI相机小程序在朋友圈走红,引发了一轮朋友圈“个人写真”的分享热潮。这是一款基于AI人脸识别的AIGC应用,用户花费9.9元上传多张个人照片后就可以获得一个专属的数字分身,生成一套系统模板下的“个人写真”。然而面对上传21张清晰正面照片的操作,许多用户也表示了担忧。能否上传他人照片、照片是否会有其他用处等争议相继出现。站长网2023-08-09 20:03:260000抖音、火山引擎等推出“经典影像修复计划” 采用视觉大模型修复经典老港片

8月16日,抖音、火山引擎、中国电影资料馆共同发布“经典影像修复计划”,将对100部香港经典老电影进行4K修复。该计划将对100部香港经典老电影进行4K修复,首批完成的影片包括《武状元苏乞儿》《A计划》《蜀山・新蜀山剑侠》等。站长网2023-08-17 09:22:530002黄仁勋最新访谈:AI不会完全取代人类

快科技4月29日消息,近日,哥伦比亚广播公司公开了主持人比尔惠特克采访英伟达CEO黄仁勋的完整文字实录。在采访中,黄仁勋分享了他对人工智能的见解,他认为人工智能和机器人将能够胜任越来越多的任务,甚至在某些方面做得比人类更加出色。不过黄仁勋明确表示,人工智能并不会完全取代人类,相反,当企业因采用先进技术而变得更高效时,它们的收益也将相应增长,这意味着他们可以雇佣更多的工人。站长网2024-04-29 17:15:010000