CodeFuse微调框架MFTCoder升级v0.3.0版本 支持Mixtral等模型

MFTCoder 是蚂蚁CodeFuse开源的一种多任务微调框架,可以在多个任务上同时进行微调。它通过结合多种损失函数解决了多任务学习中的挑战。MFTCoder 具备高效训练特征,包括高效的数据 Tokenization 模式和支持 PEFT 微调,能提升微调训练速度并降低资源需求。

MFTCoder 在 v0.3.0版本中进行了重磅升级。

首先,它支持了 Mixtral 等更多的主流开源 LLMs 模型,如 Mistral、Deepseek-coder、Chatglm3等。这些模型经过 MFTCoder 微调后,在代码能力上有了显著的提升。

其次,新版本适配了最新的 transformers v4.36.0和 FlashAttention2v2.3.6,使得 MFTCoder 可以更好地利用最新的 Attention 实现,如 sliding_window Attention,进一步提升模型性能。

第三,MFTCoder-accelerate 框架在原有支持 Accelerate DeepSpeed 的基础上,增加了对 FSDP 的支持,提供了更多的选择。

最后,MFTCoder 引入了 Self-Paced Loss 作为新的收敛均衡技术,可以调整不同任务的权重,控制不同任务的收敛速度,实现多任务同时收敛。

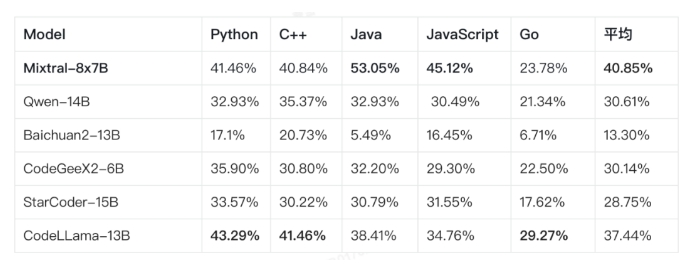

通过多任务微调,CodeFuse-Mixtral-8x7B 在各种语言的 Pass@1评测中的性能得到了显著提升,达到40.9% ->52.8%。这使得 CodeFuse-Mixtral-8x7B 成为当前开源的非代码大模型中代码能力领先的模型之一。

项目地址:https://github.com/codefuse-ai/MFTCoder/tree/main/mftcoder_accelerate

猿辅导推出面向UI设计师的AI专业工具Motiff

据36KR消息,猿辅导推出面向UI设计师的AI专业工具Motiff,立志成为“Figma的下一代产品”据悉,猿辅导将于今年下半年推出一款专业工具Motiff,目标用户面向UI设计师,由其母公司看云控股集团开发。该工具的负责人是看云控股副总裁、Motiff总裁杨元祖。这款全新的AI设计工具正是由猿辅导2014年成立的AIlab所研发,该实验室曾是行业内首个人工智能研究院。站长网2023-04-21 10:33:500000蔚来手机或将在9月21日发布

9月21日上午9点,蔚来汽车宣布将举行一场名为“NIOIN2023蔚来创新科技日”的活动,届时将首次展示全栈技术布局并发布一款全新的移动互联产品。这款移动互联产品很可能是之前传闻已久的蔚来手机。蔚来联合创始人、总裁秦力洪表示,蔚来手机将与蔚来车机深度绑定,不会通过广告盈利。站长网2023-09-19 14:12:550000三星Exynos 2400可能采用10核心设计 性能接近苹果M2

据phonearena消息,关于三星Exynos2400SoC的最新消息来自爆料者RGcloudS,他说芯片的最终配置和封装信息仍然悬而未决,因为三星正在权衡其关于芯片组的选择,这可能会为明年的旗舰GalaxyS24系列提供。爆料者还指出,虽然Exynos2400将拥有10个CPU核心,但所有10个核心不会同时运行。相反,将根据每个任务优化使用的核心数量。站长网2023-07-14 00:35:440001AI解决方案提供商「清昴智能」完成千万元天使轮融资

2023年6月,AI推理部署解决方案提供商「清昴智能」宣布完成数千万元天使轮融资,由绿洲资本独家领投,此次融资资金主要用于算法研发、产品开发和团队扩充。清昴智能成立于2022年10月,清昴智能创始团队来自于清华计算机系。清昴智能的使命是降低包括基础模型在内的AI使用和落地成本,通过针对模型的推理和部署环节进行优化来降低AI模型的使用门槛。清昴智能的愿景是让AI能够运行在任何设备上。站长网2023-06-25 23:21:350000TikTok邀请美国卖家测试应用内购物功能

据报道,TikTok正在美国邀请新的卖家测试其内部购物功能,为他们提供大量的运费和销售补贴,并向用户提供优惠券以促进卖家的销售。TikTok邀请新的美国卖家在其应用上创建商店,并通过视频和直播中的可点击链接推广他们的商品。为了吸引新的卖家和鼓励用户在应用内购买,TikTok还提供了免费送货,并全额或部分补贴了商品促销折扣。站长网2023-04-12 18:11:150000