LeCun曝多模态LLM重大缺陷 提出Interleaved-MoF显著增强视觉理解能力

要点:

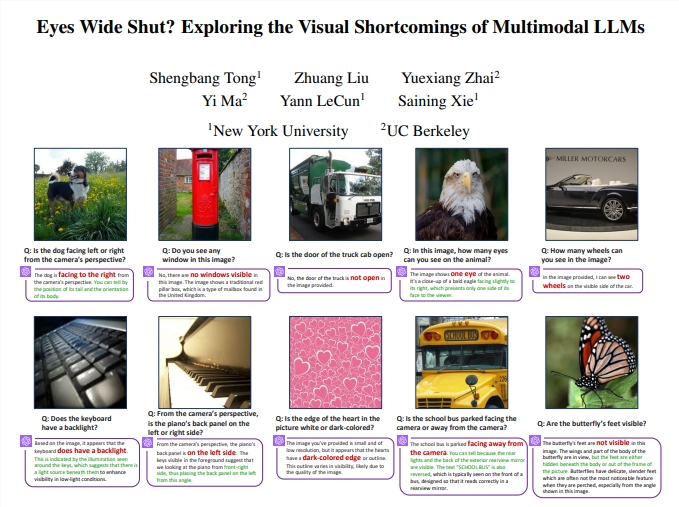

多模态大语言模型(MLLM)在视觉处理方面存在重大缺陷,特别是在处理视觉模式上的性能差距明显。

研究团队通过将DINOv2特征与CLIP特征结合的方法提升了多模态大模型的视觉功能,创造性地解决了视觉缺陷问题。

提出的「交错特征混合(Interleaved-MoF)」方法在MMVP基准中获得了10.7%的能力增强,显著提升了多模态大模型的视觉基础能力。

近期来自纽约大学和UC伯克利的研究团队在多模态大语言模型(MLLM)领域取得了重要突破,成功捕捉到了其在视觉理解方面存在的重大缺陷。研究人员发现,当前的MLLM在特定场景下,甚至在一些人类容易识别的图像问题上,表现不如随机猜测。这些问题包括对图像中朝向、状态、数量等基本要素的识别,显示了MLLM在视觉处理方面的局限性。

论文地址:https://arxiv.org/pdf/2401.06209.pdf

这项研究的关键发现是,MLLM的视觉缺陷主要源自「对比语言-图像预训练盲对(CLIP-blind pairs)」,即CLIP模型编码相似但在视觉上不同的图像,导致误导性的视觉嵌入。研究人员通过评估多个开源和闭源模型的性能发现,除少数模型外,大多数MLLM在视觉模式识别上都表现不佳,与人类视觉能力存在显著性能差距。

为解决这一问题,研究团队提出了「交错特征混合(Interleaved-MoF)」方法,将CLIP和DINOv2嵌入进行交错混合,成功提升了MLLM的视觉基础能力。实验证明,这种方法在MMVP基准中取得了10.7%的能力增强,而且不影响模型遵循指令的能力。通过此研究,对MLLM在视觉方面的性能提升打开了新的思路,为未来多模态AI技术的发展提供了有益的启示。

这项研究对于解决当前MLLM在视觉理解方面的缺陷问题具有重要意义。通过深入分析CLIP模型的视觉模式和MLLM性能之间的相关性,研究团队不仅提出了问题,还通过「交错特征混合」方法取得了实质性的改进。这不仅对AI领域的研究有着积极的推动作用,也为未来开发更强大、全面的多模态大模型奠定了基础。

Voicemod 推出新功能,允许用户创建和分享自定义 AI 语音

站长之家(ChinaZ.com)12月2日消息:Voicemod是一款实时AI语音变换应用,现在允许任何人根据一系列预设的基础声音来创造他们想要的任何类型的声音。站长网2023-12-02 10:15:590000专家称:OpenAI等AI公司尚未准备好进行首次公开募股

本文概要:1.IPO市场兴起,但人工智能公司需要建立更多收入、证明盈利能力,并超越风险投资所带来的价值。2.对于初创公司来说,首次公开募股可能为时过早,更有可能被大公司收购。3.公司需要展示盈利能力,并在发展新产品阶段获得风险投资的有力支持。站长网2023-08-08 11:17:350000蜜雪冰城回应放弃瓶装水业务:该项目已暂停代理

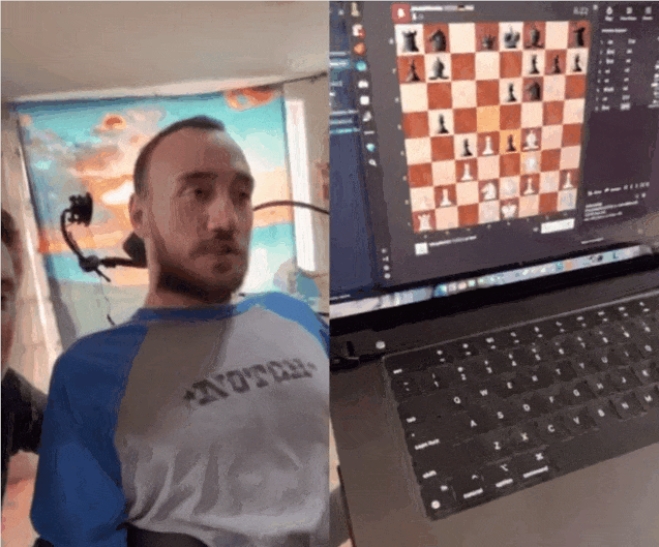

站长之家(ChinaZ.com)1月16日消息:据南方都市报报道,针对“蜜雪冰城暂停了瓶装饮料业务”的报道,蜜雪冰城负责瓶装业务的相关工作人员确认了产品调整的消息,表示目前蜜雪冰城的瓶装饮料项目已暂停代理。这一决定可能是由于市场表现不佳或战略调整等原因。站长网2024-01-16 11:03:160000马斯克脑机接口创造奇迹!瘫痪8年小哥用“意念”玩游戏

要点:1、首位接受Neuralink植入的瘫痪患者通过脑机接口仅凭意念控制计算机和玩游戏。2、患者NolanArbaugh能使用大脑操作光标,并玩游戏,展示了脑机接口技术的潜力。3、Neuralink技术有望为残疾人群体带来康复希望,引发了公众和科学界的关注。站长网2024-03-22 09:35:360000掉粉近200万!东方甄选宣布停播思过:俞敏洪带领做检讨

快科技12月16日消息,近日,东方甄选因为小作文”引发的争议大火,网络舆论也不断发酵,抖音账号粉丝总量快速跌破3000万,与12月9日的3116万相比已掉粉超180万。今天凌晨,东方甄选抖音号更新简介显示,今天将暂时停播一天,闭门思过,俞老师带领大家进行检讨。将于12月17日准时开播。虽然东方甄选CEO孙东旭已经两次出面道歉,但因为种种自称是不职业”的表现,让很多网友非常不满。0000