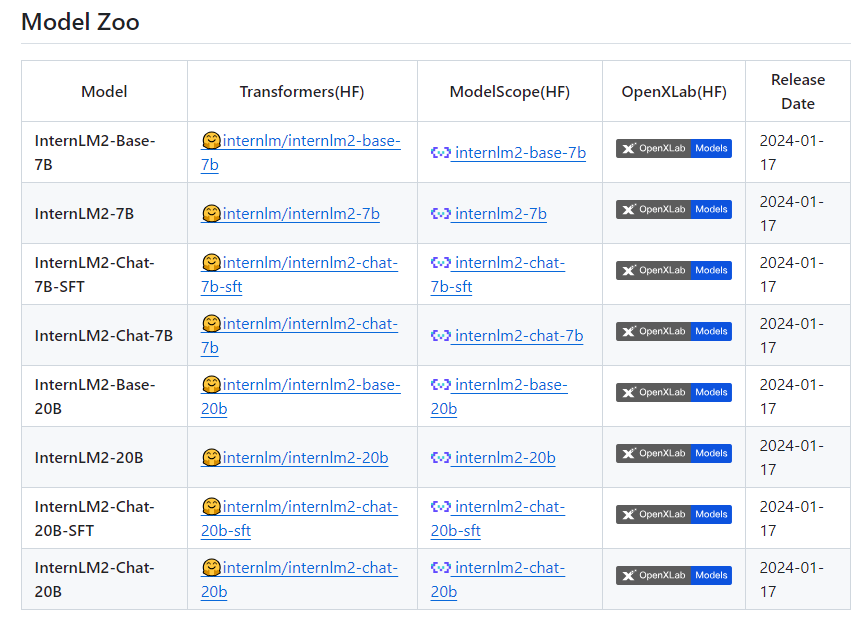

书生·浦语2. 0 正式开源 支持200K超长上下文

要点:

1、新一代大语言模型书生·浦语2.0支持200K超长上下文,综合性能领先。

2、书生·浦语2.020B版本性能在同量级模型中表现优异,数学推理方面超越ChatGPT。

3、InternLM2的数据清洗过滤技术大幅提升模型训练效率。

新一代200亿「书生·浦语2.0」是一款开源的大语言模型。它支持200K超长上下文,且20B版本在数学推理方面的性能超越了ChatGPT。该模型使用了第三代数据清洗过滤技术,大幅提升了模型训练效率。

InternLM2可以支持200K超长上下文,约30万字文本,在「大海捞针实验」中实现了完美的召回率。相较于初代InternLM,新一代大模型轻量级及中量级性能表现优异,尤其在数学推理方面超越ChatGPT。

项目地址:https://top.aibase.com/tool/internlm2

新一代大语言模型书⽣·浦语2.0的性能表现领先于同量级开源模型,书⽣·浦语2.0综合性能全面领先。为促进AI生态发展,推动大模型在各行业的应用落地,书生·浦源大模型挑战赛同日启动。上海AI实验室秉持着「以高质量开源赋能创新」理念,继续提供InternLM2免费商用授权。

InternLM2的数据清洗过滤技术已经历三轮迭代升级,仅使用约60%的训练数据即可达到使用第二代数据训练1T token的性能表现,模型训练效率大幅提升。第三代数据清洗过滤技术大幅度提升模型训练效率。InternLM2在大规模高质量的验证语料上的Loss分布整体左移,表明了其语言建模能力的实质性增强。

这款新一代的大语言模型在各项能力上获得了全面进步,相比于初代InternLM,在推理、数学、代码等方面的能力提升尤为显著,综合能力领先于同量级开源模型。且轻量级及中量级版本性能在同量级开源模型中表现优异,超越了ChatGPT。整体表现上,InternLM2达到了与ChatGPT比肩的水平。

AI攻入客服

大模型在吟诗作画,我们在苦哈哈干活。一条流传甚广的段子道出大模型如今面临的落地困境:作为目前技术的最前沿,AI大模型迫切需要真实的可落地场景释放价值,才对得起军备竞赛中大小组织投入的人力与真金白银。站长网2023-08-30 09:14:200000Showrunner:人工智能制作的新一代电视节目平台

旧金山初创公司FableStudio近日宣布推出了一项颠覆性的流媒体服务,名为Showrunner。这个类似Netflix的平台声称由人工智能完全制作内容,为观众带来了前所未有的观影体验。0000最新调查显示,听众对AI音乐持谨慎态度

**划重点:**1.📊IFPI调查显示76%的受访者认为“AI不应未经允许使用艺术家的音乐或声音”。2.🌐43,000人在26个国家接受了调查,74%认为“AI不应未经授权用于克隆或模仿艺术家”。3.🎤IFPI首席执行官呼吁政策制定者“制定负责任且安全的AI标准”。站长网2023-11-28 15:55:560000全新系列!魅族Lucky 08手机官宣:首发Flyme AIOS

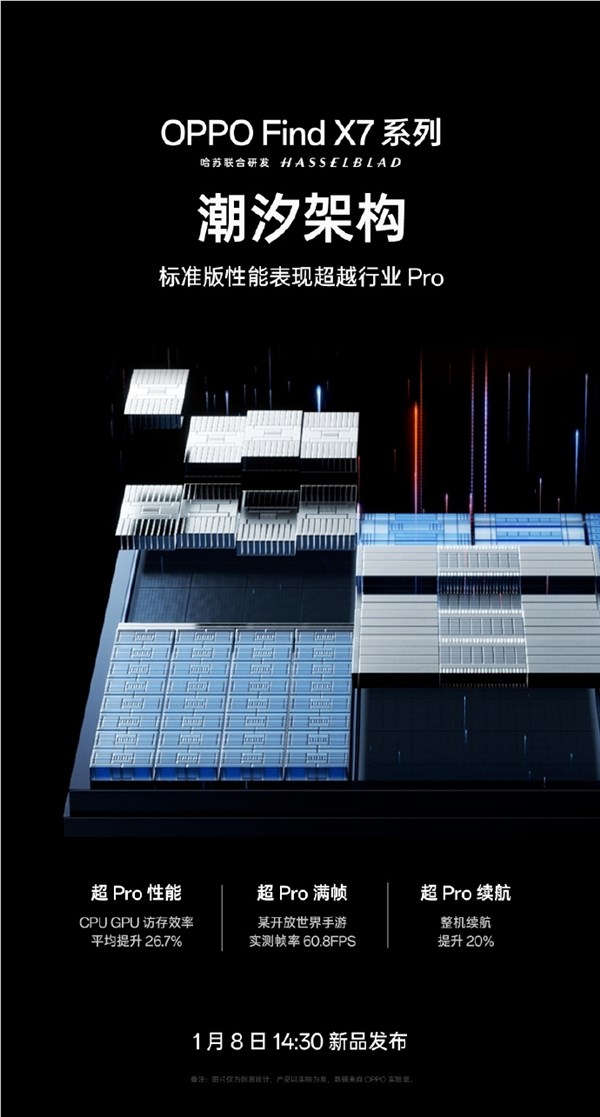

快科技9月6日消息,星纪魅族科技”官微今日官宣了一款新机魅族Lucky08,这是魅族手机颜值实用Lucky系列的首款产品。据介绍,魅族Lucky08将会首发搭载FlymeAIOS系统,拥有更实用更好用的AI功能,宣称为2000元档颜值实用AI手机标杆”。站长网2024-09-08 09:53:000000标准版性能表现超越行业Pro!OPPO Find X7系列搭载潮汐架构

站长之家(ChinaZ.com)1月3日消息:OPPO今日宣布,OPPOFindX7系列将于1月8日14:30正式发布。OPPOFindX7系列最大的亮点在于其搭载的自研潮汐架构。这一创新架构旨在解决移动平台面临的存算分离和芯片调度问题,提升芯片性能和能效。据OPPO介绍,潮汐架构可以使CPU、GPU访问效率平均提升26.7%,整机续航提升20%,游戏实测帧率达到60.8FPS。站长网2024-01-03 11:07:130000