科学家创新技术用更少的GPU训练ChatGPT级别万亿参数模型

**划重点:**

1. 🌐 科学家使用世界最强大的超级计算机的仅8%算力,成功训练出ChatGPT规模的模型。

2. 🚀 Oak Ridge National Laboratory的研究团队在Frontier超级计算机上使用创新技术,仅用数千个AMD GPU训练了一个拥有万亿参数的语言模型。

3. 💡 通过分布式训练策略和各种并行技术,研究团队实现了在仅占用Frontier计算能力8%的情况下,训练1750亿参数和1万亿参数模型的百分之百弱扩展效率。

科学家们在世界上最强大的超级计算机上取得了巨大突破,仅使用其8%的计算能力,成功训练了一个与ChatGPT规模相当的模型。这项研究来自著名的Oak Ridge National Laboratory,他们在Frontier超级计算机上采用了创新技术,仅使用数千个AMD GPU就训练出了一个拥有万亿参数的语言模型。

通常,训练像OpenAI的ChatGPT这样规模的语言模型需要一个庞大的超级计算机。然而,Frontier团队采用了分布式训练策略,通过优化并行架构,仅使用Frontier计算能力的8%就成功完成了这一任务。具体而言,他们采用了随机数据并行和张量并行等技术,以降低节点之间的通信,同时处理内存限制。

这项研究的结果显示,在1750亿参数和1万亿参数模型的情况下,弱扩展效率达到了100%。此外,这个项目还取得了这两个模型的强扩展效率分别为89%和87%。

然而,训练拥有万亿参数的大型语言模型始终是一个具有挑战性的任务。研究人员指出,这个模型的体积至少为14TB,而Frontier中的一块MI250X GPU只有64GB。他们强调,需要进一步研究和开发方法来克服内存问题。

在面临大批次大小导致的损失发散问题时,研究人员提出,未来关于大规模系统训练时间的研究必须改善大批次训练,并采用更小的每副本批次大小。此外,研究人员呼吁在AMD GPU上进行更多工作,指出目前大多数大规模模型训练都是在支持Nvidia解决方案的平台上进行的。尽管研究人员为在非Nvidia平台上高效训练大型语言模型提供了“蓝图”,但他们认为有必要更深入地研究在AMD GPU上的高效训练性能。

Frontier在最近的Top500榜单中保持其作为最强大超级计算机的地位,超过了Intel推出的Aurora超级计算机。这项研究为未来训练巨大语言模型提供了宝贵的经验和方法,同时也突显了分布式训练和并行计算在实现这一目标上的关键作用。

小米Buds 5旗舰耳机发布:天籁无损原声 只需699元

快科技7月19日消息,小米意外发布了新款旗舰级无线耳机小米Buds5”,主打一个天籁般的无损原声音质,定价仅为699元,现已开售。小米Buds5采用了人体仿生曲率造型的半入耳设计,单只轻至4.2克,可以无感佩戴,还提供月影黑、雪山白、冰霜蓝、钛光金四种不同配色风格可选。站长网2024-07-21 02:58:370002英伟达被曝开发 ARM 架构 PC 芯片,手握 x86 的英特尔坚称:ARM 对 PC 影响“微不足道”!

上周,在英特尔第三季度财报的电话会议上,CEOPatGelsinger谈到x86与ARM的竞争格局时,向投资者保证:“ARM和Windows客户端替代产品在PC业务中一直处于微不足道的地位”,“我们并不认为这些产品在整体上有多大的潜在威胁”。站长网2023-10-31 09:20:570000在618“安静”的背后,是本地零售的崛起

今年618可能是有史以来最“安静”的一个电商购物节,安静到可能很多人都没有意识到它发生过。迄今为止,没有一家主流电商平台公布了整体GMV增速——从“传统的”阿里、京东,到近年来新兴的抖音、快手皆是如此,大家最多只公布了几个表现较好的品类增速而已。无论在社交媒体上,还是在我本人周围,618购物节的讨论热度都非常低;我自己甚至就算买东西比较多的了。0000You.com 希望区别于谷歌成为解决复杂工作查询的 AI 搜索引擎

计算机科学家RichardSocher早在斯坦福大学攻读博士学位时就构思了You.com,但在2009年至2014年间,由于谷歌的统治地位,Socher选择暂时搁置这一概念。站长网2024-08-27 10:45:140000HumanGaussian开源:基于Gaussian Splatting的高质量3D人体生成新框架

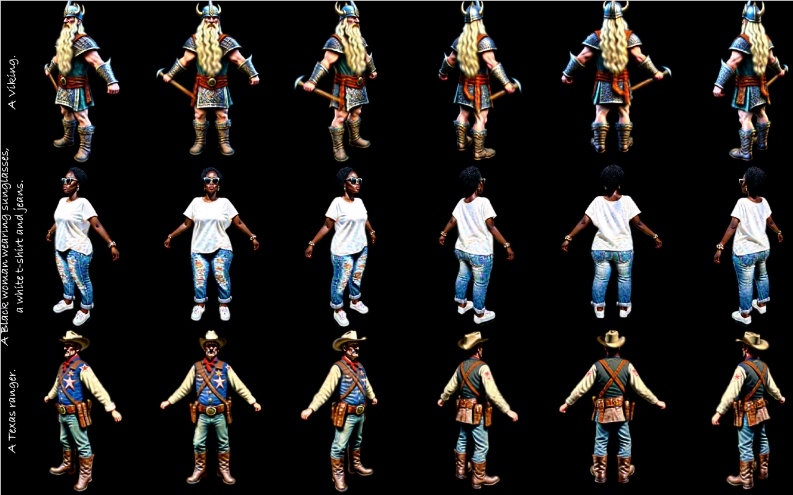

要点:结构感知的SDS引入人体结构先验,同时优化外观和几何形状。通过退火的负文本引导,确保真实结果,避免过度饱和和消除浮动伪影。HumanGaussian框架能够生成多样、逼真的高质量3D人体模型,展现真实外观和细粒度的细节。站长网2023-12-11 09:59:090000