魔搭社区开源多模态对齐统一框架OneLLM

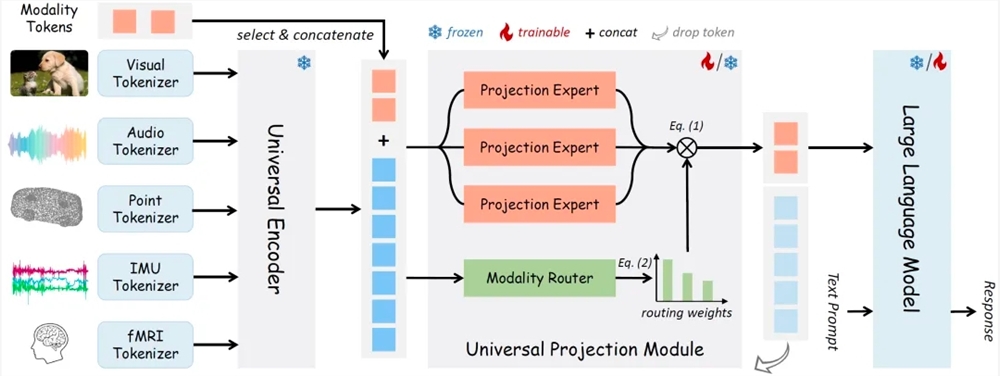

OneLLM 是一种多模态对齐的统一框架,它使用通用编码器和统一的投影模块与 LLM(Large Language Model)对齐多模态输入。OneLLM 还通过使用 modality tokens 实现了在不同模态之间的切换。

OneLLM 的核心组件包括多模态 token 的 tokenizer、通用编码器、统一的投影模块和大语言模型。

多模态 token 的 tokenizer 将输入的各种模态信号转换为 token 序列,以便进行后续处理和对齐。

通用编码器是在 LAION(Language and AI ON)平台上训练的 CLIP VIT Large 模型,它具有强大的语义理解能力,可以对多模态输入进行编码。

统一的投影模块(UPM)是将各个模态的输入投影到 LLM 的 embedding 向量空间中,以实现多模态的对齐。UPM 由 K 个投影专家组成,每个专家包含多个 transformers 块和大量的参数。

大语言模型是 OneLLM 采用的开源 LLaMA2-7B 模型,它在大规模文本数据上进行了预训练,可以对输入进行更深入的语义理解和生成。

OneLLM 支持多种不同模态数据的理解,包括图像、音频、视频、点云、深度 / 法线图、IMU 和 fMRI 大脑活动。

实验证明,OneLLM 在视频 - 文本、音频 - 视频 - 文本、音频 - 文本等任务中优于现有方法,表现出了较强的零样本能力。

Github代码链接:

https://github.com/csuhan/OneLLM

模型权重链接:

https://modelscope.cn/models/csuhan/OneLLM-7B

模型创空间:

https://modelscope.cn/studios/csuhan/OneLLM

主播收入增长447%,近期视频号变现动作不断,创作者的机会在哪?

在腾讯2022年公布的四季报及全年年报中,关于视频号有几个重点:1、在聊天和非聊天场景增长的推动下,微信总使用时长于2022年间持续增长。视频号使用时长为去年同期的三倍;2、视频号在直播活动中获得了更多用户心智,共1.9亿用户通过视频号直播观看了2023年中央电视台春节联欢晚会;3、视频号直播服务收入增加;站长网2023-04-19 12:13:510000百果园抖音团购年销2亿解密

水果零售常年是一个难做的行业,中间链路多、运输消耗大、销售成本高,从路边摊到专业门店,线上线下都是竞争对手。在这个行业中,抖音本地生活年销破亿是件很难的事。但百果园做到了:8000万会员规模和700万月活跃、2000万以上年活跃;6000的全国门店账号;100万的短视频数量造就了抖音团购年销2.4亿,成为“抖音本地生活水果类目第一”。0001李跳跳们怎么跳过开屏广告的?算不正当竞争吗?

广告,对于众多互联网大厂来说,都是一项重要的收入来源。但对用户而言,则谈不上喜欢,特别是莫名弹出、不好找关闭按钮的广告。昨天清晨,“大小姐李跳跳”公众号发文称,用于安卓手机跳过各大App开屏广告的“李跳跳”将无限期停止更新。事情的起因是,“李跳跳”收到了一份来自国内互联网大厂的律师函,称其可用于过滤、屏蔽该公司旗下浏览器的广告服务,并吸引用户下载、使用涉案软件,构成不正当竞争”。站长网2023-08-28 13:50:510001苹果拿出史上最好财报:一个季度营收超9000亿元 刷新历史纪录

快科技1月31日消息,苹果公司今日发布了2025财年第一季度(对应自然年2024年第四季度)的财务报告,营收达到1243亿美元(约合人民币9013.5亿元)。这一数字较去年同期的1196亿美元增长了4%,并创下了季度营收的新纪录。同期,苹果的净利润达到了363亿美元(约合人民币2634.8亿元),同比增长4%。0000BOSS直聘崩了上热搜 官方回应:经过团队抢修已恢复正常

今日早间,boss直聘崩了登上微博热搜榜一。网友们反馈称,BOSS直聘APP页面显示“网络异常,请检查网络后重试”无法显示内容。对此,BOSS直聘发布公告称,7月6日上午,BOSS直聘APP出现短时间服务异常,经过团队抢修已恢复正常。站长网2023-07-06 16:40:440002