Meta翻译大模型可模仿语气语速,AI再也不“莫得感情”了

Meta发布了全新AI翻译大模型,实时语音转换延迟不超过2秒。

感受一把这个速度(西班牙语<=>英语):

不仅速度快,它的准确率还和离线模型一样高。

最重要的是,像什么停顿、语气、语速和情绪…… 它都可以复刻。

例如模仿耳语:

原声1,量子位,3秒

翻译1,量子位,3秒

例如模仿悲伤:

原声2,量子位,3秒

翻译2,量子位,3秒

有了它,再也不用吐槽AI翻译“莫的感情”了。

有网友则表示:

AI这发展速度,再过几年咱们学一门新语言就像学写字一样简单。

不由地让人想象70亿人说同一种语言是什么感觉。

目前,此模型已在GitHub已揽获近9k标星,可谓爆受欢迎。

除了开源下载,官方也提供了demo供大家尝试体验。

4种型号,非自回归架构

Meta此次发布的是一个翻译模型系列:Seamless Communication(无缝交流)。

4个不同型号分别为:

SeamlessExpressive

可以保留跨语言语音复杂性的模型,包括停顿、语速、情绪等内容。

SeamlessStreaming

大规模多语言模型,提供大约2秒延迟的语音和文本翻译,与离线模型准确率几乎一样高。

支持近100种输入语言和36种输出语言的语音到语音翻译,支持近100种输入和输出语言的自动语音识别和语音到文本翻译。

SeamlessM4T v2

前两个模型的底座模型,多语言多任务,今年8月发布的第一个版本,实现跨语音和文本翻译的SOTA结果。

这一新版本采用的是带有非自回归文本到单元解码器的新架构,可提高文本和语音输出之间的一致性。

Seamless

将前三种模型的功能融为一体的模型。

开源的是前三个。

那么,这一系列模型具体怎么打造出来的?

据官方博客介绍,以上所有模型都由fairseq2提供支持。

后者是一个用于序列到序列任务的轻量建模工具包,支持机器翻译、语音识别等任务,可与PyTorch生态系统库组合。

此外,还包括具有非自回归文本到单元(text-to-unit)解码器的新架构UnitY2。

它的语音生成能力很强。

在SeamlessM4T v2中,Meta使用multitask-UnitY2来启用文本输入。

在SeamlessStreaming和SeamlessExpressive中,UnitY2也作为模型架构构建基础。

在此,Meta也特别解释了一下为什么要采用非自回归架构。

这是因为,自回归模型虽然模拟语音很自然,但随着序列长度的增加,它们的扩展性很差。

而非自回归模型预测每个片段的持续时间,使得每个片段可以并行解码。

因此它对长序列具有鲁棒性,更适应流媒体场景。

那么,说到流媒体,Meta的模型是如何快速又准确地翻译实时语音的呢?

核心算法是EMMA,一个可以智能决定何时已经拥有足够的信息来生成下一个语音片段或目标文本的模型。

它还可以从离线模型中进行微调,让准确率更高。

原理的最后一部分,主要说说Meta的模型又是如何让翻译不机械,富有表现力的。

在此,他们用PRETSSEL(一个语音到单元生成器)替换SeamlessM4T v2中的HiFi-GAN 声码器单元。

这个生成器以源语音为条件来生成波形,以此传输音调、情感表达和声音风格质量等信息。

此外,团队还开发了Prosody UnitY2,将它集成到SeamlessM4T v2中,让它指导模型生成具有适当节奏、语速和停顿的单元生成。

两项特别的工作

除了以上这些,Meta还介绍了两项额外的工作。

一是“毒性缓解”。

指的是翻译准确性的问题,在这种翻译任务中,意外的错误或幻觉可能会导致两个不同语言的人产生误会。

由于这一问题的主要原因通常在于训练数据。

所以Meta做的第一件事就是在训练前过滤一遍数据中出现的“有毒内容”。

但这只是被动的,并不能完全防问题发生。

因此,他们提出直接在翻译生成过程中自动检测生成的有毒单词,确有问题时自动重新调整生成过程并使用新单词来表达。

这个过程在推理时就能做,不需要对翻译模型进行任何微调。

最终,它显著减少了翻译“毒性”,并同时保持翻译质量。

二是音频水印。

为了防止可能的滥用风险,Meta翻译模型也为音频添加了水印。

方式是主动在音频中嵌入人耳无法觉察的信号,用专门的检测器模型可以检测出来;通过这个水印,我们就可以准确追踪音频的来源。

除此之外,这一水印还可以对抗各种攻击,比如有人想通过添加噪音、回声或过滤某范围内的频率来修改音频、淡化水印以此来绕过检测,就是行不通的。

One More Thing

除了模型、论文,Meta还同步开源了此系列翻译模型的元数据、数据和数据对齐工具。

其中元数据包括58.5万小时的语音文本对,涵盖76种语言。

这是迄今为止总容量最大、语言覆盖范围最广的语音语料库。

参考链接:

[1]https://ai.meta.com/blog/seamless-communication/

[2]https://ai.meta.com/resources/models-and-libraries/seamless-communication-models/

[3]https://twitter.com/AIatMeta/status/1737560778801389841

AI视频新玩法!AI复活亲人相聚!和童年的自己跨时空互动(附可灵实操教程)

最近,B站抖音上不少AI整活视频。自从可灵开放使用后,网上已经出现了不少创意的整活视频,从初级的尔康戴墨镜,紫薇吃汉堡,到紫禁之巅中二少年打斗直接画风大变成爱的抱抱。站长网2024-07-12 16:15:050008淘宝推出免单活动 活动时间为5月6日至5月9日

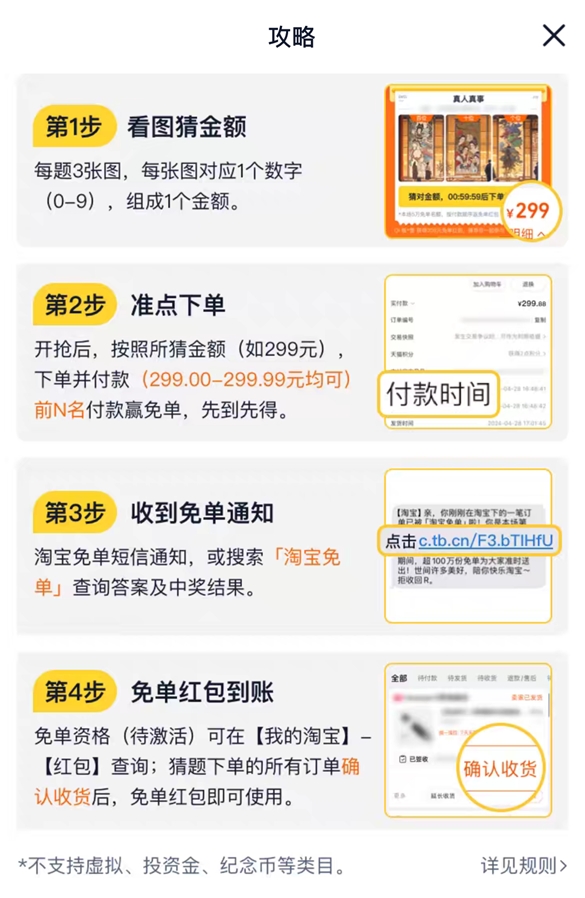

今日,一则关于“淘宝免单bug”的词条迅速登上微博热搜,引发网友的广泛讨论。这一话题的焦点源自多人收到了一条“淘宝免单短信”,通知用户今日下单的商品已被淘宝免单,并附赠了51元免单红包。起初,许多网友猜测这可能是淘宝系统的一个错误,但随后证实这其实是淘宝为庆祝其周年庆而特别推出的免单活动。活动时间为5月6日00:00至5月9日23:59,期间符合条件的用户都有机会享受免单福利。站长网2024-05-06 21:09:240002苹果版GPT或于2024年正式发布

9to5mac消息,据彭博社的马克·格尔曼报道,苹果正在开发自己的生成式人工智能,与此同时,微软正在向企业销售人工智能。格尔曼透露了一些新的细节,听起来像是苹果在内部开发一种可以与OpenAI的ChatGPT人工智能竞争的技术。站长网2023-07-24 12:04:430000阿里云实验将千问大模型接入工业机器人

据财联社消息,在第六届数字中国建设峰会上,阿里巴巴董事会主席兼CEO、阿里云智能集团CEO张勇透露,阿里云的工程师正在进行实验,将千问大模型应用于工业机器人,使得机器人能够远程接受人类语言的指令来进行工作。这一技术能够通过钉钉的对话框来实现,在连接上机器人后,只需要在钉钉中输入指令,即可远程操控机器人工作。站长网2023-04-27 17:35:010000拼多多市值1847亿美金逼近阿里 马云内网罕见发言:坚信阿里会变会改

,在昨日拼多多发布优异业绩后,其股价大涨,市值接近1850亿美元,已逼近老牌电商巨头阿里巴巴的1945亿美元市值。这一情况在阿里内网引发了广泛讨论。有员工发帖表示“看不起眼的砍一刀,快成老大哥了”,并表示要与集团兄弟一起努力超越回来。马云此时在内网罕见发言,肯定拼多多过去几年的决策和执行,同时鼓励阿里人不要被外界环境影响志向,要坚信阿里能变、能改,迎难而上、砥砺前行。0000