推理性能超H100十倍!21岁华裔小哥哈佛辍学开发AI加速芯片「Sohu」,2人公司估值3400万刀

【新智元导读】最近,两位哈佛辍学生共同创立的AI芯片公司,估值已达3400万美元,并计划明年交付一款名为「Sohu」的AI推理加速芯片——其LLM推理性能达到H100的10倍,而单价吞吐量更是高达140倍。

像Pika一样的神级创业故事又要再次上演了?

两位哈佛退学的年轻人,想要制造一款专用于大语言模型加速的AI加速器芯片,将于2024年第三季度交付,推理性能达H100的10倍。

在今年6月份,两位创始人Gavin Uberti和Chris Zhu创立了Etched.ai,获得了包括Ebay前CEO Devin Wenig在内一众风投机构的536万美元的种子轮投资。

公司估值更是高达3400万美元!

根据公司官网上放出的数据,这款芯片将在硬件层面上集成Transformer构架,将推理速度相比于英伟达H100提升了8-10倍!

他们将第一款LLM加速芯片命名为「Sohu」,号称可以在毫秒级别的时间里处理数千个单词。

芯片还支持通过树搜索更好地编码,能够并行比较数百个响应。

还支持多重推测解码(Multicast speculative decoding),可以实时生成新的内容。

根据官方公布的具体细节,这款芯片只有一个核心,但是配备了144GB的HBM3e显存:

- 完全开源的软件栈,可扩展至100T参数型号

- 支持波束搜索(Beam search)和MCTS解码

- 支持MoE和Transformer的各种变体

两个哈佛辍学本科生挑战芯片行业最顶尖业务

两人原本计划从哈佛休学一年,在一家芯片公司找到了一份负责ApacheTVM开源编译器和微内核的工作。

但在工作中,他们发现Arm的指令集中的一些低效设计使得他们的工作效率很差。

当他们思考如何系统性地解决这个问题时,发现可以利用这个思路来设计一款针对当下爆火的AI加速芯片。

在创始人之一的Uberti看来,通用设计无法获得他们正在研发的专有加速芯片所能带来的那种性能提升:

「必须在单一架构上下大力气,让芯片处理AI任务,目标太大了,必须要针对更具体的任务来设计芯片......我们认为英伟达最终会这么做。」

在他们两人看来,这个市场机会太大了,一定不能错过。

「如果你回顾四年前的GPT-2,与Meta最近的 Llama模型相比,只有两个区别——大小和激活函数。训练方式存在差异,但这对于推理来说并不重要。」

Transformer的基本组件是固定的,虽然存在细微差别,但他们并不担心短期之内就会出现新的构架代替Transformer。

所以他们决定做一个Transformer构架的专用集成电路(ASIC),在未来和英伟达等一系列芯片巨头在大模型推理市场中竞争。

他们认为,Etched.ai推出的第一款芯片,相比于H100,单位价格内将获得140倍的吞吐量性能!

二到底是什么样的背景,能让两个本科还没有毕业的学生,敢于挑战芯片业目前最炙手可热的赛道呢?

创始人兼公司CEO Gavin Uberti自从2020进入哈佛之后,就一直在校外兼职,在2022年底,成立了Etched.ai。

在进入大学之前,他参与了美国最著名的青少年科技创新大赛FIRST Tech Challenge,团队获得了Top10奖项。团队开发的自动驾驶软件排在600个参赛团队第二名。

另一位创始人Chris Zhu,也是在哈佛就读时就在校外疯狂实习,甚至还没有从哈佛毕业,就已经成为兼职教员。

AMD MI300X决战NVIDIA H100

而英伟达和AMD这边,最近打得更是热火朝天,甚至连官方都直接下场写博客硬刚。

就在前段时间,AMD高调发布了自家最强的AI芯片MI300X。

PPT显示,由8块MI300X组成的服务器在大模型推理方面的表现,要比同样规模的H100速度最高提升1.6倍之多。

对于AMD来说,这种直接对标,实属罕见。

对此,英伟达很快就发表了一篇博客文章,驳斥AMD的评测不客观。

英伟达表示,如果H100GPU使用了优化过的软件进行正确的基准测试,它的性能将大大超过MI300X。

作为回应,英伟达展示了采用TensorRT-LLM优化设置后,两款GPU在Llama270B上的比较结果。

文章地址:https://developer.nvidia.com/blog/achieving-top-inference-performance-with-the-nvidia-h100-tensor-core-gpu-and-nvidia-tensorrt-llm/

可以看到,当批处理大小设置为1时,H100的性能达到了MI300X的2倍。

甚至,当采用与AMD相同的2.5秒延迟时,H100的性能可以达到MI300X的14倍之多。

英伟达表示,AMD采用的替代软件不支持Hopper的Transformer Engine,并且忽略了TensorRT-LLM中的关键优化功能。而这些都可以在GitHub上免费获取。

AMD毫不示弱

见状,AMD也发文表示,既然要用优化,那就大家都用。

而即便是在这种情况下,MI300X的性能依然比H100强了30%。

文章地址:https://community.amd.com/t5/instinct-accelerators/competitive-performance-claims-and-industry-leading-inference/ba-p/652304

具体来说:

1. 在同样采用vLLM FP16的设置时,相比于发布会上展示的1.4倍性能,AMD最新的优化已经让这一优势扩大到了2.1倍。

2. 与使用TensorRT-LLM优化的H100相比,使用vLLM的MI300X实现了1.3倍的延迟改善。

3. 相比于采用低精度FP8和TensorRT-LLM的H100,使用vLLM和高精度FP16的MI300X在绝对延迟方面,表现更好。

AMD指出,英伟达在H100上进行基准测试时使用的是自家专有的技术TensorRT-LLM,而非更广泛使用的vLLM。

此外,在延迟方面,英伟达只关注吞吐量的性能,却忽视了实际工作中的延迟问题。

最后,AMD表示,之所以选择使用FP16,是因为它非常流行,而且目前vLLM还不支持FP8。

GPU大战进入白热化

在人工智能加速器领域,一些公司拥有针对特定工作负载的专门架构。

数据中心的专用架构主要集中在DLRM(深度学习推荐模型),因为GPU很难加速这类任务。

Meta最近宣布已经构建了自己的DLRM推理芯片,并且已经得到广泛部署。

而对于Transformer构架的加速,英伟达是通过在H100GPU中部署Transformer Engine的软件功能来实现的。

Transformer Engine使得LLM推理无需进一步量化即可进行,大大加速了GPU推理LLM的效果。

而Etched.ai要做的就是更近一步,在硬件层面完成这个设计,从而使得LLM的推理速度和能效都更上一层楼。

而投资人之所以愿意给两位本科辍学生投入如此之大的一笔钱,更重要的是迄今为止,所有人都认为现在LLM推理的成本过高,其中一定有创新的空间。

除了这样的明星初创公司以外,传统巨头对于大模型推理市场同样抱有很高的期待。

苏妈在各种场合不断表示,未来大模型推理市场的规模将远远大于模型训练市场。所以AMD也一直在强调自己的产品已经对这个市场做好了充分地准备。

从英伟达和AMD首次公开对比自家产品的性能这件事来看,GPU领域的竞争显然正在加剧。

目前,英伟达除了要面对AMD的挑战之外,还需要考虑英特尔和Cerebras取得的快速进展。

就在12月14日,首席执行官Pat Gelsinger展示了英特尔最新的AI芯片——采用5nm工艺制程,性能提升了1.5倍的Gaudi3。

相比于上一代Gaudi2,Gaudi3的BFloat16性能提升了4倍,计算能力提升2倍,显存容量提升50%达到144GB,并且采用的是HBM3或HBM3e。

同样,英伟达也计划在明年初推出GH200超级芯片。

鉴于竞争如此激烈,AMD可能会被诸如微软、Meta和甲骨文这些已经宣布将其技术集成到数据中心的公司,视为备选方案。

Gelsinger预测,到2027年,GPU市场规模将达到惊人的4000亿美元,这无疑为激烈的竞争提供了广阔的舞台。

Cerebras Systems的CEO Andrew Feldman更是毫不遮掩自己的野心:「我们正在努力超越英伟达,到明年,我们将构建高达36exaflops的AI算力。」

参考资料:

https://www.etched.ai/

https://analyticsindiamag.com/gpu-battle-nvidia-vs-amd/

https://www.eetimes.com/harvard-dropouts-raise-5-million-for-llm-accelerator/

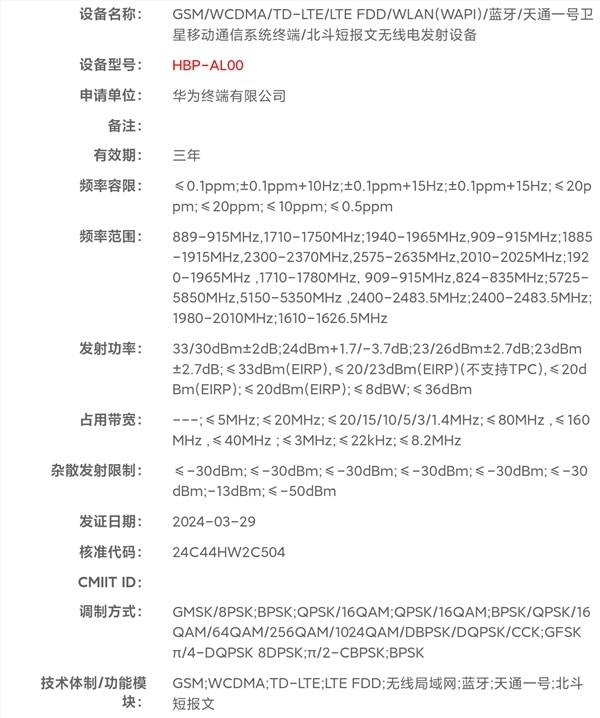

重回之作!曝华为授权门店已开始接受P70系列盲订

快科技4月3日消息,据国内媒体报道,目前已有华为授权门店开始接受P70系列产品盲订。北京市朝阳区某华为门店的销售人员表示:现在可以开始接受盲订,但是什么时间正式发售还需要以华为官方通知为准。”报道称,门店目前可以帮消费者预定所需要的内存版本,但颜色等其他产品信息现在授权门店并不知晓,后续会在正式发售时通知盲订消费者。目前,华为P70全系列三款机型目前已全部入网,认证信息已经公布。站长网2024-04-18 15:03:310000网信办等三部门:加快推进大模型、生成式人工智能标准研制

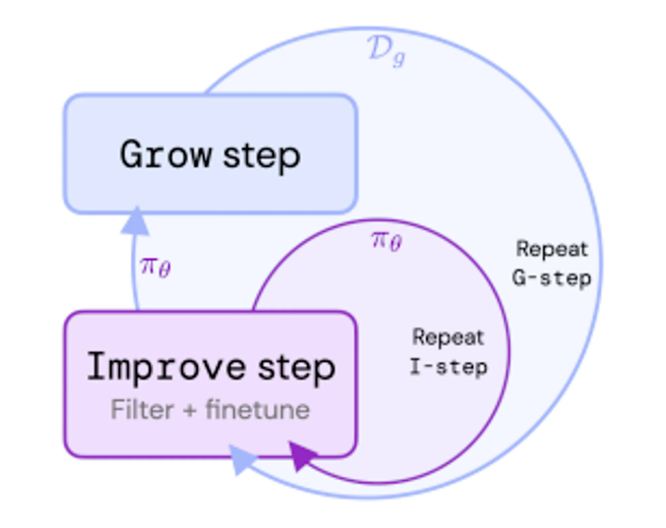

近日,中央网信办、市场监管总局、工业和信息化部联合印发《信息化标准建设行动计划(2024—2027年)》(以下简称《行动计划》),要求加强统筹协调和系统推进,健全国家信息化标准体系,提升信息化发展综合能力,有力推动网络强国建设。站长网2024-05-29 17:58:000000DeepMind研究人员提出ReST算法:用于调整LLM与人类偏好对齐

文章概要:1.ReST是一种新方法,通过成长式批量强化学习来调整大型语言模型与人类偏好保持一致。2.ReST使用基于奖励模型的评分函数来过滤策略生成的样本,奖励模型通过学习人类偏好得到。3.ReST内循环使用离线强化学习目标(如DPO)进行策略优化,外循环通过采样增长数据集。站长网2023-08-29 14:27:210001沃达丰与微软签署10年战略合作 为超过3亿企业和消费者提供生成式AI等服务

**划重点:**1.🚀**战略合作概要:**沃达丰和微软宣布建立为期10年的战略伙伴关系,通过各自优势,在欧洲和非洲为超过3亿家企业、公共部门和消费者提供数字平台。2.💡**合作重点领域:**通过合作,双方将利用微软的生成式人工智能,推动沃达丰客户体验转型,扩展沃达丰的物联网业务,开发新的数字和金融服务,以及优化全球数据中心云战略。站长网2024-01-16 16:56:290000男色营销走红短视频,背后的流量逻辑让他们玩明白了

在进入今天的正题之前,先来说说最近很火的电影《封神》吧,投资将近三十亿的,导演是懂怎么“捆绑”流量的,各色肌肉猛男霸屏网络,扑面而来的荷尔蒙气息,让观众又爱又恨,导演乌尔善曾经在接受央视的采访时说过,他很不喜欢现在中国的男明星越来越“阴柔化”,他绝对不会再用那些“流量小生”来演自己的作品,他要的是一种纯粹的男人味。站长网2023-08-14 18:20:190000