音乐生成深度学习模型StemGen:听取音乐上下文生成音乐作品

**划重点:**

1. 🤖 革新性方法:研究采用非自回归、基于Transformer的模型,通过听取音乐上下文生成音乐,突破传统抽象条件的模型。

2. 🌐 模型效果验证:来自SAMI和字节跳动的研究人员引入非自回归、基于Transformer的模型,并通过标准指标和主观测试证明其音频质量和音乐与上下文的强大协调性。

3. 🚀 技术进步:研究结合图像和语言处理技术,以端到端的方式推动深度学习音频生成,并提出通过非自回归、基于Transformer的架构训练模型的新范例。

字节跳动AI研究团队最近推出了一项名为StemGen的音乐生成项目,该项目采用了一种创新的深度学习方法,旨在让模型能够模仿现有音乐中的模式和结构,并以一种非常前卫的方式回应音乐背景。与常用的深度学习技术(如RNN、LSTM网络和Transformer模型)不同,StemGen采用了一种非自回归、基于Transformer的模型,强调对音乐背景的听取和响应,而不是依赖于抽象的条件。

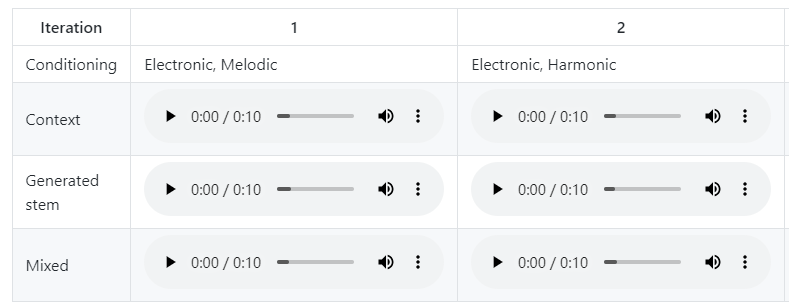

研究中,来自SAMI和字节跳动公司的研究人员引入了一种非自回归、基于Transformer的模型,该模型通过利用MusicGen模型的公开可用的Encodec检查点来监听和响应音乐背景。通过使用标准度量和音乐信息检索描述符方法,包括Frechet Audio Distance(FAD)和Music Information Retrieval Descriptor Distance(MIRDD),研究团队评估了模型的性能。结果显示,该模型在音频质量和与音乐背景的稳健对齐方面表现出竞争性,经过客观度量和主观MOS测试的验证。

这项研究强调了最新在端到端音乐生成方面的进展,借鉴了图像和语言处理的技术。它强调了在音乐创作中对音频片段进行对齐的挑战,并对现有依赖于抽象条件的模型提出了批评。研究提出了一种训练范式,使用了一种非自回归、基于Transformer的架构,使模型能够对音乐背景做出响应。该方法引入了两个条件源,并将问题框架构建为条件生成。

该方法利用了一种非自回归、基于Transformer的音乐生成模型,通过在单独的音频编码模型中引入残差向量量化器。通过将多个音频通道组合成一个单一的序列元素,采用了嵌套的方法。训练过程中采用了掩码程序,并在进行令牌采样期间使用了无分类器的指导,以增强音频背景的对齐。客观度量包括Fr’echet Audio Distance和音乐信息检索描述符距离等,用于评估模型的性能。

研究团队通过使用标准度量和音乐信息检索描述符方法进行生成模型的评估,包括FAD和MIRDD。与真实音频片段的比较表明,该模型在音频质量上达到了与最先进的文本条件模型相媲美的水平,并展现出与音乐背景的强大音乐连贯性。通过参与音乐培训的参与者进行的Mean Opinion Score测试进一步验证了该模型生成逼真音乐结果的能力。MIRDD对生成和真实音频片段的分布对齐进行评估,提供了音乐连贯性和对齐的度量。

总的来说,这项研究提出了一种新的训练方法,使生成模型能够对音乐背景做出响应。该方法引入了一种非自回归语言模型,具有Transformer骨干和两个未经测试的改进:多源无分类器的指导和迭代解码过程中的因果偏差。通过在开源和专有数据集上进行训练,这些模型实现了最先进的音频质量。标准度量和音乐信息检索描述符方法验证了其音频质量。通过Mean Opinion Score测试确认了该模型生成逼真音乐结果的能力。

项目网址:https://julian-parker.github.io/stemgen/

论文网址:https://arxiv.org/abs/2312.08723

4年来首次下滑 AMD发布Q1季度财报:锐龙处理器成重灾区

快科技5月3日消息,AMD今天凌晨发布了截至4月1日的Q1季度财报,在当前的大环境下,AMD的业绩也同样遭受了考验,营收创新了2019年以来首次下滑,其中锐龙处理器成为营收下滑的重灾区。Q1季度中,GAAP规则下营收53.53亿美元,同比下滑9%,毛利率44%,下滑4个百分点,运营利润25.14亿美元,同比下滑29%,净亏损1.39亿美元,同比下滑118%。站长网2023-05-03 09:22:060000法拉第未来:董事会并未考虑任命贾跃亭为联席 CEO

近日,法拉第未来在其官方声明中明确指出,公司董事会目前并未考虑任命贾跃亭为公司联席CEO的提议。这一声明与贾跃亭此前发布的个人视频声明形成了鲜明对比。站长网2024-05-07 19:48:520000苹果收盘市值达3万亿美元 报收193.97美元

美股周五收盘,苹果公司报收193.97美元,上涨2.31%,收盘市值达到3.05万亿美元。这一成就令苹果成为首家收盘市值达到3万亿美元的公司。今年以来,苹果公司股价累计飙升49%,投行分析师预计,到2025财年,苹果公司估值将达到3.5万亿美元,甚至可能达到4万亿美元。站长网2023-07-02 10:12:380000百度宣布3年开放2.1万个校招实习岗:还要培养AI技术大佬

快科技4月20日消息,日前,百度招聘官宣,未来三年,百度将开放21000个实习岗位给优秀校园人才,并持续加强对实习生的培养,进一步提升实习转正率。据介绍,今年3月,百度已面向在校学生开放3000暑期实习岗位,87%与AI相关,覆盖大模型、机器学习、无人驾驶等领域。0000腾讯云与福建大数据集团发布政务大模型“小闽助手”

4月25日,腾讯云与福建大数据集团正式签署合作协议,以腾讯云智能AI算力调度平台、大语言模型算力及技术能力为基础,共建“福建智力中心”项目,并助力打造互动式政务大模型应用“小闽助手”。据悉,“福建智力中心”是福建省基于大语言模型能力而打造的首个智慧政务平台。而“小闽助手”是福建政务领域发布的首个互动式大模型应用,未来将为广大的福建市民提供零距离、高质量、7X24小时管家式政务的办事体验。站长网2023-04-26 14:04:130003