英伟达提出新技术Tied-LoRA 减少模型训练参数

站长网2023-11-24 13:59:540阅

要点:

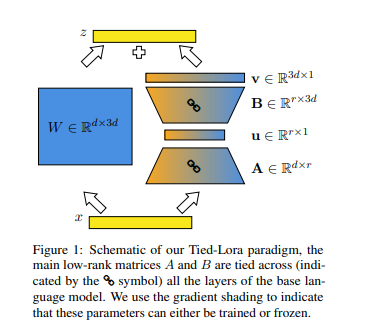

1. Nvidia的研究人员提出了一种名为Tied-LoRA的新技术,旨在改善低秩适应(LoRA)方法的参数效率。

2. Tied-LoRA利用权重绑定和选择性训练,在性能和可训练参数之间寻找最佳平衡。

3. 在对不同任务和基础语言模型进行实验后,研究人员发现在效率和性能之间存在权衡,Tied-LoRA方法可以使用比标准LoRA方法少13%的参数获得相当的性能。

近期,Nvidia的研究人员提出了一种名为Tied-LoRA的新技术,旨在改善低秩适应(LoRA)方法的参数效率。该方法通过将权重绑定和选择性训练结合起来,寻找了在性能和可训练参数之间的最佳平衡。

LoRA方法是一种提高参数效率的微调技术,通过对低秩矩阵进行逼近来减少可训练参数。Tied-LoRA方法通过将权重绑定应用于LoRA中的低秩矩阵,跨基础语言模型的层共享相同的权重,从而减少可训练参数的数量。

论文地址:https://arxiv.org/pdf/2311.09578.pdf

通过在不同任务和基础语言模型上进行系统实验,研究人员确定了特定的Tied-LoRA配置,相较于标准LoRA方法,仅利用13%的参数即可达到可比较的性能。在多个任务上进行的实验显示,Tied-LoRA方法在提高参数效率的同时保持了竞争性能,特定配置(vBuA)在性能上表现优异,减少了87%的参数。

Tied-LoRA是一种有效的方法,通过权重绑定和选择性训练提高了LoRA方法的参数效率,为在实践中应用AI提供了新的可能性。然而,对比其他参数效率方法、讨论局限性并确定未来探索的潜在领域仍然是重要的。

0000

评论列表

共(0)条相关推荐

通义万相首创生成汉字视频,全面进化称霸VBench!AI视频GPT-3时刻来临

【新智元导读】通义万相视频模型,再度迎来史诗级升级!处理复杂运动、还原真实物理规律等方面令人惊叹,甚至业界首创了汉字视频生成。现在,通义万相直接以84.70%总分击败了一众顶尖模型,登顶VBench榜首。Sora、Veo2接连发布之后,AI视频生成的战场又热闹了起来。就在昨天,通义万相视频生成模型迎来了重磅升级!他们一口气推出了两个版本:注重高效的2.1极速版、追求卓越表现的2.1专业版。站长网2025-01-10 14:20:280001董明珠怒斥孟羽童 称孟羽童只想用格力平台去当网红

今年5月,曾被视为董明珠接班人的孟羽童从格力离职,这一消息在网上引起了热议,尤其是关于她的离职原因。近日,董明珠在格力电器2023届大学生入职仪式中再次提及孟羽童,揭露了背后的真相。董明珠表示,当初在实习生节目中看中了孟羽童的勤奋,选她来做秘书。然而,在工作中孟羽童的表现并不尽如人意,她只想着利用格力平台成为网红,在公司中产生了不良影响。因此,董明珠决定将她开除。0000Sora竟是用这些数据训练的?OpenAI CTO坦白惹众怒

采访首次揭示出Sora「有所为(比如,将生成效果逼向极限)」和「有所为不为(比如短期内不开放、不生成公众人物)」背后的深层考量——找到一条将AI融入日常生活的正确道路是极其困难的,但也绝对值得一试。站长网2024-03-16 13:45:240000OpenAI下周将发布ChatGPT搜索引擎,挑战谷歌搜索!

5月3日,前Mila研究员、麻省理工讲师LiorS爆料,根据OpenAI最新的SSL证书日志显示,已经创建了search.chatgpt.com子域名(目前无法访问),将会进军搜索引擎全面挑战该领域的全球霸主谷歌。站长网2024-05-04 17:36:440000马斯克被推特前员工起诉 要求支付至少5亿美元额外遣散费

据CNN报道一名前推特员工于周三向推特及其所有者埃隆·马斯克提起了一项新的诉讼,指控该公司未能在去年11月大规模裁员之前向员工提供其承诺的全部遣散费。这项诉讼是在加利福尼亚州的联邦地区法院提起的集体诉讼,要求法院命令马斯克和推特向前员工支付至少5亿美元的额外遣散费。站长网2023-07-13 23:56:260000