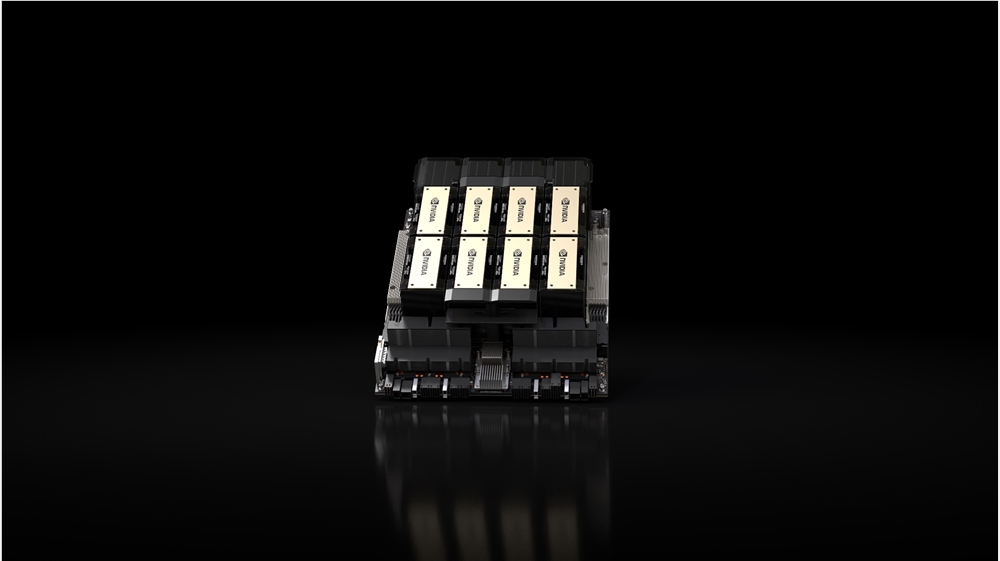

英伟达正式宣布 AI Foundry 服务:与微软 Azure 合作推出 H100 实例,明年推出 H200 实例

英伟达正式宣布推出其 AI Foundry 服务计划,这是一套包括英伟达 AI 基础模型、英伟达 NeMo 框架和工具,以及 DGX 云 AI 超级计算和服务的全方位解决方案,为企业打造和优化定制的生成式 AI 模型。

英伟达 AI Foundry 服务将使通信和媒体提供商的领先软件和服务供应商 Amdocs 能够优化企业级大型语言模型,从而在其业务范围内高效部署生成式 AI 用例,涵盖从客户体验到网络运营和配置。这些 LLM 将作为 Amdocs amAIz 框架的一部分,在英伟达加速计算上运行。

此次合作构建在此前宣布的 Amdocs-Microsoft 合作伙伴关系之上,使服务提供商能够在安全、可信的环境中,包括本地和云端,采用这些应用程序。

新的英伟达 H100 和 H200 Tensor Core GPU 实例将登陆微软 Azure,加速 AI 工作负载

英伟达继续与微软合作构建最先进的 AI 基础设施。作为此项合作的一部分,微软将向 Azure 引入更多基于 H100 的虚拟机,以加速中等规模的 AI 工作负载。

在今天在西雅图举行的 Ignite 大会上,微软宣布了其新的 NC H100 v5 VM 系列,这是业内首个配备英伟达 H100 NVL GPU 的云实例。这一产品将两个基于 PCIe 的 H100 GPU 通过英伟达 NVLink 连接在一起,提供近 4 petaflops 的 AI 计算能力和 188GB 更快的 HBM3 内存。英伟达 H100 NVL GPU 能够在 GPT-3 175B 上提供比上一代高达 12 倍的性能,非常适合推理和主流训练工作负载。

此外,微软宣布计划明年将英伟达 H200 Tensor Core GPU 添加到其 Azure 系列中,以支持更大型模型的推理,同时不降低延迟。这款新产品旨在加速最大的 AI 工作负载,包括 LLM 和生成式 AI 模型。H200 GPU 使用最新一代 HBM3e 内存,在内存容量和带宽方面均有显著提升。

与其前身相比,这款新 GPU 将提供 141GB 的 HBM3e 内存(增加 1.8 倍)和 4.8 TB/s 的峰值内存带宽(增加 1.4 倍)。

云计算迈向机密性

为了进一步扩大 Azure 客户对英伟达加速生成式 AI 计算的可用性,微软宣布了另一个英伟达支持的实例:NCC H100 v5。

这些 Azure 机密虚拟机(VM)配备英伟达 H100 Tensor Core GPU,允许 Azure 客户在使用中保护其数据和应用程序的保密性和完整性,同时访问 H100 GPU 的无与伦比加速性能。这些增强 GPU 的机密 VM 将很快在私有预览中推出。

AI绘图模型不会写字的难题,被阿里AnyText破解了

能准确写汉字的AI绘图工具,终于登场了!包括中文在内一共支持四种语言,而且还能文字的位置还能任意指定。从此,人们终于可以和AI绘图模型的“鬼画符”说再见了。这款名为AnyText的绘图工具来自阿里巴巴,可以按照指定位置精准地向图中加入文字。此前的绘图模型普遍无法准确地向图中添加文字,即便有也很难支持像中文这样结构复杂的文字。0000李国庆称ChatGPT替代不了阅读 后者可以安慰心灵

据《中国企业家》杂志消息,在4月23日的一次读书活动中,当当网创始人李国庆分享了他的观点。李国庆认为,ChatGPT无法取代阅读的作用。阅读不仅可以让人的内心得到平静,也是一种审美享受,这些都是ChatGPT所无法替代的。此外,在晚上睡不着的时候,阅读文学作品能够安慰心灵。而阅读的另一个重要作用则是帮助人们求道解惑。通过阅读,人们可以以较低的成本获得各种知识,这是最有价值的一种投资。站长网2023-04-23 17:34:210000129元 小米有品上架智能电动伞:单手一键2秒开收

快科技7月14日消息,日前,小米有品开启日全时智能电动伞众筹,售价129元。相较于普通雨伞,该智能电动伞内置电机,伞柄配有开伞、收伞两个按键,官方宣称2秒内实现电动开收伞。产品适用场景为下雨天拿快递或超市购物腾不出手开伞,使用该智能电动伞一键即可完成开收伞。据了解,日全时智能电动伞支持Type-C充电,内置280mAh电池,满电可开收伞150次,充电时间90分钟,待机180天。站长网2024-07-14 17:55:080000美国证券交易委员会担心生成式AI会加剧金融市场风险

美国证券交易委员会(SEC)对生成式人工智能对金融市场的影响表示担忧。美国SEC主席GaryGensler在一次演讲中表示,生成式人工智能可能会增加金融市场的风险,因为它可能会导致金融机构使用不准确或不相关的信息做出错误决策。站长网2023-07-18 12:38:530000逆天!AI也能做游戏?百度智算大会上的这个项目“靓”了

没有代码,没有游戏开发工程,你想象过20分钟内可以制作出一款游戏吗?AI可以创作出爆款文案,写小说,搞视频脚本,写代码,出海报,还能生成3D空间。如今又有一个项目将AI的应用场景延伸到了新领域。没有代码,没有游戏开发工程,你想象过20分钟内可以制作出一款游戏吗?在AI技术的迭代下,这已然成为了现实。0000