多模态音乐AI框架Video2Music 为视频生成情感相符的音乐

近日,一款创新的人工智能多模态音乐生成框架Video2Music引起了广泛关注。该框架利用独特的数据集和经过用户研究验证的转换器模型,能够为视频生成情感上相符的音乐,填补了这一领域的空白。据悉,Video2Music的GitHub Repo已经发布,为研究人员和音乐爱好者提供了一个全新的工具。

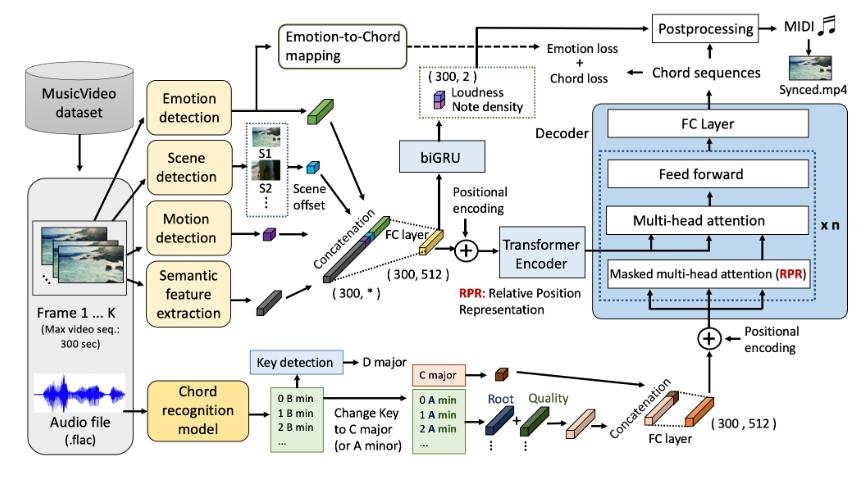

Video2Music的AI框架是一项非常有前景的技术,它能够根据视频内容自动生成情感相符的音乐。它采用了一种前沿的 Transformer 模型,以视频特征作为输入条件,生成与视频匹配的音乐。这一框架的目标是为视频创作者提供一种无缝高效的解决方案,用于生成定制的背景音乐。

项目地址:https://github.com/amaai-lab/video2music

这一框架的独特之处在于它利用了经过用户研究验证的转换器模型,确保了生成音乐与视频情感的贴合度。通过对独特的数据集进行训练,该框架可以准确捕捉视频中的情感变化,并将其转化为音乐的情感表达。

Video2Music的出现为视频和音乐的结合提供了新的思路,为用户创造了更加个性化和情感丰富的体验。期待这一技术能够在未来得到更广泛的应用,为音乐和视频领域带来更多的可能性。

核心功能:

利用 Transformer 架构生成音乐:Video2Music 以视频特征作为输入,使用 Affective Multimodal Transformer(AMT)模型生成音乐。这意味着生成的音乐将与视频内容相匹配,为视频创作者提供更好的音乐配乐选项。

高级音乐生成技术:Video2Music 使用先进的技术,包括 Bi-GRU 回归模型,用于预测音符密度和音量,以确保生成的音乐在音质和音量方面达到最佳效果。

数据集支持:该产品附带了 MuVi-Sync 数据集,包括视频特征、原始视频和原始音频,以支持模型训练和生成。这使用户可以轻松访问用于生成音乐的必要数据。

模型训练和推理:Video2Music 提供了用于模型训练和推理的脚本,用户可以根据自己的需求自定义训练和生成过程,以获得最佳的音乐生成结果。

引用支持:如果用户认为这一资源对其有用,可以轻松引用原始工作,使研究和创作更具可信度。这有助于学术和创作领域的知识传播。

这个五一档,韩寒赢麻了

如果不是这个五一档,大概很多人已经想不起韩寒了。他在大众脑海中的形象,被定格在2022年春节档《四海》的见面会“四海歌会”上。那时,他穿着毛衣,把头发剪成圆寸,戴着黑框眼镜,站在舞台最左侧,卖力地和曾经合作过的演员们合唱,为即将在春节档上映的《四海》宣传。站长网2023-05-07 09:25:440002百度规范流量环节传播秩序 处置违规问题账号2555个

昨日,百度公布了“清朗·规范重点流量环节网络传播秩序”专项工作的工作进展。百度表示,本阶段共排查处置违规采编新闻信息、仿冒新闻媒体等违规问题账号2555个,包括涉及仿冒新闻主播账号2174个,涉及炮制新闻虚假信息账号20个,涉及“自媒体”违规发布导向不良时政信息361个。清理违规信息201条。站长网2023-04-21 08:37:340003AI同事来了,我开始失业倒计时?

OpenAI又发新品了,但这次不是语言模型,也不是更会聊天的新ChatGPT,而是一个全新的AI智能体。当地时间1月23日,OpenAI发布Operator,这是一个可以上网为用户执行任务的智能体。用OpenAI的话说就是:“一种能够独立为你工作的AI——你给它任务,它为你执行。”0000脱离传统录音方式?AI配音神器虾果魔音让配音更简单

虾果魔音是中国中芯网络科技有限公司开发的一款引人注目的AI配音神器。该软件以其高度拟人和流畅自然的人声配音功能而著称。用户可以轻松将文字转化为语音,并从近百种不同发音人中选择适合的配音。虾果魔音支持多种情绪和语言,包括中文、英文、童声、方言和广告旁白等10类近百种发音人,为各种使用需求提供了丰富的选择。体验地址:https://moyin.ixiaguo.com/站长网2023-10-28 07:49:190000生成式大模型的远水,解不了智能手机厂商的近渴

生成式大模型的这把火,还是从互联网市场烧到了智能手机市场。继国内五大智能手机厂商相继将生成式大模型落地智能手机后,三星在GalaxyS24系列上也与谷歌深度合作带来了其宣称的首款AI手机;而作为2023年全球智能手机销冠的苹果,据报道称其在内部也早已在测试一款名为Ajax的生成式大模型,用于提升Siri的智能水平,而这也或将是iOS18操作系统最为重大的更新。站长网2024-01-31 17:25:200000