AI圈巨震!微软论文曝光GPT-3.5参数量仅有200亿

要点:

微软论文爆料GPT-3.5的参数量仅为20B,远小于之前官方宣布的1750亿,引发广泛关注和争议。

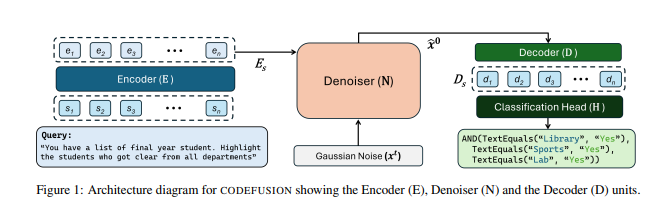

微软的论文介绍了一个小规模扩散模型CodeFusion,性能出色,只有7500万参数,与大型模型相媲美。

论文讨论了CodeFusion模型的架构和性能表现,对GPT-3.5的真实参数量提出了质疑,但仍需等待官方开源数据揭晓。

最近,微软的一篇论文引发了广泛讨论,揭示了GPT-3.5的真实参数量可能只有20B,远远小于之前官方宣布的1750亿。这一曝料在AI圈内引起了巨大的震动,让人们开始重新评估这一庞大模型的性能和潜力。此论文还介绍了一个小型扩散模型CodeFusion,它只有7500万参数,但在性能方面与大型模型相媲美,引发了人们对模型规模与性能之间的关系的思考。

CodeFusion是一个用于代码生成的模型,经过两个阶段的训练,使用无监督预训练和有监督微调的方法,不断提升其性能。在性能评估中,CodeFusion在top-1准确率方面表现出色,尤其在Python任务中,几乎与GPT-3(175B参数)相媲美。而在top-3和top-5设置下,CodeFusion明显优于其他基线模型。

论文地址:https://arxiv.org/pdf/2310.17680.pdf

然而,最引人关注的是GPT-3.5的参数量。以前人们普遍认为它有1750亿参数,但这篇论文声称它只有20B。这个巨大的参数量差异引发了广泛的猜测和讨论。一些人认为这可能是作者的手误,但也有人认为这一参数估计是准确的,因为一些小型模型在性能上与GPT-3.5相媲美。此外,还有人提出了对GPT-3.5的性能和参数量进行更深入研究的问题,以更好地理解这一庞大模型。

尽管这一论文引发了许多争议,但我们仍需等待官方的数据披露以确定GPT-3.5的真实参数量。这个问题引发了关于模型规模与性能之间关系的深刻思考,以及对GPT-3.5是一个小专家模型的集成还是通才模型的质疑。这一争议仍在继续,只有等待更多信息的揭晓才能解开谜团。

AI视野:蚂蚁集团开源代码大模型CodeFuse;Meta计划推出新的AI模型;腾讯乐享发布“乐享 AI 助手”

>>>>>大模型动态<<<<<蚂蚁集团开源代码大模型CodeFuse蚂蚁集团在外滩大会上正式开源了自主研发的代码生成大模型CodeFuse。CodeFuse可以根据开发者输入快速生成代码、添加注释、编写测试用例等,能显著提高研发效率。项目地址:https://huggingface.co/codefuse-ai要点:站长网2023-09-11 16:22:550000全球最大的 ChatGPT 开源替代品来了,支持 35 种语言,网友:不用费心买 ChatGPT Plus了!

自去年11月ChatGPT面向公众测试以来,OpenAI一直占据各大科技网站的头版头条,以及成为很多开发者工具的首选。ChatGPT的落地不仅仅可以提供代码建议、总结长文本、回答问题等等,更为重要的是它开启了AIGC的新时代。站长网2023-04-17 16:58:250000腾讯牵头制定全球首个金融风控大模型国际标准

据腾讯云智能官方消息,11月30日,由腾讯主导发起的全球首个金融风险控制领域的大模型国际标准在深圳召开的IEEE金融风控大模型标准启动会上正式发布。这个标准旨在为金融机构的风控建模环节中应用AI大模型技术提供参考和指引,使金融机构能够在日益复杂和数据驱动的金融环境中高效预测、衡量和管理业务风险。站长网2023-12-01 14:09:420000孟羽童称正在筹备新公司 社交平台账号视频报价28万一条

孟羽童今日在社交平台上分享了自己过去一年作为自由职业者的工作经历,并宣布正在筹备成立新公司。她透露,虽然自己只是新公司的小股东之一,但合伙人包括行业内资深的前辈和知名导演制片人。新公司的业务将聚焦于影视文化及广告传媒领域。站长网2024-09-11 15:24:590000谷歌推出Chromebook Plus 瞄准AI PC市场

**划重点:**1.🤖谷歌推出ChromebookPlus,挑战微软在AIPC领域的努力。2.💼宏碁发布首款商用ChromebookPlus514,搭载AI应用,标志着谷歌在商务领域的发展。3.💻作为AIPC的竞争对手,谷歌在智能笔记本领域展示出强劲实力。站长网2023-12-27 15:00:450001