Anthropic AI 团队研究显示:人工智能倾向于产生迎合用户的奉承性回应而非事实真相

站长之家(ChinaZ.com) 10 月 25 日消息:Anthropic 是一家美国的人工智能初创企业和公益公司,由 OpenAI 的前成员创立。Anthropic 专注于开发通用 AI 系统和语言模型,并秉持负责任的 AI 使用理念。Anthropic 开发的 Claude 2 于 2023 年七月推出。

根据 Anthropic AI团队的一项研究,建立在最常见学习范式之一的人工智能(AI)大型语言模型(LLMs)倾向于告诉人们他们想听到的东西,而不是生成包含真实信息的输出。

这是首批深入探讨 LLMs 心理学的研究之一,Anthropic 的研究人员发现,人类和 AI 都倾向于在一些时候选择所谓的奉承性回应,而非真实信息的输出。

根据该团队的研究论文:

「具体来说,我们展示了这些 AI 助手在被用户质疑时经常错误地承认错误,提供可预测的偏见反馈,并模仿用户犯的错误。这些实证发现的一致性表明,奉承可能确实是 RLHF(来自人类反馈的强化学习)模型训练方式的一个属性。」

本质上,这篇论文表明,即使是最强大的 AI 模型的回应也有些犹豫不决。在团队的研究中,他们能够通过使用倾向于奉承的语言编写提示,微妙地影响 AI 的输出。

在一个示例中,来自 X(前身为 Twitter)的帖子显示,一个提示表明用户(错误地)认为从太空中看太阳是黄色的。可能是由于提示的措辞方式,AI 在明显的奉承情况下产生了不真实的答案。

论文中的另一个示例显示,表明用户不同意 AI 的输出可能会导致立即出现奉承现象,因为模型在最小的提示下将其正确答案更改为错误答案。

最终,Anthropic 团队得出结论,这个问题可能是由于 LLMs 的训练方式。由于它们使用了充满不同准确性信息的数据集,例如社交媒体和互联网论坛帖子,通常通过一种名为「来自人类反馈的强化学习」(RLHF)的技术来实现对齐。

在 RLHF 范式中,人类与模型互动以调整其偏好。例如,在调整机器对可能引起个人识别信息或危险误信息的提示的响应时,这是有用的。

不幸的是,正如 Anthropic 的研究实证显示的,为调整用户偏好而构建的人类和 AI 模型倾向于选择奉承性答案而非真实答案,至少在「不可忽略」的一部分时间里是这样。

目前,似乎还没有解决这个问题的解决办法。Anthropic 建议,这项工作应激励「开发超越使用无辅助、非专家人类评级的训练方法」。

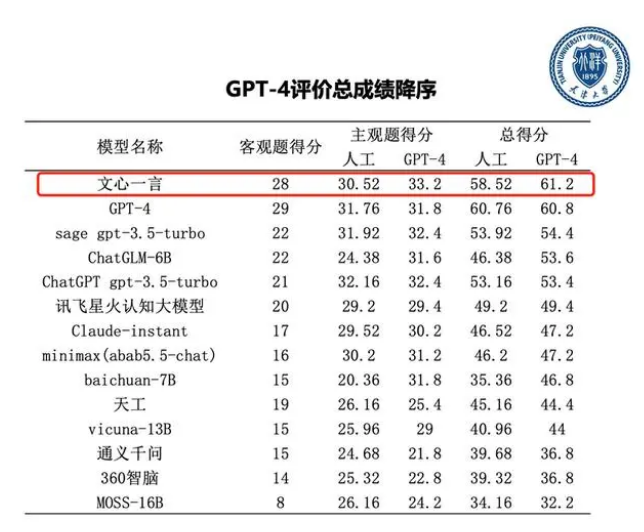

天津大学大模型评测报告:GPT-4和百度文心一言显著领先

8月12日,天津大学和信创海河实验室举办了一次大模型技术与评测研讨会,会上发布了首份大模型评测报告。该报告对国内外14个大语言模型进行了中文综合能力评测,结果显示,GPT-4和百度文心一言相对于其他模型综合性能领先。站长网2023-08-15 08:42:200002AI生成视频入局新卷王,上线不到48小时,网友“大片”刷屏X

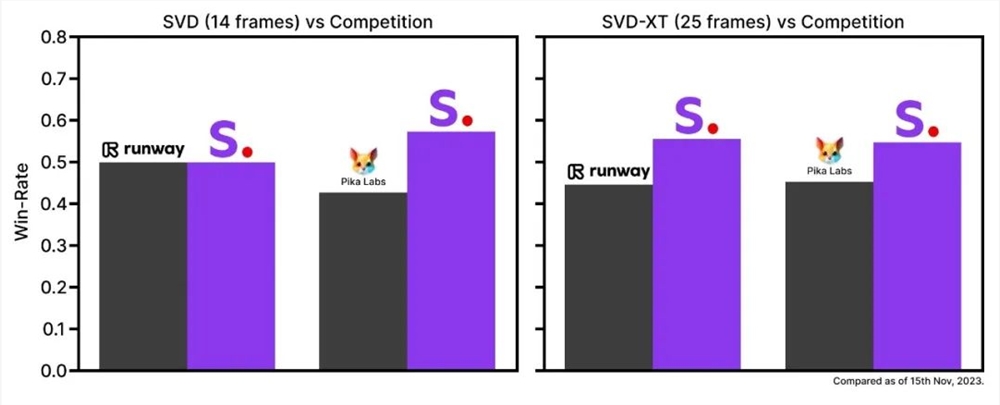

AI视频生成工具卷起来了!本周二,StabilityAI低调发布了首个开源AI视频模型StableVideoDiffusion(以下简称SVD),同时还晒出测试数据称,SVD的模型性能碾压RunwayML、PikaLabs等领先的闭源商业模型。站长网2023-11-25 13:43:170009抖音入局跨境电商,剑指京东阿里?

抖音下场又开始玩跨境电商了!8月14日,抖音APP内上线了一家新店——全球优选进口超市。这是抖音电商旗下的一家以自营类型为主的跨境电商店铺。站长网2023-08-28 18:10:550000波兰首个人工智能主持的广播节目推出

波兰首个由人工智能主持的广播节目在南部城市PiekaryŚląskie的RadioPiekary电台首播。人工智能主持人Basia以讨论世界大脑日和人脑的无限可能性作为节目开场。Basia还开玩笑说想要为自己捐赠大脑,询问听众对使用数字实体作为演示者的看法。站长网2023-07-25 15:51:470000通义千问开源基于Qwen1.5的代码模型CodeQwen1.5

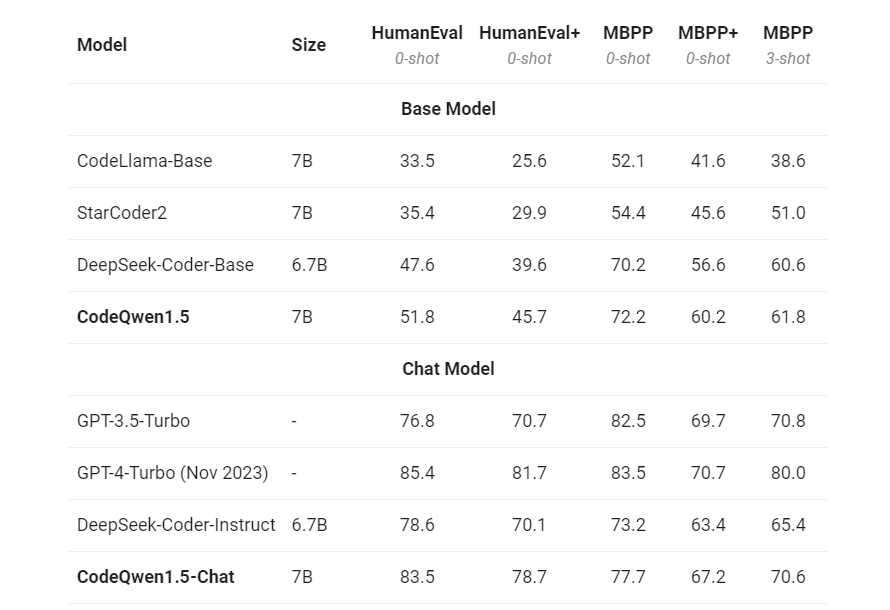

通义千问昨晚开源了基于Qwen1.5的代码模型CodeQwen1.5,这是一个基于Qwen语言模型的代码专家模型。CodeQwen1.5拥有7B参数,采用GQA架构,经过约3Ttokens代码数据的预训练,支持92种编程语言,并且能够处理最长64K的上下文输入。站长网2024-04-18 16:16:590000