全新视觉提示方法SoM 让GPT-4V看的更准、分的更细

要点:

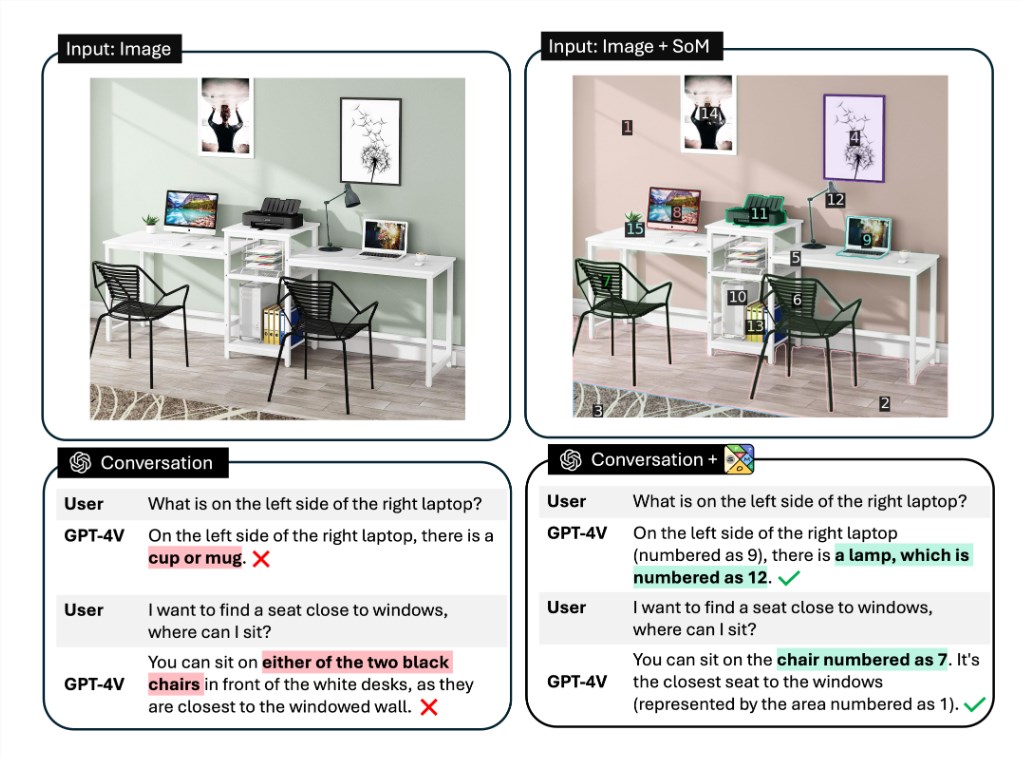

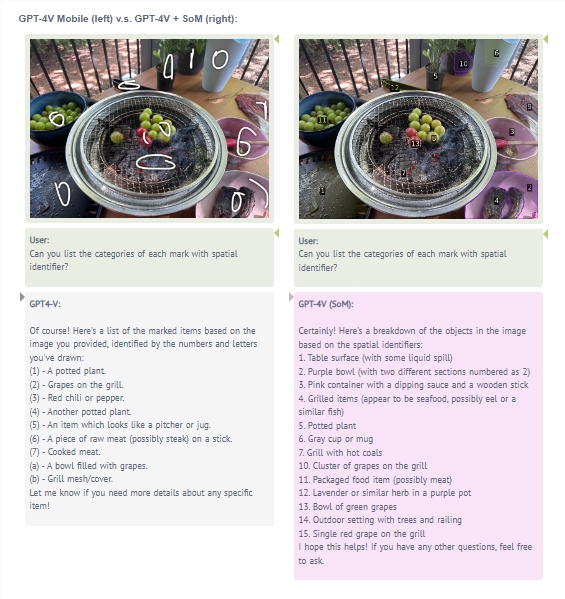

提出了一种新的视觉提示方法 SoM,可以让 GPT-4V 在细粒度视觉任务上有更好的表现。

SoM 通过使用交互式分割模型将图像划分为不同区域,并在每个区域上添加标记,如字母数字、掩码或框。

SoM 可以让 GPT-4V 适用于多种视觉任务,如开放词汇图像分割、参考分割、短语关联和视频对象分割,并在各个数据集上取得了优于专用模型和其他开源多模态模型的性能。

研究人员推出了一种新的视觉提示方法 Set-of-Mark(SoM),它可以让 OpenAI 多模态大模型 GPT-4V 在视觉内容理解方面有了质的提升。GPT-4V 是一种基于 GPT-4的多模态模型,可以同时处理文本和图像,并生成多种类型的输出。

然而,GPT-4V 在细粒度 visual grounding(输入是图片和对应的物体描述,输出是描述物体的 box)能力相对较弱,或者尚未发挥出来。为了解决这个问题,研究人员提出了 SoM 方法,它可以让 GPT-4V 在不需要任何微调或额外数据的情况下,完成各种细粒度视觉任务。

论文地址:https://arxiv.org/pdf/2310.11441.pdf

论文主页:https://som-gpt4v.github.io/

SoM 的核心思想是使用交互式分割模型(例如 SAM)将图像划分为不同粒度级别的区域,并在这些区域上添加一组标记(mark),例如字母数字、掩码(mask)、框(box)。使用添加标记的图像作为输入,以解决上述问题。

研究人员认为,这种方法可以让 GPT-4V 更好地理解图像中的物体和空间关系,并且可以利用 GPT-4V 的生成能力来产生文本之外的输出,如掩码或框。

研究人员在多个视觉任务上评估了 SoM 的效果,包括开放词汇图像分割、参考分割、短语关联和视频对象分割。他们使用不同的分割工具来提出图像区域,并使用简单的 prompt 工程来引导 GPT-4V 生成所需的输出。他们还使用了「分而治之」(divide-and-conquer)的策略来运行实验和评估,即对于每个实例,他们使用新的聊天窗口,这样一来,评估期间就不会出现上下文泄露了。

研究人员将 SoM 与以下模型进行比较:预测坐标的 GPT-4V 基线模型、SOTA 专用模型和开源 LMM。结果显示,SoM 可以让 GPT-4V 在各个数据集上取得了优于专用模型和其他开源多模态模型的性能。特别是,在 COCO 和 ADE20K 上的开放词汇图像分割任务上,SoM 的零样本性能接近微调后的 MaskDINO,并大幅优于 OpenSeeD。

在 RefCOCOg 上的参考分割任务上,SoM 击败了 PolyFormer 和 SEEM 等专用模型以及 Shikra、LLaVA-1.5、MiniGPT-v2和 Ferret 等最近的开源 LMM。在 Flickr30K 上的短语关联任务上,SoM 实现了比 GLIPv2和 Grounding DINO 更强的零样本性能。在 DAVIS2017上的视频对象分割任务上,SoM 实现了优于其他专用视觉模型的最佳追踪性能(78.8J&F)。

研究人员还进行了消融研究,探讨了标记类型和真值掩码对 SoM 的影响。结果表明,添加额外的框可以显著提升性能,而使用真值掩码可以将参考分割的性能提升14.5%(mIoU)。这些结果表明了 SoM 的有效性和灵活性,以及 GPT-4V 在细粒度视觉任务上的潜力。

周鸿祎:国内大模型上来就说超越 那叫吹牛

周鸿祎日前在新东方创始人俞敏洪抖音直播间和东方甄选抖音直播间,谈及对最近国内大模型创业扎堆与ChatGPT的看法。站长网2023-05-08 14:04:040002微软斥资32亿美元大力投资英国人工智能领域

**划重点:**1.💰微软计划在英国投资32亿美元,将人工智能数据中心扩大一倍,为100多万人提供培训。2.🌐投资包括在伦敦和威尔士卡迪夫扩建数据中心,提供2万多个图形处理单元,并加强对英国研究人员的支持。3.🚀投资旨在推动英国的人工智能行业,培训人才,加强基础设施,标志着微软40年来在英国的最大一笔投资。站长网2023-12-06 10:05:520001ChatGPT 最强代码解释器突破“封印”:30 秒出片、5 分钟制作游戏、可视化分析...样样精通!

20美元,雇佣一位非常擅长数据分析的个人AI助理,到底值不值?现在,OpenAI正在让用户这20美元花得更值。站长网2023-07-16 05:52:280001造富神话破灭,AI公司排队卖身

AI大模型不光有造富神话,同样也有破产、倒闭、求收购。2024年第二季度还没有结束,美国AI公司就开始倒闭热潮。曾经有10亿美元估值、180名员工、创造出StableDiffusion系列模型的明星创企StabilityAI,传出资金链断裂,正在寻求合并的消息。00004000米高空一跃而下、以女性视角重看历史,解锁抖音精选的创作密码

变成一颗流星是什么感觉?@阿宇的疯狂冒险带着这个疑问,自制高速载人飞行翼,从4000多米的高空一跃而下。并通过十几分钟的视频,将这个过程分享给无数抖音用户,最终收获了百万点赞。当下,抖音出现了许多优质创作者,他们创新表达方式,为用户带来新鲜感;深耕领域知识,为用户带来深度知识内容;他们以兴趣为驱动,探索世界与自己的边界,带着用户冲向一个个冒险。站长网2024-12-26 21:25:010000