RingAttention:一种降低Transformer内存需求的新AI技术

划重点:

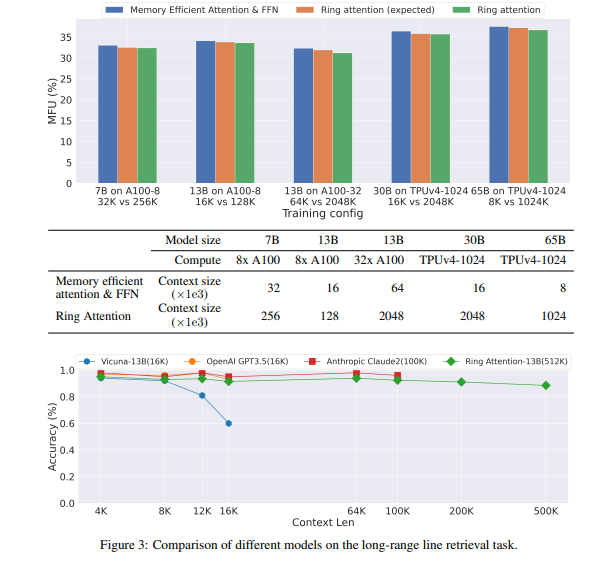

1. Transformer模型在处理长序列时面临的内存需求挑战,UC伯克利研究人员提出的RingAttention方法。

2. RingAttention通过将自注意力和前馈网络计算块块地分布在多个设备上,实现了内存高效,允许训练超过500倍长度的序列。

3. RingAttention的潜在应用领域,包括大型视频-音频-语言模型和理解科学数据。

UC伯克利的研究人员提出了一项名为RingAttention的新方法,以解决深度学习模型中内存需求的挑战。在最新的研究中,研究人员探讨了Transformer模型在处理长序列时面临的问题,特别是由于自注意力机制引发的内存需求。这一问题已经成为了在人工智能领域中提高模型性能的一个重要挑战。

Transformer模型是一种在自然语言处理等领域取得了重大突破的深度学习架构。它基于自注意力机制,可以在进行预测时权衡输入序列的不同部分的重要性。然而,随着输入序列长度的增加,内存需求呈二次增长,这导致了在处理长序列时的挑战。

UC伯克利的研究人员提出了RingAttention方法,通过将自注意力和前馈网络计算分块进行,可以将输入序列分布到多个设备上,从而实现内存高效。这一方法的关键思想是将计算块块块地分布在多个设备上,同时保持内存消耗与块大小成比例。这意味着每个设备的内存需求与原始输入序列长度无关,从而消除了设备内存的限制。

研究人员的实验证明,RingAttention可以将Transformer模型的内存需求降低,使其能够训练比以前的内存高效方法长500倍以上的序列,而不需要对注意力机制进行近似。此外,RingAttention还允许处理长度超过1亿的序列,为处理大规模数据提供了可能性。

尽管这项研究仅涉及方法的有效性评估,而未进行大规模训练模型,但这一方法的性能取决于设备数量,因此还需要进一步的优化。研究人员表示,他们将来计划在最大序列长度和最大计算性能方面进行更多研究,这将为大型视频-音频-语言模型、利用扩展反馈和试验错误学习、代码生成和理解科学数据等领域提供激动人心的机会。

论文网址:https://arxiv.org/abs/2310.01889

Google Photos即将允许用户自定义AI生成视频亮点

划重点:-GooglePhotos即将推出更新,允许用户自定义AI生成的视频亮点。-用户可以选择要包含在视频中的内容,如人物、地点和活动,以获得更个性化的视频。-更新将使用户能够剪辑、重新排列和更换视频中的音乐。0000阿里巴巴:未来3年加大三大AI领域投入 将超过去10年总和

阿里巴巴加大AI投入,三大领域重点布局阿里巴巴集团CEO吴泳铭在2025财年第三季度财报会议中宣布,公司将加大对AI的投入,重点围绕三大领域展开:AI和云计算基础设施建设:提升AI和云计算的底层支撑能力。AI基础模型平台及AI原生应用:开发先进的AI基础模型和促进AI原生应用的创新。现有业务的AI转型升级:利用AI赋能现有业务,提升效率和竞争力。0000余承东入驻抖音3天涨粉200万,企业老板为何扎堆做自媒体?

刚刚入驻抖音就登上热搜,未发布任何内容就涨粉40多万,“遥遥领先”的余承东果然强的可怕。据「KOL使用手册」观察,截至发稿前,余承东在抖音累计获赞404万,粉丝高达282万。图片源自抖音今年是企业老板扎堆做自媒体的一年,雷军、周鸿祎等知名企业家都相继登上热搜。「KOL使用手册」不禁要问:为何老板们都要做自媒体呢?登上热搜的老板们“今天,我正式入驻抖音了。”0001ComfyUI-Mana-Nodes:一个好玩的ComfyUI插件 可自定义字体动画

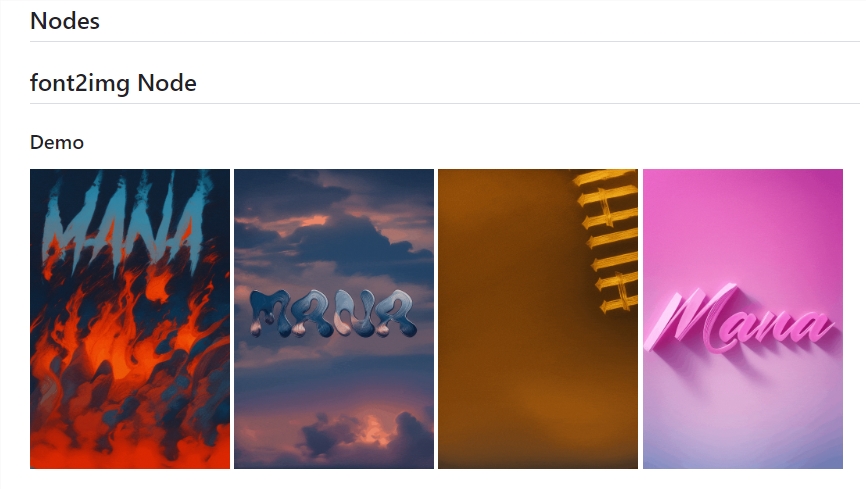

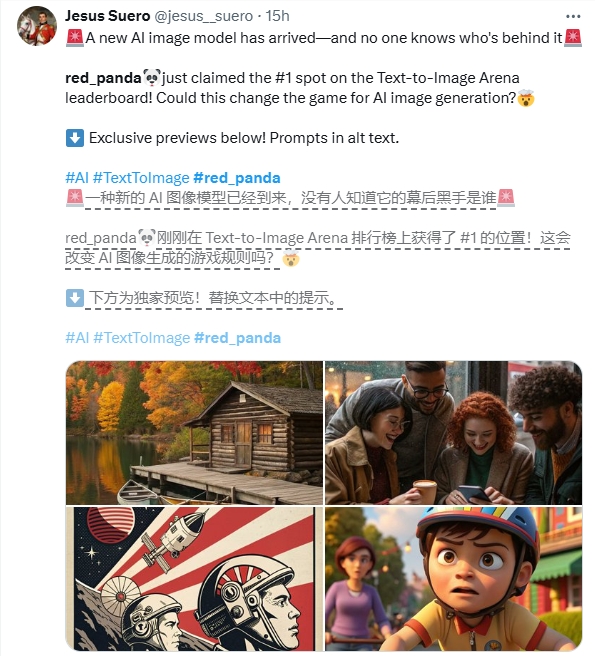

最近,一个好玩的ComfyUI插件ComfyUI-Mana-Nodes受到网友关注。这款插件支持生成自定义程度极高的字体动画,为用户带来全新的视觉体验。用户可以根据自己的喜好,自定义字体动画的背景颜色、字体颜色,以及文本的对齐方式。此外,用户还可以调整文本行之间的间距,实现更加个性化的效果。项目地址:https://top.aibase.com/tool/comfyui-mana-nodes站长网2024-03-04 19:15:180002AI日报:神秘AI模型Red_panda横空出世;xAI为Grok添加图像理解功能;更多特效的PixVerse V3发布

欢迎来到【AI日报】栏目!这里是你每天探索人工智能世界的指南,每天我们为你呈现AI领域的热点内容,聚焦开发者,助你洞悉技术趋势、了解创新AI产品应用。新鲜AI产品点击了解:https://top.aibase.com/1、生图能力超越Flux1.1Pro!神秘AI模型红熊猫Red_panda横空出世站长网2024-10-29 16:01:050001