首个多模态开放世界检测大模型MQ-Det登场,精确率提升7.8%

要点:

1. MQ-Det是首个多模态开放世界检测大模型,通过融合文本描述和视觉示例查询,提升了目标检测精确率7.8%。

2. MQ-Det的设计包括门控感知模块和视觉为条件的掩码语言预测训练策略,使其兼容现有检测大模型且具备多模态查询能力。

3. 实验结果表明,MQ-Det在LVIS基准数据集上取得显著的性能提升,支持finetuning-free和小样本检测,展现了多模态查询目标检测的潜力。

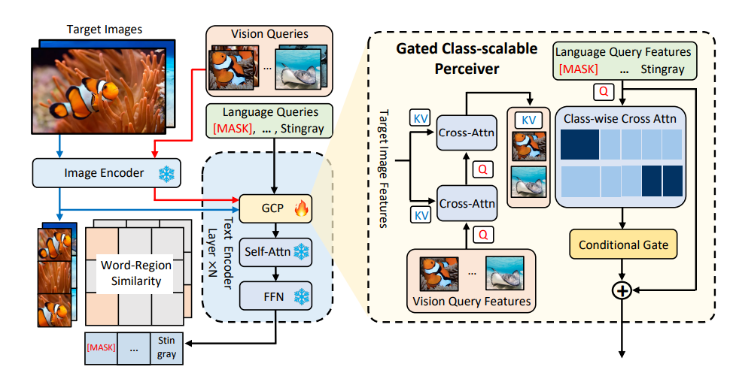

MQ-Det是一款革命性的多模态开放世界检测大模型,在NeurIPS2023首次亮相,引起广泛关注。该模型的核心创新在于融合了文本描述和视觉示例查询,以显著提升目标检测的精确率,整体性能提高了7.8%。

论文链接:https://arxiv.org/abs/2305.18980

代码地址:https://github.com/YifanXu74/MQ-Det

以往的目标检测模型主要采用文本查询的方式,通过类别文本描述在图像中查找目标。然而,这种方式存在一个问题,即无法处理细粒度的目标信息以及类别歧义。MQ-Det通过引入视觉示例查询功能,弥补了这些问题。视觉示例可以提供更丰富的目标特征线索,同时文本查询具有强大的泛化性能。MQ-Det的设计结合了这两种查询方式,使用户可以更灵活地适应不同场景的需求。

MQ-Det的设计包括门控感知模块(GCP)和视觉为条件的掩码语言预测训练策略。GCP模块嵌入在已有文本查询检测大模型中,用于接收视觉示例的输入,提升检测器的多模态查询性能。此外,MQ-Det采用了一种视觉为条件的掩码语言预测训练策略,解决了模型学习惰性的问题,从而更好地利用新加入的视觉查询特征。

实验结果表明,MQ-Det的性能在开放世界目标检测中表现出色。不仅支持传统的finetuning-free评估策略,还在小样本检测任务上表现出色。在LVIS基准数据集上,MQ-Det实现了显著的性能提升,特别是在GLIP精度上提高了超过7%。这表明多模态查询目标检测具有巨大的前景,可用于实际应用领域,弥补了以往文本查询模型在细粒度信息方面的不足。MQ-Det的问世为多模态目标检测带来了新的机遇,为开放世界检测领域注入了新的活力。

腾讯云智能小样本数智人生产平台发布 支持多模态数据输入

昨日,腾讯云智能小样本数智人生产平台首次对外发布,平台具有训练样本小、生产效率高、自动化生产等特性。只需要3分钟真人口播视频、100句语音素材,平台便可通过音频、文本多模态数据输入,实时建模并生成高清人像,在24小时内制作出与真人近似的“数智人”。站长网2023-04-26 08:54:440003马斯克宣布SpaceX星舰第五次试飞时间:预计 8 月底或 9 月初

在最近一次星舰试飞取得成功后,埃隆·马斯克宣布,SpaceX的下一次试飞将挑战更高难度,计划利用发射塔的机械臂来捕捉并回收“超重助推器”。站长网2024-07-30 08:43:410000Whimsical:超好用的AI生成思维导图工具

Whimsical是一个集白板和文档于一体的协作中心,它将图表、白板等多种工具融合在一起,成为一个统一的协作平台。Whimsical为用户提供了AI文本转流程图的功能,可以快速找到灵感,并且有各种模板和构件可供选择,帮助用户快速将想法变为现实。体验地址:https://top.aibase.com/tool/whimsical站长网2024-01-18 14:49:410000老黄深夜炸场,世界最强AI芯片H200震撼发布!性能飙升90%,Llama 2推理速度翻倍,大批超算中心来袭

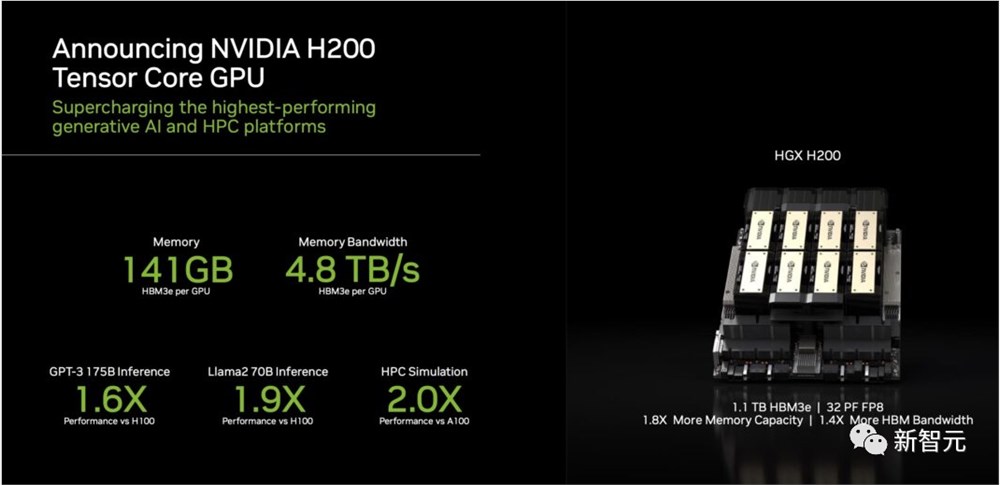

【新智元导读】刚刚,英伟达发布了目前世界最强的AI芯片H200,性能较H100提升了60%到90%,还能和H100兼容。算力荒下,大科技公司们又要开始疯狂囤货了。英伟达的节奏,越来越可怕了。就在刚刚,老黄又一次在深夜炸场——发布目前世界最强的AI芯片H200!较前任霸主H100,H200的性能直接提升了60%到90%。站长网2023-11-14 08:59:500000微软必应聊天推出企业版 并上线多模式视觉搜索图片功能

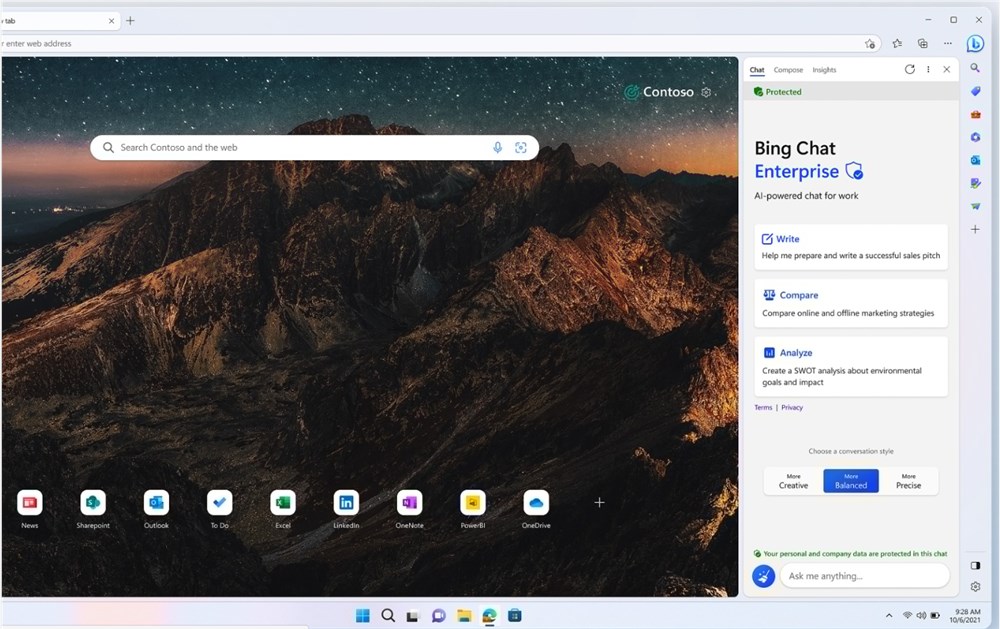

昨日,微软宣布,必应聊天企业版(BingChatEnterprise)以预览版的形式正式推出,此外还将同时推出多模式视觉搜索功能。据介绍,使用必应聊天企业版,用户和业务数据受到保护,不会泄漏到组织外部。聊天数据不会保存,也不会用于训练模型。站长网2023-07-19 12:35:200000