Google DeepMind提出DRaFT算法以高效优化扩散模型

要点:

1、Google DeepMind提出了直接奖励微调(DRaFT)的概念,可以高效微调扩散模型以最大化可微的奖励函数。

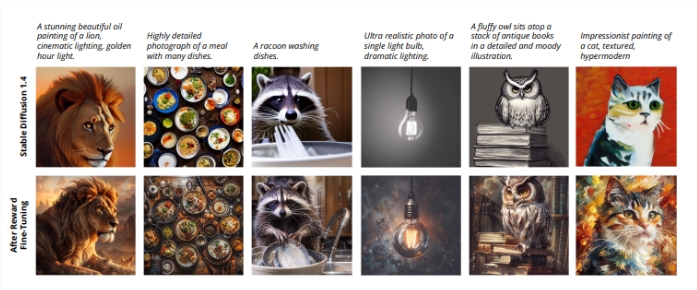

2、引入DRaFT-K和DRaFT-LV算法,限制反向传播步数,提高效率。实验证明优于全反向传播。

3、在Stable Diffusion1.4上应用DRaFT,结果显示其效率远超基于强化学习的微调基线。DRaFT-LV效率最高。

扩散模型已经革新了各类数据的生成建模。但是在实际应用中,如根据文本描述生成美观图像,仍需要微调模型。目前文本到图像的扩散模型采用无分类器指导和精心设计的数据集如LAION美学数据集来提升图像质量和模型对齐性能。

论文地址:https://arxiv.org/abs/2309.17400

在研究中,Google DeepMind提出了一种直接而高效的基于梯度的奖励微调方法,其核心是将扩散采样过程微分化。他们提出了直接奖励微调(DRaFT)的概念,其本质是反向传播整个采样链,通常表示为具有50步长度的展开计算图。为有效管理内存和计算成本,他们采用梯度检查点技术,优化LoRA权重而不是修改全部模型参数。

此外,Google DeepMind还提出了DRaFT方法的改进,以提升其效率和性能。首先是DRaFT-K,其限制采样时仅反向传播最后K步时的梯度计算。实验结果显示,与全反向传播相比,这种截断梯度方法的性能明显更好,因为全反向传播会导致梯度爆炸问题。

另外,研究人员提出了DRaFT-LV,其平均多个噪声样本来计算更低方差的梯度估计,进一步提高方法效率。

研究人员在Stable Diffusion1.4上应用DRaFT,使用各种奖励函数和提示进行评估。他们的梯度方法相比基于强化学习的微调基线,效率优势明显。例如,在最大化LAION美学分类器分数时,与强化学习算法相比取得了200倍的加速。

他们提出的变体DRaFT-LV展现出卓越的效率,学习速度约为先前梯度微调方法ReFL的两倍。此外,他们证明了DRaFT可以与预训练模型组合或插值,通过混合或缩放LoRA权重来实现。

总之,直接在可微奖励上微调扩散模型是一个提升生成建模技术的有前景的方向。其效率、通用性和有效性使其成为机器学习和生成建模领域研究者和从业者的有价值工具。

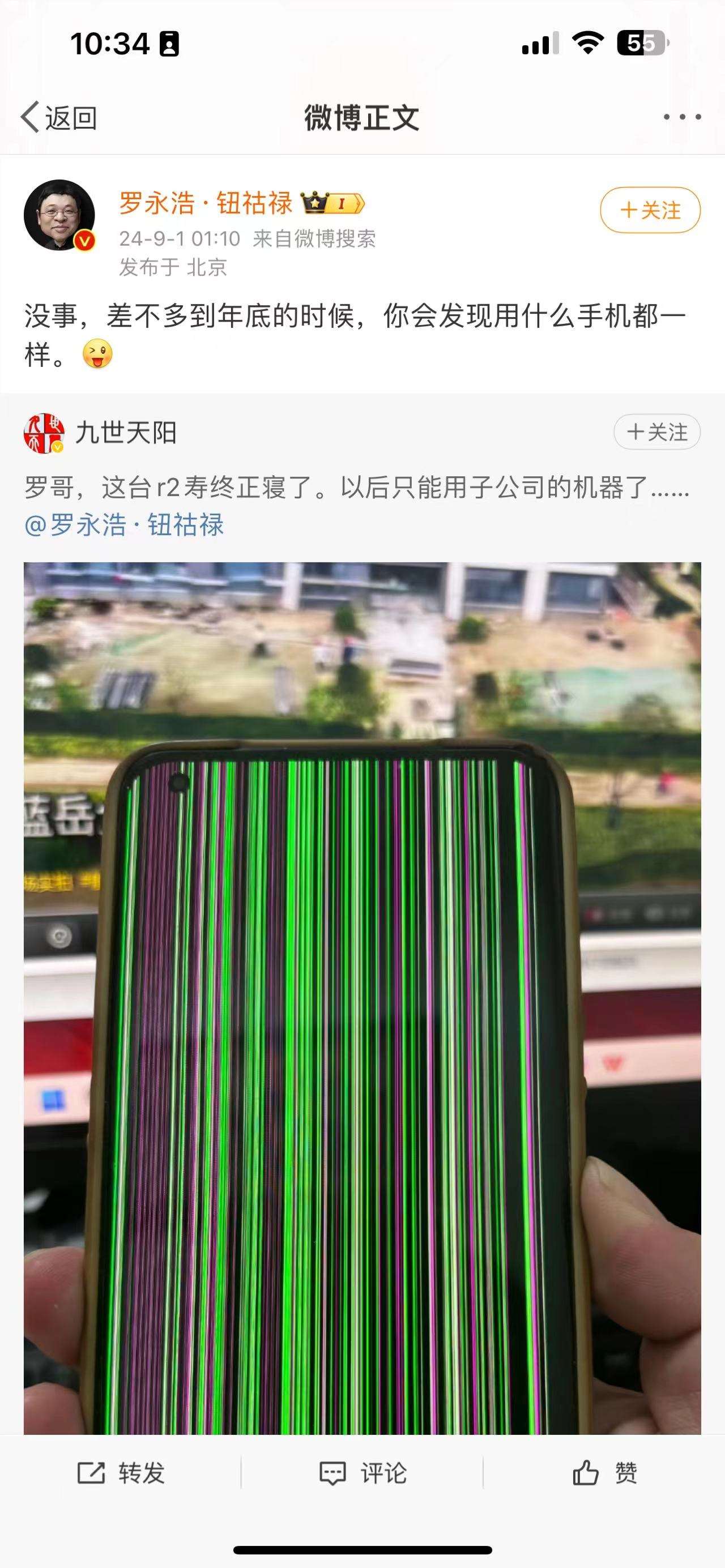

罗永浩微博暗示年末或有大动作,网友期待新品发布

站长之家(ChinaZ.com)9月1日消息:昨晚,一名博主在微博上@罗永浩·钮祜禄,称自己的坚果R2手机已停止工作。对此,罗永浩回应道:“没事,差不多到年底的时候,你会发现用什么手机都一样。”这一回应引发了广泛的猜测和讨论。站长网2024-09-02 09:51:11000032k上下文可商用!长颈鹿来袭,开源大模型长度再创新高

要点:长颈鹿是基于LLaMA模型打造的,上下文长度达到32k,是目前开源大模型中最长的。研发团队Abacus.AI通过测试不同的上下文外推方法,发现线性插值效果最好,并在此基础上提出了PowerScaling和TruncatedBasis两种新思路。尽管Abacus.AI宣称长颈鹿是首个32k开源模型,但Together.AI更早发布了类似规模的版本,两者可以说并列第一。站长网2023-08-26 16:04:510000抖音:重点打击“售卖账号”“售卖好评卡”“恶意控评”三类水军行为

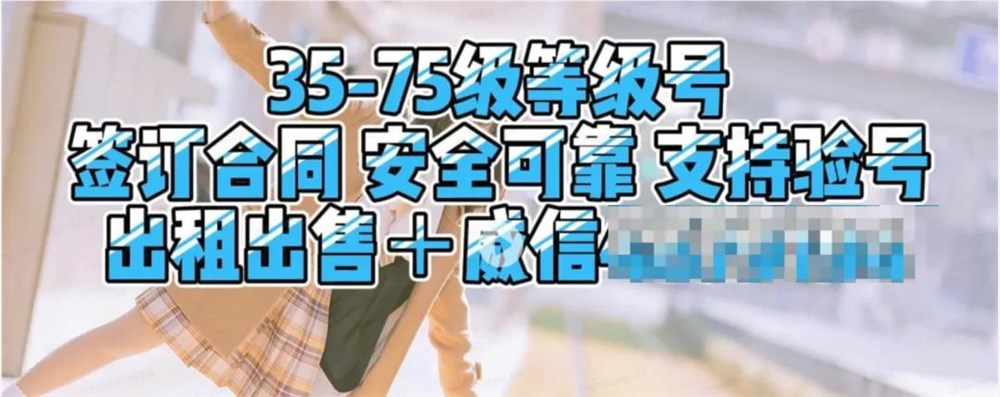

抖音最近对三类水军行为进行了重点打击:售卖账号、售卖好评卡和恶意控评。首先,抖音发现一些用户在平台上售卖高等级账号,宣称可以获得更多关注和热度,引导其他用户通过第三方渠道进行交易,但购买账号不能带来真正的流量,而且存在欺诈风险。其次,还有一类用户在平台上售卖电子好评返现卡,即商家发布好评后可获得返现红包,这是刷赞、刷好评的水军行为,同时也存在欺诈风险。站长网2024-04-24 17:17:390000天猫上线AI砍价功能 网友:AI的出击让我“脚趾扣地”

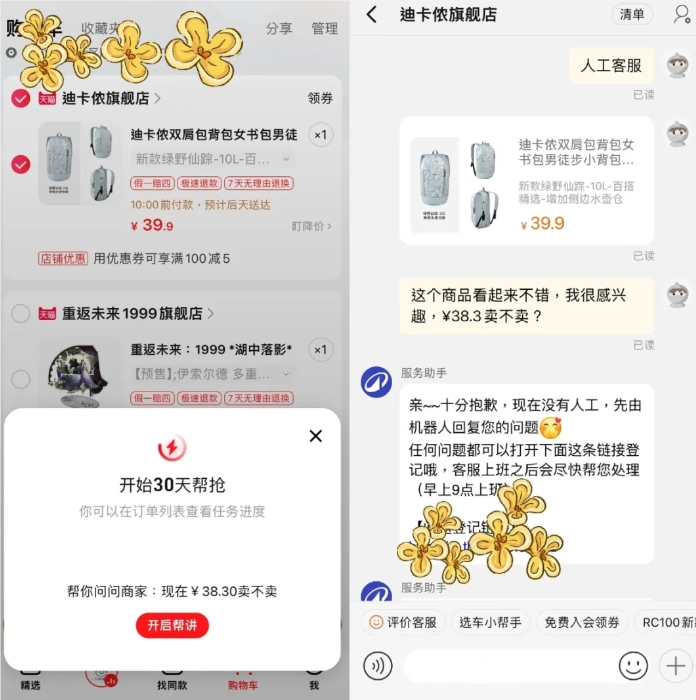

近日,小红书博主“脆皮钵钵柒”在平台上分享了自己在天猫App中的新奇体验。他在购物车页面偶然发现了一个“帮讲价”的按钮,出于好奇尝试点击后,出现了客服对话页面,AI主动出击,向商家提出“¥38.3卖不卖”的砍价要求,这一行为让博主感到十分尴尬,形容自己“脚趾扣地”。站长网2024-04-24 16:11:310000QQ浏览器推出“PDF阅读助手”AI工具 由腾讯混元大模型支持

近日,QQ浏览器推出了一款名为“PDF阅读助手”的智能工具,用户可以申请加入体验测试。该工具由腾讯混元大模型支持,可以在手机或电脑上随时使用。“PDF阅读助手”具有以下特点:首先,它支持智能摘要功能,用户不再需要逐页阅读长篇文档。通过一键操作,该助手可以迅速为您提炼出重要信息,大大节省了阅读时间。站长网2023-10-13 08:41:140000