Wayve推出GAIA-1 9B,通过生成合成视频训练自动驾驶

文章概要:

- Wayve是一家英国初创公司,于2023年6月发布GAIA-1,一款用于自动驾驶车辆训练数据的生成式人工智能模型。

- GAIA-1使用文本、图像、视频和行动数据创建各种交通情景的合成视频,填补了道路交通复杂性所产生的数据空白。

- 这一世界模型可以预测未来事件,帮助自动驾驶车辆提前规划行动,增加道路安全和效率。

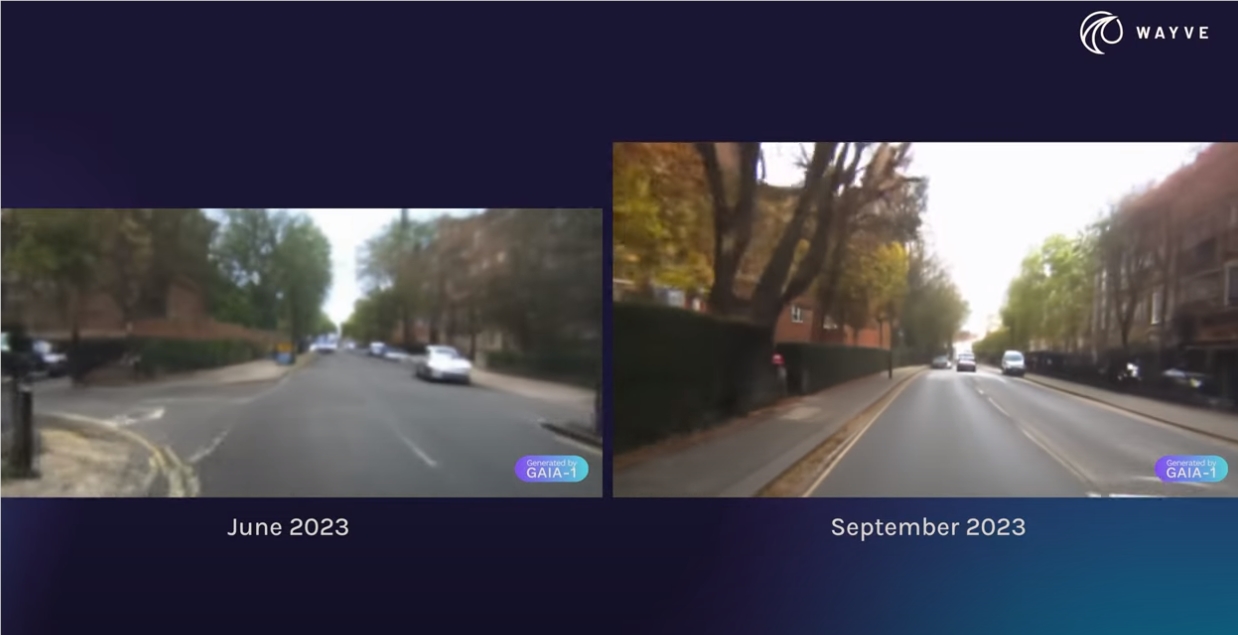

英国初创公司Wayve在2023年6月发布了GAIA-1(Generative Artificial Intelligence for Autonomy),这是一款为自动驾驶车辆培训数据而设计的生成式模型。GAIA-1的最新版本,GAIA-19B,已经取得了令人瞩目的进展。

GAIA-1的独特之处在于它的能力,它能够使用文本、图像、视频和行动数据来生成各种交通情景的合成视频。这一能力填补了自动驾驶车辆训练中的数据缺口。

试想一下,在雾中,有一个行人从卡车后面跳出来,同时一名摩托车手即将超越你,一名自行车手从前方靠近。这是一个真实的情景,但要捕捉到这个精确的场景,你需要开多少英里的车并进行拍摄呢?GAIA-1回答了这个问题,它可以生成各种交通情景的合成视频,用于自动驾驶车辆的培训。

与传统的生成式视频模型不同,Wayve表示,GAIA-1是一种生成式“世界模型”,它学会了理解和解读驾驶的最重要概念。它能够识别和分离不同的车辆及其特征、道路、建筑物或交通信号灯等概念。GAIA-1还学会了代表环境及其未来动态,为驾驶提供了结构化的环境理解,可用于做出明智的驾驶决策。

自GAIA-1首次发布以来,Wayve团队对其进行了优化,以高效生成高分辨率视频,并通过大规模培训提高了世界模型的质量。该模型现在拥有90亿个参数(相对于六月版本的10亿个参数),还能够精确控制视频中的车辆行为和场景特征。这使其成为培训和验证自动驾驶系统的强大工具。

GAIA-1的模型基于在2019年至2023年间在英国伦敦收集的4700小时专有驾驶数据。模型的架构包括每个输入模态(视频、文本和行动)的专用编码器、世界模型、自回归变换器和视频解码器,以及将预测的图像元素转换回像素空间的视频扩散模型。

值得注意的是,GAIA-1的世界建模任务与大型语言模型(LLMs)常用的方法非常相似,其中任务被简化为预测下一个标记。在GAIA-1中,这一方法应用于视频建模,而不是语言。这表明随着模型大小和培训数据集的增加,GAIA-1在视频生成方面的性能和效率将继续提高,类似于大型语言模型在其各自领域内观察到的缩放模式。开发人员表示,随着更多的数据和处理能力,仍然存在“显著的改进空间”。

此外,GAIA-1还可以预测过去的上下文视频图像的不同未来情景,包括行人、自行车手、摩托车手和对向交通的行为,从而使模型能够考虑与其他道路使用者的互动并对情况做出反应。GAIA-1还可以通过纯文本输入进行控制,例如,通过文本命令“天气是晴朗的”、“多雨的”、“有雾的”或“多雪的”来生成不同的驾驶情景。此外,它还可以使用文本命令,如“现在是白天,我们处于直射阳光下”、“天空是灰色的”、“现在是黄昏”和“现在是夜晚”,来创建不同的照明情景。

然而,Wayve也指出了GAIA-1的一些局限性。虽然自回归生成过程非常有效,但需要大量计算,因此生成长时间的视频会非常计算密集。此外,当前模型主要集中于预测单一摄像机输出,而自动驾驶需要来自所有周围视点的全面视图,这是关键问题之一。

未来的工作将扩展该模型的能力,以捕捉更广泛的视角,并优化其生成效率,使该技术更具适用性和效率。此外,Wayve还在开发Lingo-1,这是一种自动驾驶系统,将机器视觉与基于文本的逻辑相结合,以解释道路上的决策和情况。这种基于文本的逻辑可以增加车辆的安全感,使人工智能的决策不再像一个“黑盒子”。

GAIA-1项目网址:https://wayve.ai/thinking/scaling-gaia-1/

AI for Science 空间非常大 将全方位改变从科学研究到产业落地

2023中关村论坛系列活动——2023科学智能峰会(AIforScienceCongress)8月10日在北京开幕。峰会由中关村论坛办公室作为指导单位,由北京科学智能研究院主办,旨在搭建AIforScience领域科研突破、技术培育、人才交流的共建共创平台,共同推动AIforScience的基础设施建设,激发创新效能。站长网2023-08-11 14:19:110000IBM 发布开源模型 Granite Code,在编程任务中超过谷歌模型

划重点:🔍IBM发布了一套名为"GraniteCode"的专门用于编程的模型,这些模型在基准测试中超过了一些较大的开源竞争对手,并旨在帮助企业完成各种软件开发任务。🔍GraniteCode模型包括基础模型和指导模型,每种模型都有4个不同规模的变种,参数从30亿到340亿不等,通过对比评估表现出色。站长网2024-05-13 09:45:070000抖音打击低俗色情内容 处理违规签名导流行为

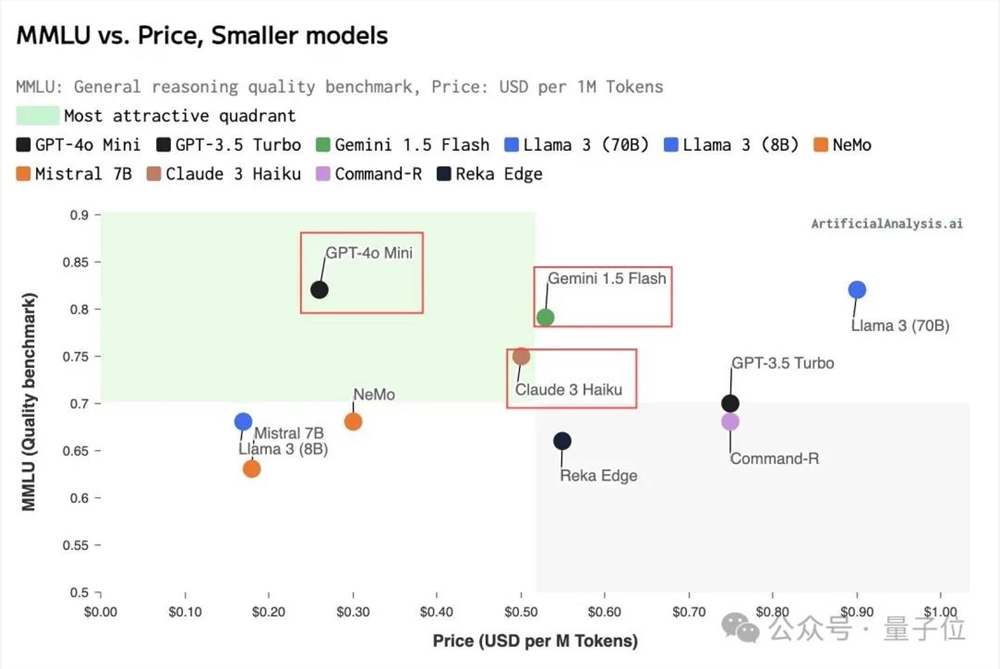

抖音发布《关于打击低俗色情内容的公告》称,为持续营造风清气正的网络环境、维护平台良好的社区秩序,抖音成立专项治理团队,对低俗色情内容加强打击。包括治理试图通过账号头像、签名、评论等方式实施违规导流的行为。近日,平台在日常巡查中发现,有极个别账号,以签名方式,发布类似“所有的图都在这儿”“好看的都在这里”“合集私我”等内容,试图脱离平台监管,将用户吸引至站外“**圈”等含有低俗内容的第三方平台。站长网2023-05-18 08:54:260000GPT-4o mini背后团队揭秘:9人团华人面孔过半,清华北大同济校友在列

“大模型尺寸之争正在加速……倒退!”OpenAI的GPT-4omini一登场,又登上了大模型话题榜榜首。并且这次话题焦点,是OpenAI不仅再树新标杆,还一出手就把性价比卷爆了——直接把此前大受开发者好评的Gemini1.5Flash和Claude3Haiku给碾压了。这不,大神Karpathy火速发了篇小作文,做出开头提到的这么一句判断,并进一步解释:站长网2024-07-20 00:50:410001AI芯片公司Tenstorrent获得1亿美元融资 现代、三星等参与

1.加拿大AI芯片初创公司Tenstorrent获得来自现代汽车和三星等投资者1亿美元资金。2.Tenstorrent由芯片行业资深人士JimKeller领导,专注于开发人工智能芯片。3.Tenstorrent计划挑战市场领导者Nvidia,同时开发用于智能电视等领域的AI芯片。站长网2023-08-03 15:32:520002