LongLoRA:提升LLM上下文能力的创新微调方法

要点:

1. LongLoRA是一种创新的微调方法,可以显著增强大语言模型的上下文处理能力,而无需消耗大量算力资源。

2. LongLoRA采用了两大步骤的高效微调方法,包括使用转变短注意力(S2-Attn)和有效扩大上下文的技巧,可以在不同任务上取得出色的结果。

3. LongLoRA展示了大型语言模型在处理更多信息时能力的提升,尤其擅长处理长文本和长对话中的特定主题,为处理复杂任务提供了新的可能性。

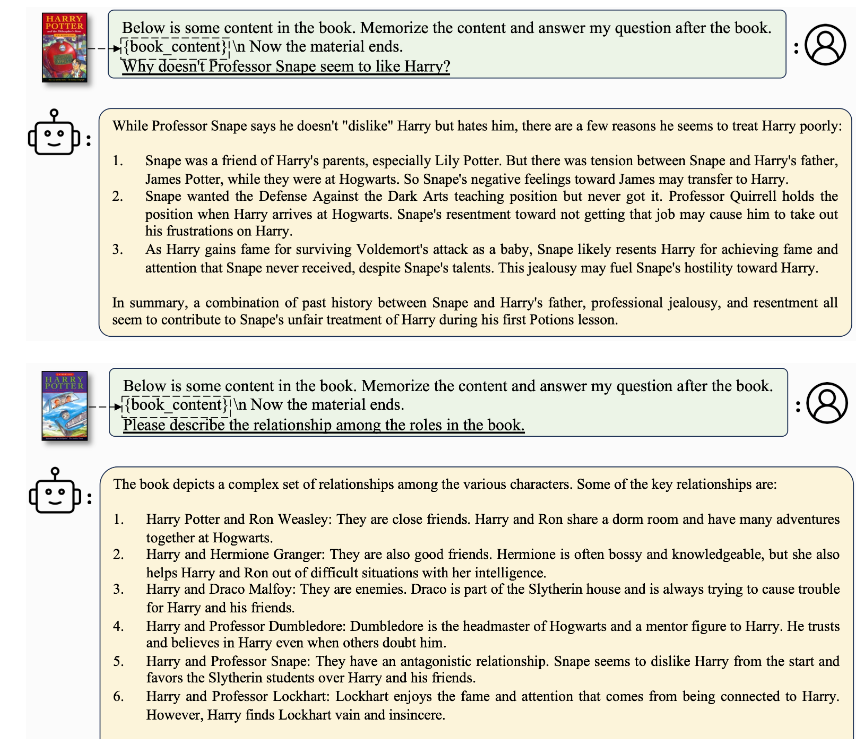

LongLoRA是一种全新的微调方法,旨在提高大语言模型(LLM)的上下文处理能力,而无需过多的算力资源。传统上,增加LLM的上下文处理能力需要大量的算力支持,但LongLoRA采用了创新的方法,使LLM能够处理更长的文本和更多的信息。这种方法的核心是采用了两大步骤的高效微调方法。首先,它使用了一种称为转变短注意力(S2-Attn)的新型注意力形式,该方法能够在训练过程中节省计算能力,同时保持了高效性。其次,LongLoRA重新挖掘了一种名为LoRA的方法,用于有效扩大训练信息的上下文。这个方法在与可训练的嵌入和规范化一起使用时非常有效。

开源地址:https://github.com/dvlab-research/LongLoRA

论文地址:https://arxiv.org/abs/2309.12307

LongLoRA的优势在于它能够在各种任务上取得出色的结果,并且可以与不同大小的LLM一起使用。它可以将用于训练的数据量从4k增加到100k,对于另一个模型,可以增加到32k,而所有这些都可以在一台强大的计算机上完成,与其他技术兼容性良好,不会改变原始模型设计架构。

研究还发现,随着上下文大小的增加,模型的性能更好,这证明了LongLoRA微调方法的有效性。使用更多信息进行训练可以带来更好的结果,例如,一个模型的困惑度性能从2.72降低到2.50,当上下文窗口从8192增加到32768时。此外,LongLoRA还在处理长对话中找到特定主题方面表现出色,与竞争对手相比,它更有效地适应开源数据。

LongLoRA提出了一种创新方法,使大型语言模型能够更轻松、更高效地处理大量信息,而无需消耗大量算力资源。它在处理长文本和复杂任务方面表现出色,为语言模型领域带来了新的可能性。

云从科技发布国内首款AI原生数据分析产品DataGPT

今日,云从科技发布了国内首款AI原生数据分析产品——DataGPT。该产品基于云从自主研发的从容多模态大模型,采用新颖的“对话即分析”交互模式,改变了企业对复杂数据的认知和应用方式,使数据解析变得简单自然。DataGPT具备以下六大亮点:1.领先的大模型驱动:运用从容大模型的领先技术,确保数据分析的高效与准确性,能够及时准确地回答任何复杂的统计需求。站长网2024-02-01 17:30:080000如果大气层厚度改变,天空还是蓝色的吗?

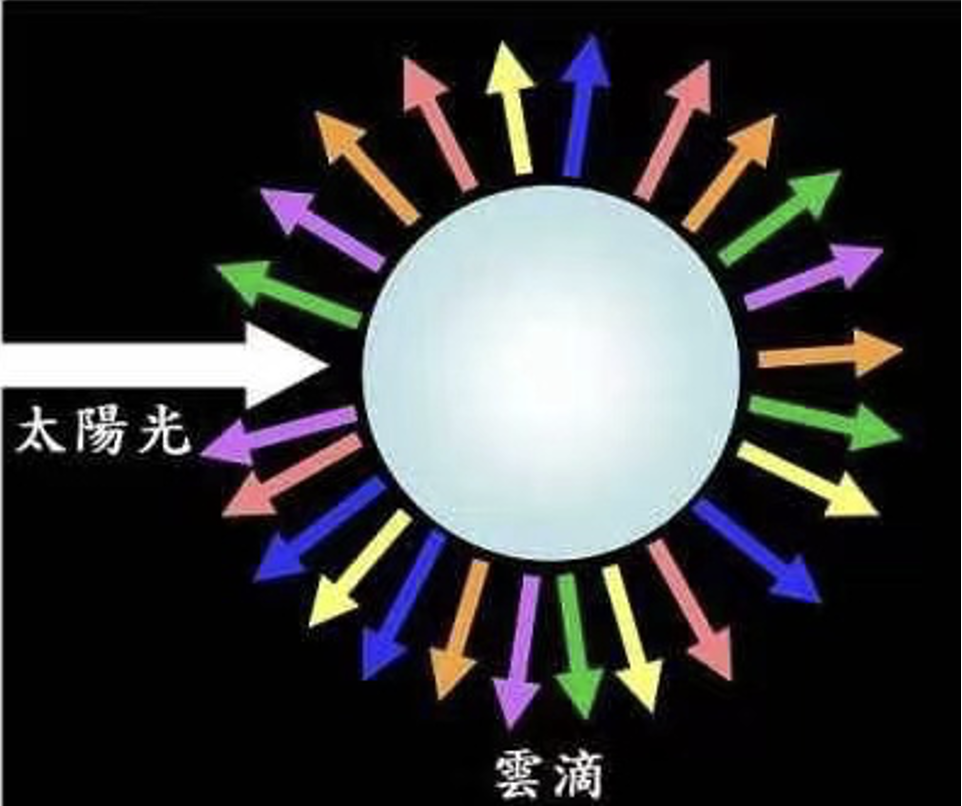

如果大气层厚度改变,天空还是蓝色的吗?在散射这一光学作用下,光线与大气分子以及无数悬浮颗粒相遇,改变了能量和方向,向四周传播开来。于是,晴空弥漫成蔚蓝,晚霞晕染出橙红,海浪翻滚起洁白的浪花,微观世界的每一丝波动都有可能引起大自然色彩的万千变幻。那么,散射分为哪几种情况,我们在不同大气层高度看天空,天空的颜色是一样的吗?又如果我们的大气层厚度发生改变,天空还会是蓝色的吗?快来探究一下吧。站长网2023-05-24 07:32:230000高盛将百度加入买入名单 股价受益于转向结构性生成型人工智能

站长之家(ChinaZ.com)7月18日消息:Fintel报道称,2023年7月17日,高盛重申了对百度公司-ADR(纳斯达克股票代码:BIDU)的评级,并给予买入建议。站长网2023-07-18 17:22:530001用AI干预老年痴呆治疗!微软联合上海“600号”

快科技9月22日消息,据媒体报道,近日,微软亚洲研究院与上海市精神卫生中心(俗称600号”)展开合作,共同探索使用人工智能技术干预阿尔茨海默症的治疗方法。面对全球人口老龄化趋势,阿尔茨海默病等认知症成为重大健康挑战,目前尚无药物能完全治愈阿尔茨海默病,但及早诊断和干预可延缓病程。此次合作基于微软AzureOpenAI服务中的多模态大模型,开发了名为忆我”(ReMe)的个性化认知训练框架。0000淘宝Vision Pro版发布2.0版本更新 支持小米SU7“虚拟试车”

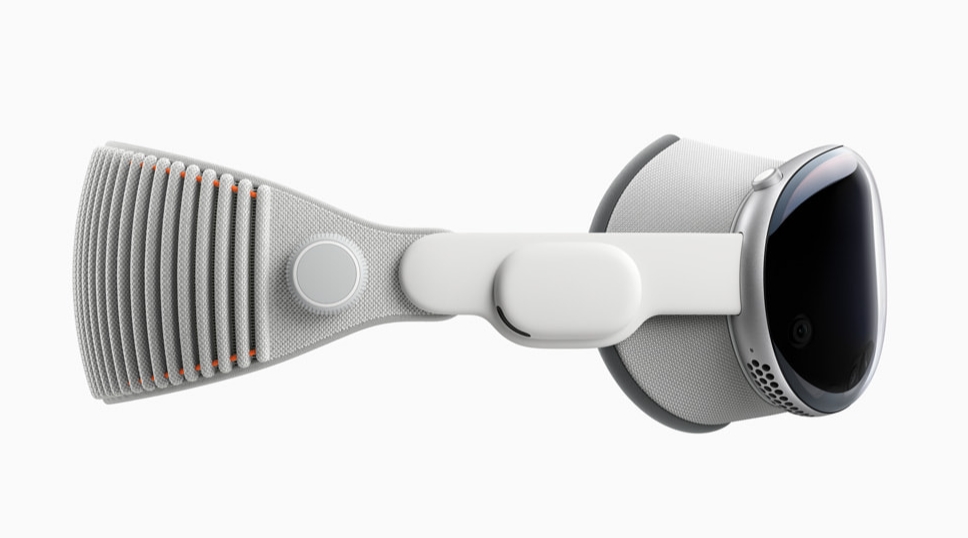

站长之家(ChinaZ.com)6月24日消息:随着6月28日苹果VisionPro国行版的正式开售临近,国内电商巨头淘宝也迎来了其VisionPro版应用的重大更新——2.0版本。此次更新不仅开放了登录、搜索、消息、下单等完整的购物功能,更带来了数十亿计的海量商品供用户挑选购买,让空间计算设备上的购物体验迈上了一个全新的台阶。站长网2024-06-25 05:03:530000