微软密谋小尺寸AI模型,撇开OpenAI搞起了“B计划”

AI大模型无疑是2023年的关键词,更是各大科技厂商竞逐的热门赛道。然而象征着未来的AI大模型实在太费钱,以至于财大气粗如微软都开始考虑“Plan B”了。近日有爆料信息显示,在微软内部由Peter Lee领导的1500人研究团队中,有一部分人转向研发全新的LLM,它的体积更小、运营成本也低得多。

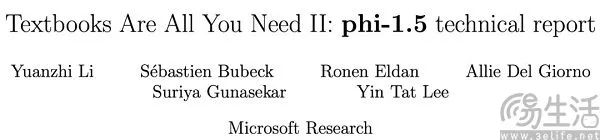

关于微软的小尺寸AI模型,实际上在3个月前就已经初见端倪。此前在今年6月,微软方面发布了一篇题为《Textbooks Are All You Need》的论文,用规模仅为70亿token的“教科书级别”数据训练了一个13亿参数的模型phi-1,证明高质量的小规模数据一样能够让模型具备良好的性能。并且在phi-1的基础上,此前微软研究院还发布了名为phi-1.5的全新预训练语言模型,可适用于QA问答、聊天格式和代码等场景。

根据微软方面的说法,在测试常识、语言理解和逻辑推理的基准下,phi-1.5的表现超出了相当一部分大模型。phi-1.5在带LM-Eval Harness的GPT4AL跑分套件中,可以媲美Meta旗下拥有70亿参数的开源大模型llama-2,在AGIEval得分上甚至超过了llama-2。

为什么微软要突然做小尺寸的AI模型呢?首要因素被外界认为可能是与OpenAI之间的纠葛。作为OpenAI的“金主”,微软能够在旗下产品中永久使用OpenAI现有知识产权的独家权利,但这也并不代表他们就能控制OpenAI。所以对于微软这样的巨头而言,无论是出于自身战略安全的考量,还是为了在后续与OpenAI的合作关系中占据更有利的地位,开发高质量的LLM都是一个必选项。

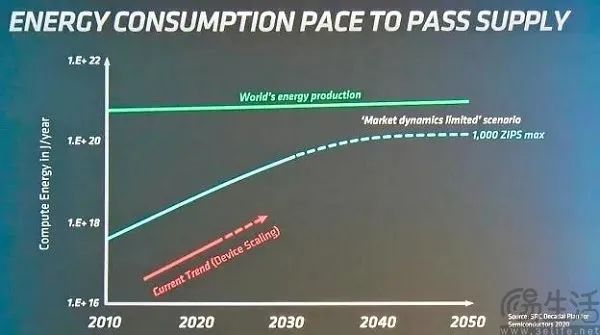

当然,目前AI大模型实在太耗能也是关键因素之一。在今年年初的设计自动化大会上,AMD首席技术官Mark Papermaster就展示了一张幻灯片,显示机器学习系统的能耗与全球发电情况的对比。根据国际能源署估计,训练大模型的数据中心变得越来越耗电,其用电量占全球电力消耗的1.5%至2%,大致相当于整个英国的用电量,预计2030年这个比例将上升到4%。

根据Digital Information World发布的相关报告显示,数据中心为训练AI模型产生的能耗将为常规云服务的三倍,到2028年数据中心功耗将接近4250兆瓦、比2023年增加212倍。而OpenAI训练GPT-3的耗电量为1.287吉瓦时,大约相当于120个美国家庭1年的用电量。但这还仅仅只是训练AI模型的前期电耗,仅占模型实际使用时所消耗电力的40%。

事实上,训练AI大模型不仅耗能、还费水。在谷歌方面发布的2023年环境报告中就显示,他们2022年消耗了56亿加仑(约212亿升)的水,相当于37个高尔夫球场,其中52亿加仑用于该公司的数据中心、比2021年增加了20%。

但AI大模型的高能耗是非常正常的,用ARM高级技术总监Ian Bratt的话来说,就是“AI计算需求是没法满足的。网络规模越大、结果就越好,可以解决的问题也越多,电力使用与网络规模成正比。”

有AI从业者表示,在此次疫情前,训练一个Transformer模型所需的能耗在27千瓦时的范围内,但现在Transformer模型的参数从5000万增加到了2亿,能耗也已经超过了50万千瓦时。也就是说,参数的数量增加了四倍,可能耗却增加了超过18000倍。从某种意义上来说,AI大模型带来的种种创新功能,其实都是以处理性能和功耗方面的高昂成本为代价。

更多的电力驱动更多的GPU进行AI训练,又要大量消耗水资源来冷却GPU,这就是问题所在。以至于微软被曝光正在制定一个路线图,希望用小型核反应堆产生的电能来运营数据中心。更何况即便不提ESG(“环境、社会及管治”),单纯从成本层面出发,研究小尺寸模型也是有价值的。

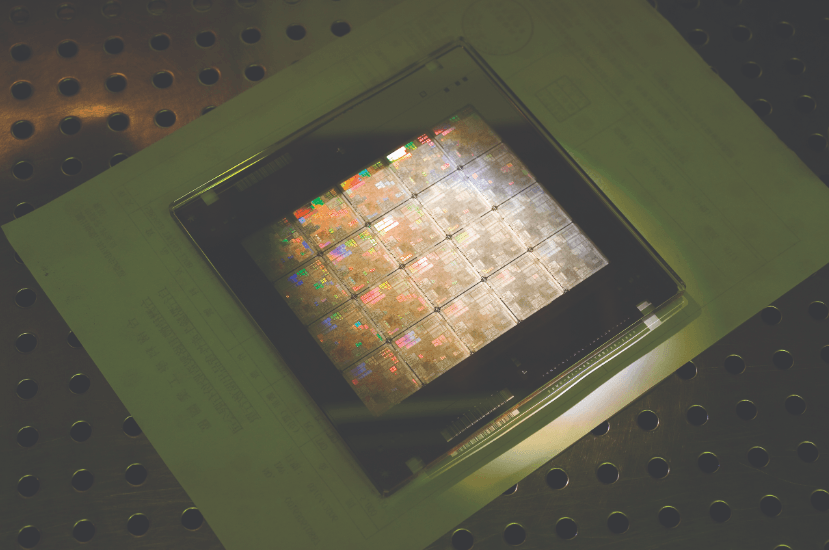

众所周知,搭建了CUDA生态的英伟达是这一轮AI热潮中的最大受益者,更是已经占据了AI芯片市场的70%,如今H100、A100等计算卡更可谓是一卡难求。可现在的情况,是向英伟达购买算力已经成为了一个推高AI厂商成本的重要因素。所以小尺寸模型也就意味着需要的算力资源更少,只需购买更少的GPU就能解决问题。

虽然功能更强的大模型确实很好,但现在大模型的商业化还处于蒙昧状态,唯一赚得盆满钵满的是“买铲子”的英伟达。所以在这样的情况下,微软自然也就有意来改变现状了。

马斯克推出名为 Grok 的具有「叛逆倾向」的人工智能聊天机器人

特斯拉首席执行官马斯克最近推出了一款名为Grok的人工智能聊天机器人,该机器人受到《银河系漫游指南》的启发,具有「叛逆倾向」(rebelliousstreak)。尽管在上周警告说AI是「人类面临的最大威胁之一」,但马斯克表示,这款与ChatGPT竞争的聊天机器人将在测试后向他的X平台的高级订阅用户提供。站长网2023-11-06 09:08:130000英伟达 CEO 黄仁勋:芯片制造是 AI 的「理想应用」 下一波浪潮是「具身人工智能」

英伟达创始人兼首席执行官黄仁勋周二在比利时安特卫普举行的ITFWorld2023半导体会议上表示,芯片制造是英伟达加速和人工智能计算的「理想应用」。他详细阐述了计算技术的最新进展如何加速「世界上最重要的产业」,并通过视频向来自半导体、科技和通信行业的领导人发表讲话。站长网2023-05-18 09:56:020000市场监管总局修订出台禁止滥用知识产权排除、限制竞争行为规定

据国家市场监督管理总局消息,为鼓励创新,维护知识产权领域公平竞争的市场秩序,助力全国统一大市场建设和知识产权强国建设,结合近年来反垄断监管执法的新形势、新情况、新问题,市场监管总局修订出台了《禁止滥用知识产权排除、限制竞争行为规定》,将于2023年8月1日起正式施行。站长网2023-06-30 01:34:590001考勤打卡提醒异常!钉钉紧急修复 官方道歉:耽误大家准点下班了

快科技8月1日消息,今日晚间,钉钉官博发文,称今天下午17点30分,钉钉考勤打卡的提醒出现异常(实际打卡已成功,仅返回信息有延迟),经紧急处理,该异常已经于17点45分修复完毕。钉钉表示:耽搁大家准点下班万分抱歉!(下次就算崩也尽量在上班的时候崩)”。有网友调侃道,我以为我们公司崩了,原来是你崩了”点了多次,还以为是自己网络有问题,原来是你”。站长网2023-08-01 21:35:010000微信新版本,几大实用功能更新

近日,微信发布了8.0.48测试版本。这次更新涉及到了视频号、朋友圈、静音、表情包等功能的变化,更新了很多比较实用的功能,快来和我们一起看看这些新变化。01视频号能投屏了新版本微信中,在视频号中出现了新功能:可直接进行投屏。具体操作为:视频号某一作品下,点击分享按钮,在分享的选项中选择「投屏」功能。点击「投屏」后,即可将视频号内容投屏到其他设备上。站长网2024-03-12 15:37:120000