OpenLM:一个专为中等规模语言模型设计的模型训练库

要点:

1. OpenLM是一个简单且精简的PyTorch代码库,用于训练中等规模的语言模型,旨在最大化GPU利用率和训练速度,易于用于新的语言模型研究和应用。

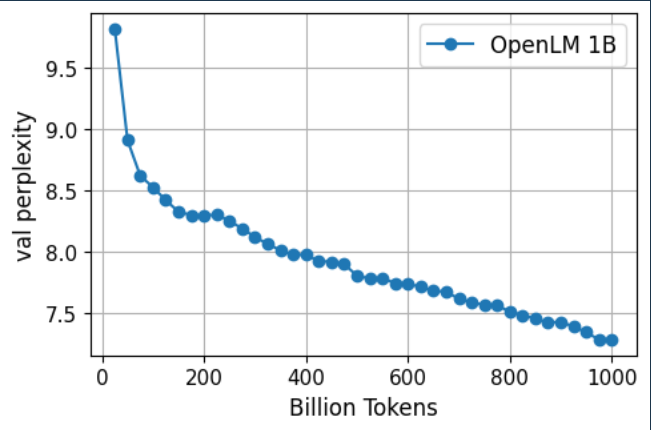

2. OpenLM通过训练两个语言模型,OpenLM-1B和OpenLM-7B,分别在1.6T和1.25T文本标记上进行验证,并在标准的零样本文本分类和多项选择任务上表现出色。

3. 未来工作包括支持多模态模型、专家混合和数据集组合,以及扩大OpenLM以支持训练更大的模型。

OpenLM是一个旨在训练中等规模语言模型的PyTorch代码库,它强调了最大化GPU利用率和训练速度的设计。该库已经通过训练OpenLM-1B和OpenLM-7B两个语言模型,分别在1.6T和1.25T的文本标记上进行验证,取得了令人瞩目的成果。OpenLM-1B在零样本文本分类和多项选择任务中表现出色,超越了一些类似规模的竞争模型。OpenLM-7B则在性能上接近了其他大型模型,如LLAMA-7B和MPT-7B。

文章详细介绍了OpenLM的模型架构、训练数据来源以及训练过程。值得注意的是,OpenLM采用了GPT-NeoX令人满意的分词工具,但采用了LayerNorm而非RMSNorm,因为后者尚未添加融合的RMSNorm操作。此外,1B模型采用了AdamW优化器,而7B模型则采用了不同的学习率和全局批量大小,以实现更好的性能。

文章还提供了有关模型验证和评估的信息,包括验证损失和零样本评估结果。OpenLM-7B在不断的训练中持续提高了零样本性能,在1.25T标记上,在11个任务中有7个任务的表现优于竞争模型。这表明OpenLM具有很大的潜力,并且可以在不断扩大规模的情况下提供出色的性能。

最后,文章提出了未来工作方向,包括支持多模态模型、专家混合和数据集组合,以及扩大OpenLM以支持训练更大的语言模型。OpenLM的团队成员和致谢也在文章中列出,表明了该项目的合作性质和开源精神。

图库巨头Getty Images拥抱AI技术 推出生成式AI服务

划重点:-GettyImages采取双管齐下的策略,一方面起诉涉及侵权的AI图像生成公司,另一方面推出新的AI图像生成服务。-新的GenerativeAI服务由GettyImages与Nvidia合作开发,旨在为商业客户提供商业可行的AI图像生成,避免知识产权风险。站长网2023-10-30 11:25:480000官方回应“理想L9误将广告识别成真车致追尾”:后续会改进

快科技5月11日消息,近日网络上热议一起由理想L9误认广告牌为真车导致追尾”的事故。据报道,在湖北襄阳,一位驾驶理想L9的车主表示,在使用车辆的辅助驾驶系统时,车辆错误地将高速公路边的广告牌上的小货车图片识别为真实车辆,并采取了紧急制动措施,结果导致了追尾事故。对于这起事件,理想汽车的相关责任人回应,确认是车载系统错误地将广告图片视作实体车辆所致,并指出公司会针对软件系统进行改进。0000炼丹家AI:一个集成“AI对话“和“AI绘画”的垂直细分功能网站

要点:炼丹家集成了AI对话和AI绘画等功能。AI对话可用于文本生成、问答、翻译、对话等场景。AI绘画可用于生成图像、二维码等创意作品。炼丹家AI是一个集成AI对话和AI绘画功能的人工智能平台。炼丹家通过AI技术,可以高效生成各类文本创作,也可以绘制出惊艳的图片作品。在AI对话方面,平台支持文本生成、问答、机器翻译、对话系统、客服机器人等功能,可以自动产生自然语言内容,与用户进行流畅交互。站长网2023-08-28 14:13:070001vivo X100入网 首发天玑9300或搭载卫星通信功能

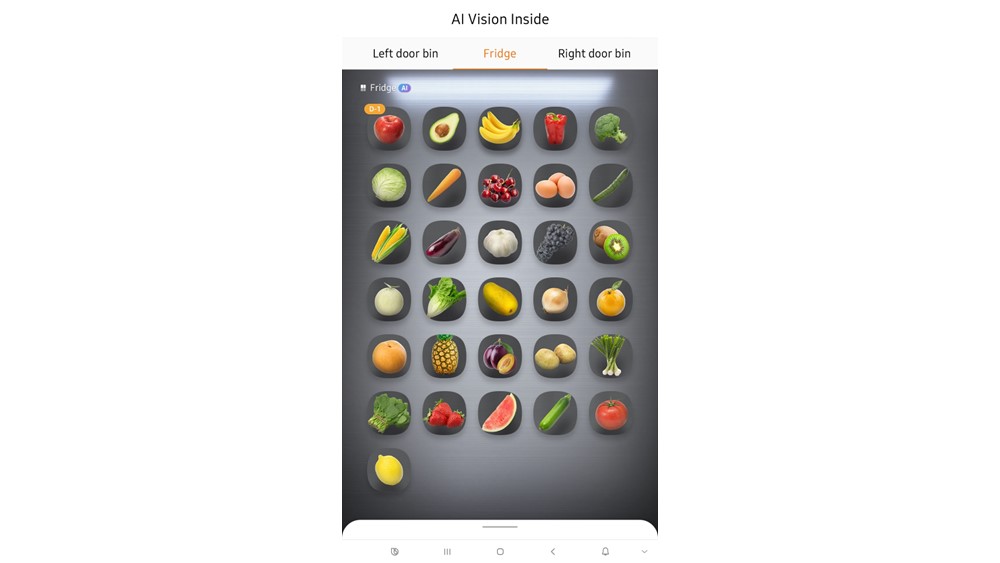

根据3C认证信息的最新显示,vivoX100系列已经通过认证并具备120W有线快充功能。这款新机系列将首发天玑9300处理器。此外,vivoX100系列还将标配国产1.5k曲面屏,预计采用最新的京东方Q9基材,局部峰值亮度将突破1600nit。站长网2023-10-19 15:13:400000三星新款人工智能冰箱配备 AI Family Hub+:可根据您的饮食需求设计食谱

三星公司宣布,将在新的一年推出一款具有引人注目的人工智能功能的智能冰箱。该公司计划在明年的消费电子展(CES)上展示这款名为2024Bespoke4-DoorFlexRefrigerator的产品,它配备了AIFamilyHub。图片来自Samsung站长网2023-12-28 10:19:510000