Midjourney+Gen2,7步完成「芭本海默」,引Karpathy惊呼|附实测经验

【新智元导读】7步完成「芭本海默」,电影工业2.0真的要来了吗?

在前两天芭比海默全网爆火之后,不断有网友“复现”用MidJourney Gen-2制作电影的神技!

而一位网友更新了一个自己的教程,制作芭本海默只需7步,被Karpathy盛赞为“电影制作工业2.0”。

一部20秒钟,有完整剧情,包含6个分镜头的动画短片,7步完成,曹植看了都要直呼内行!

7步完成芭比海默,效果惊人

下面就给大家具体演示一下:

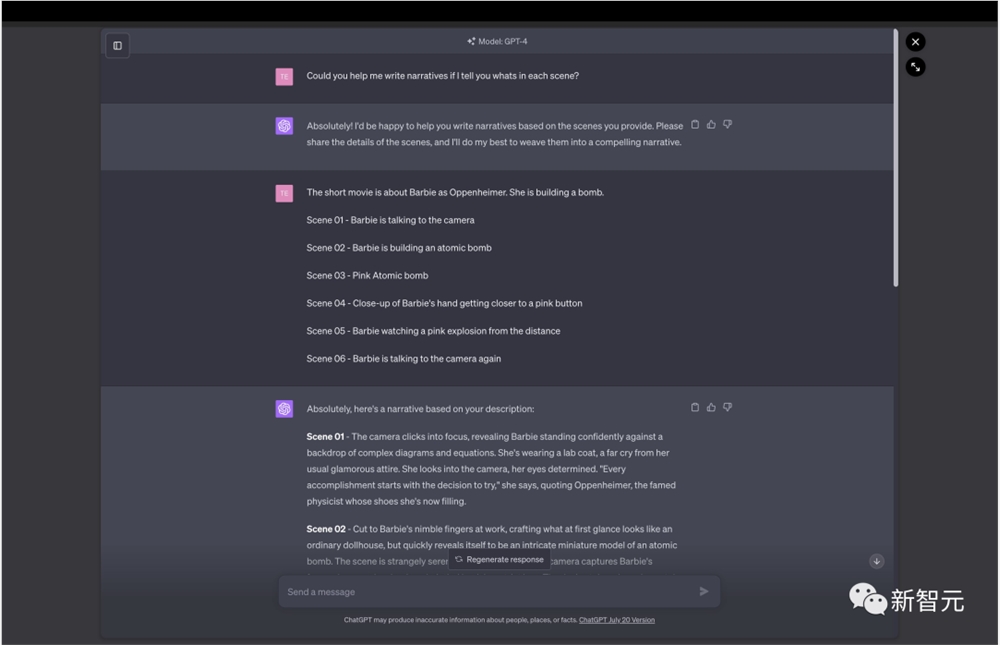

1.ChatGPT帮你写分镜头剧本,顺便再帮你把字幕也写好

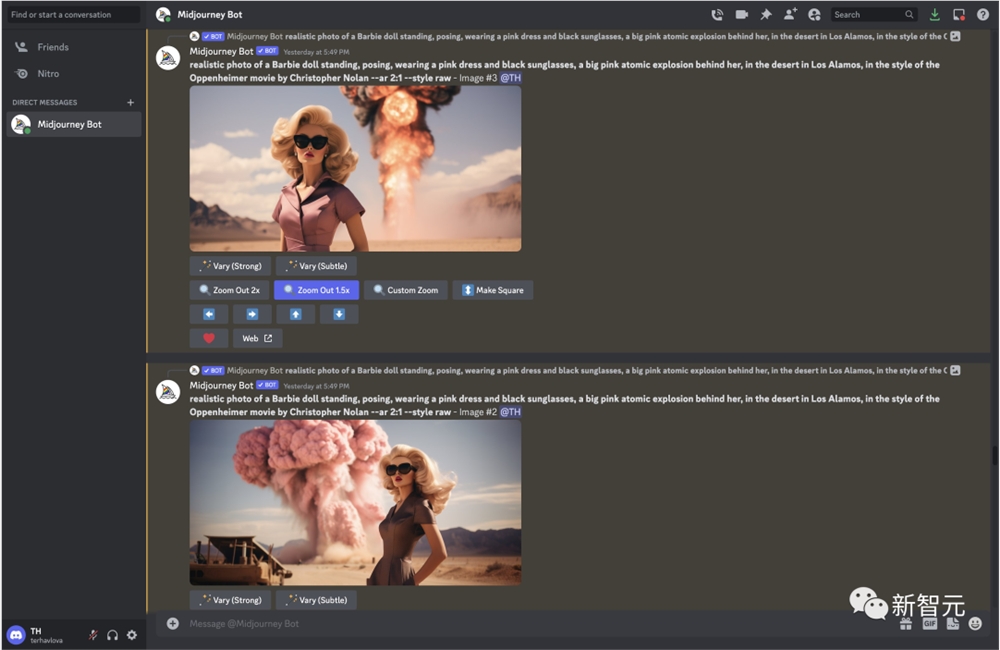

2.根据分镜头脚本,用Midjourney生成每个镜头的开始的一张图片。

这里可能是7步成片中唯一一步稍微有点门槛的操作,每张图片的提示词要自己创作。

但是点击图片放大之后可以看到提示词也不是很长,有一点英语基础的朋友稍微试一下就能做到。

这是短片中另外几个场景的起始图片,也全都是用Midjourney生成。

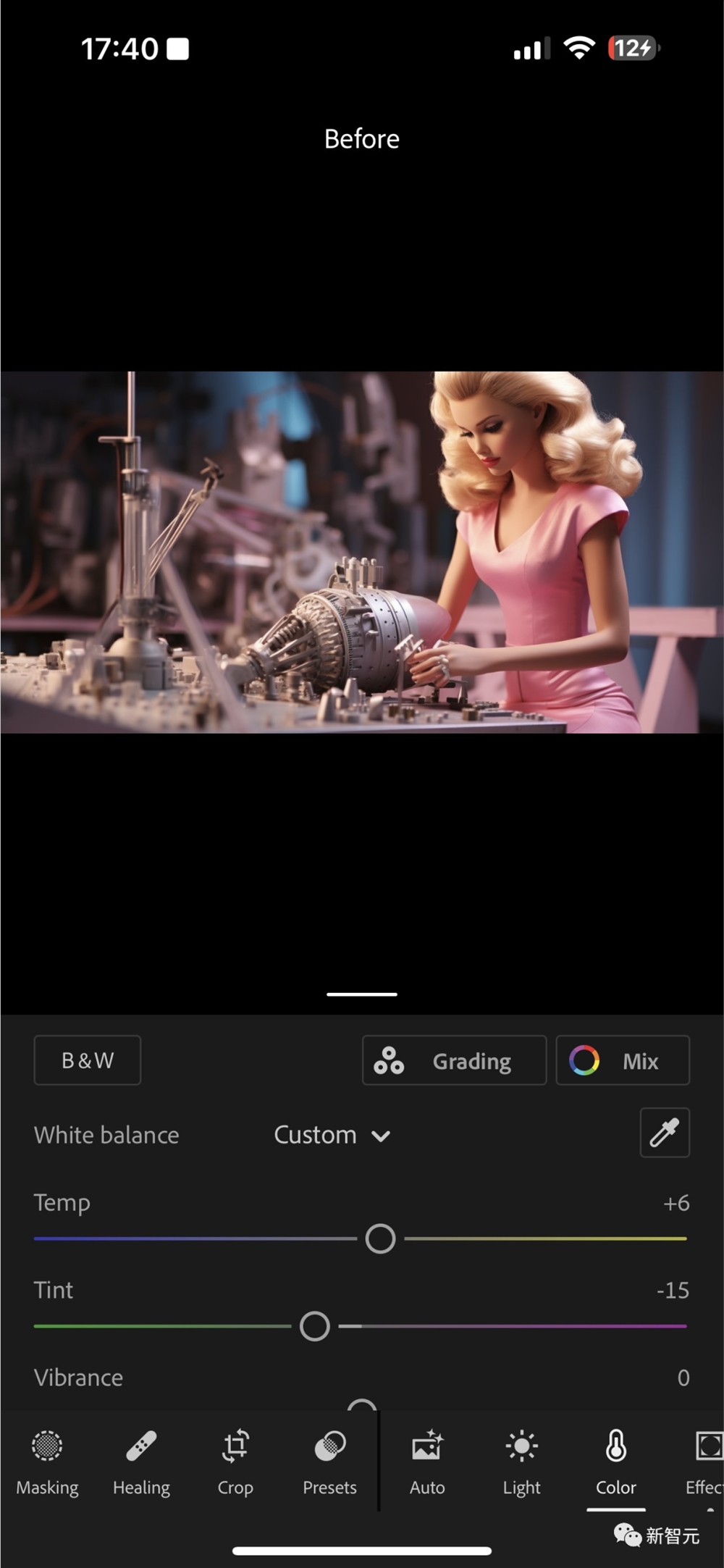

3. 为了保证短片中的场景色调一致,需要用修图软件调整一下每张图片的色调。

比如短片里的色调是比较复古的风格,Midjourney生成的原图可能不符合。

用任意一款修图软件调整过后,就能让所有场景的风格比较一致了。

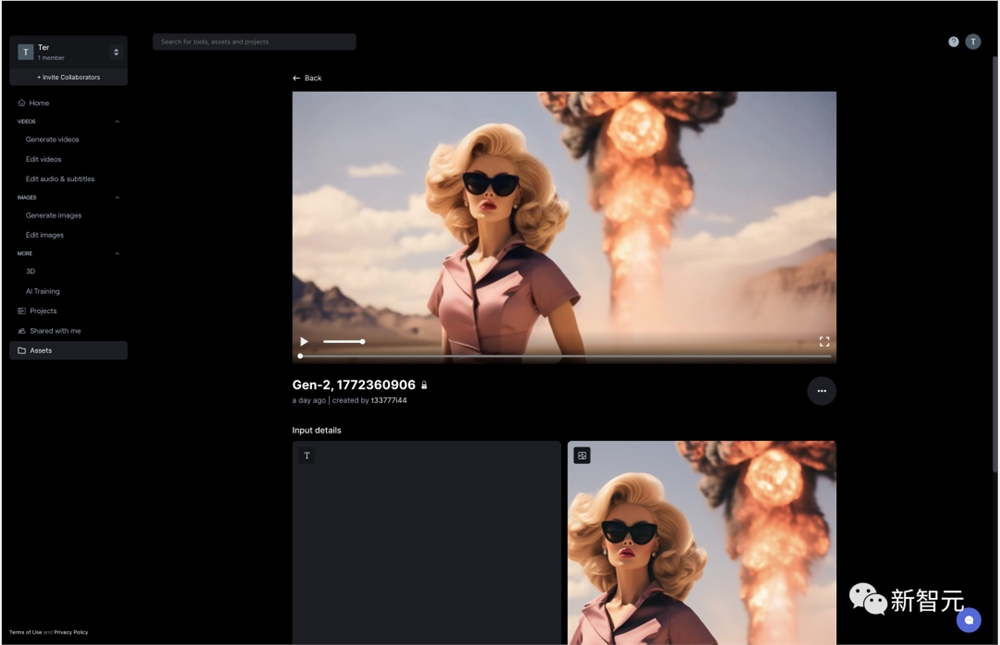

4. 使用Gen-2让每一张照片动起来,把6张照片变为6个分镜头。

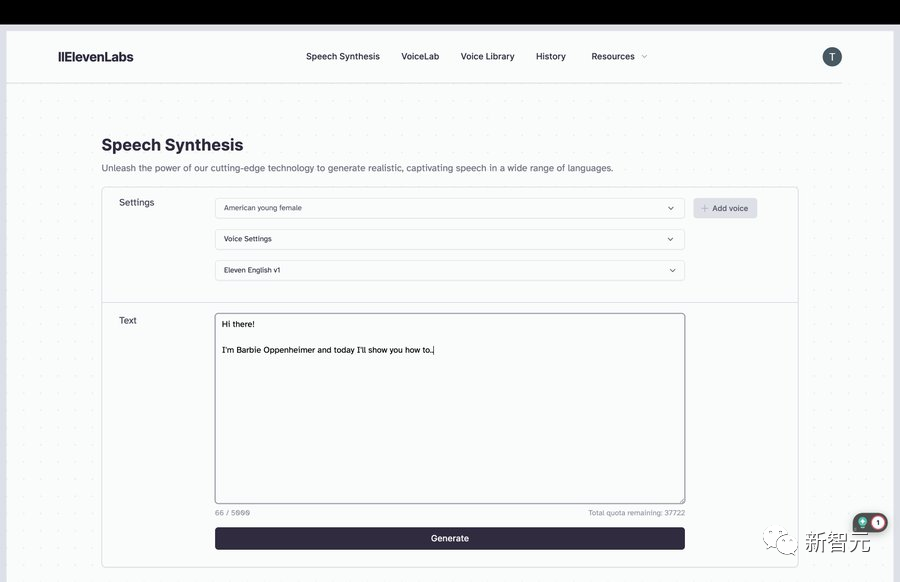

5.然后用ElevenLabs生成字幕的语音。

6. 然后用FinalCut Pro把动画,声音,和特效结合起来,短片就基本完成了。

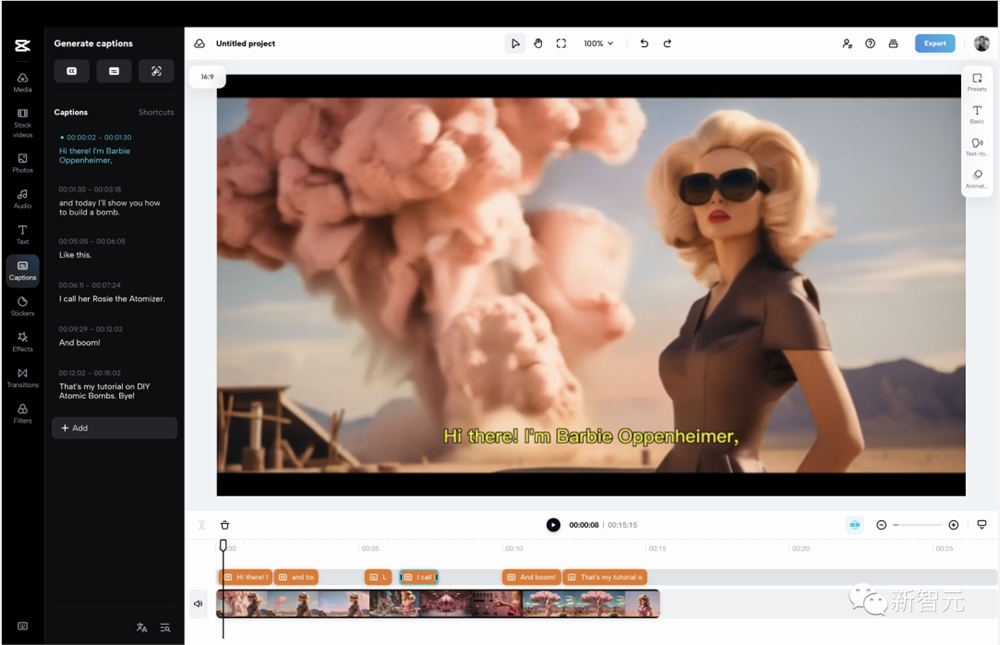

7. 再用Capcut添加好字幕,大功告成!

实测之后发现的经验

虽然看着简单,但是亲手实测了一波后发现,没有一个清晰的规划,要想做出自己效果满意的电影,还是很不容易的。

最大的障碍在于,因为Gen-2的动画只能以某一张图随机生成,所以在涉及人脸画面的时候,畸变会比较多。

本来想做一个马老板手搓星舰的视频,但是发现人物面部的畸变太严重了,以至于每段视频只有第一帧图片是马老板本人,一秒钟之后就不知道会变成谁了。

所以如果想要用Gen-2做一个明星相关的视频,现在为止还几乎不可能。

而且这些面部畸变和人物动作时完全随机的,完全不受用户控制。

有一位网友做了一段视频,把每4秒的最后一帧截图下来让Gen-2继续生成新动画。

大概40秒之后,画面中的人物,从一开始的美漫风格的动画角色,最后几乎畸变成了雕塑。

即便图片中有一些比较明显的动态提示的效果,但是Gen-2还不能理解,所以生成的效果也不一定符合你的预期。

人物的动作也没有办法太好的控制,可能为了要生成一段自己满意的动画需要用同一张图尝试好长时间。

所以就目前Gen-2能实现的效果来看,还不太可能随意适应比较复杂的剧本。

所以就要求写剧本时要尽量避免近景人脸特写等场景。

但是如果未来Gen-2能够将prompt和图片完全结合起来,让图片能够跟着prompt的描述动起来,效果就会有一个巨大的飞跃。

其他的Midjourney Gen-2的效果

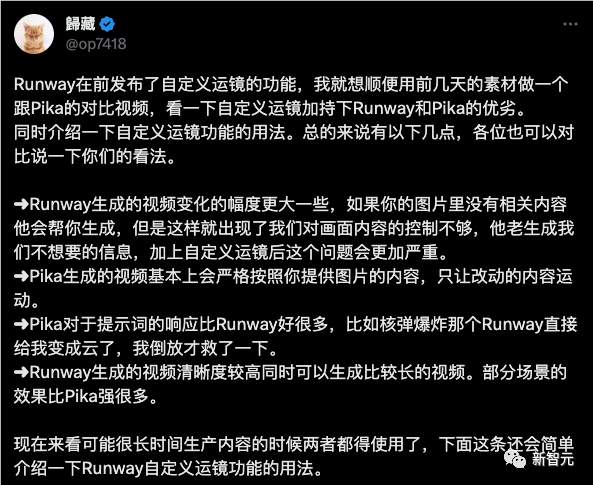

大神歸藏,用Gen-2做了几个《奥本海默》中的场景,足以以假乱真。

同时,他还比较了相似的场景和Pika Lab生成的区别。

下图是Pika Lab的效果。

除了开头这段「芭比海默」之外,很多网友也用Gen-2和Midjouney这对黄金搭档做起了动画开发的副业。

让我们来欣赏几组效果不错的动画效果演示。

可以看出,在演示之中人脸的效果变形不是很大,这与实测的差异很大,很有可能是因为作者试了很多次之后找到的脸部畸变不大的效果。

有网友生成了一部名人漫威角色的预告片,效果非常逼真,配上一点动画特效和光影,感觉真的像是漫威官方的作品。

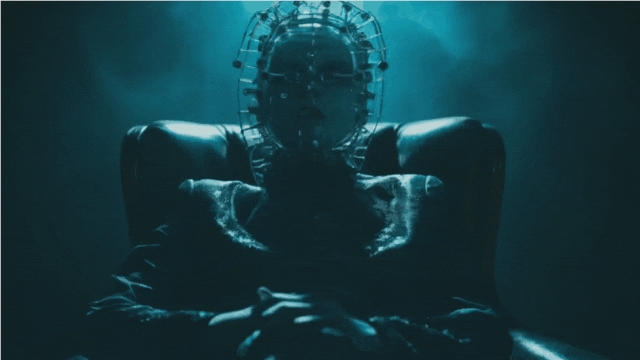

这是网友生成的一段恐怖电影的预告片,反而很好的利用了Gen-2人物画面畸变,增加了恐怖片的氛围感。

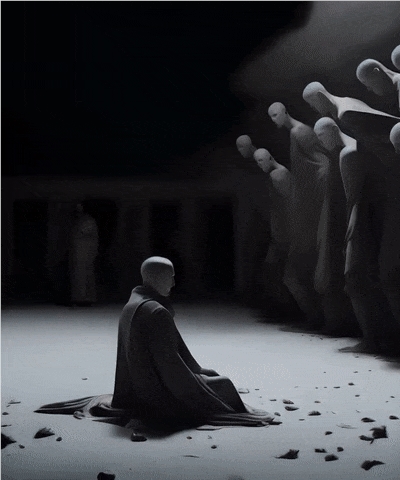

这一段也是网友用MJ Gen-2做的艺术感很强的视频,加上后期跟新的导演运镜特效。

这是一幅用油画的静图生成的动画,虽然有一点畸变,但是效果确实不错。

参考资料:

https://twitter.com/karpathy/status/1684608881920802816

https://twitter.com/kalsonkalu/status/1684534663472087042

会玩!一国外AI公司称要在海上训练强大的AI以规避美国法规

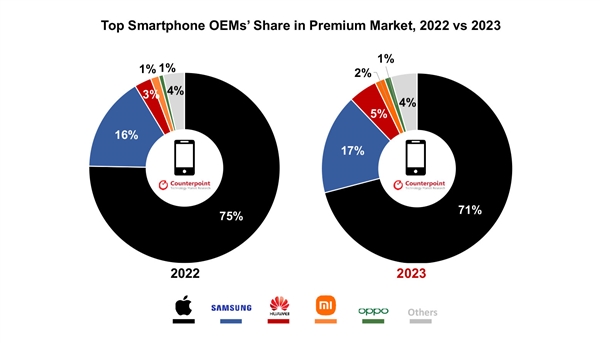

划重点:1.自称是AI公司DelComplex表示将在国际水域上建立具有安全保障力量的“蓝海前沿计算集群”(BSFCC),以规避政府的AI培训报告要求。2.DelComplex可能并非真正的AI公司,其宣称的驳船也是虚构的。3.该公司声称其行为是为了提供“国家即服务”,并批评政府对AI技术的监管滞后于时代发展。站长网2023-11-02 11:57:280000苹果份额超7成!2023全球高端手机销量创历史新高

快科技1月2日消息,今天,市场研究机构CounterpointResearch发布了2023年高端手机(批发价超过600美元、约4281元人民币)销量报告,苹果占据了超过70%的市场份额。报告显示,与今年全球智能手机市场整体的预计下降相比,2023年全球高端智能手机市场销售额可能会同比增长6%,创下新的历史纪录。站长网2024-01-02 21:58:420001英伟达人工智能概念驱动股价飙升 市盈率是特斯拉的三倍

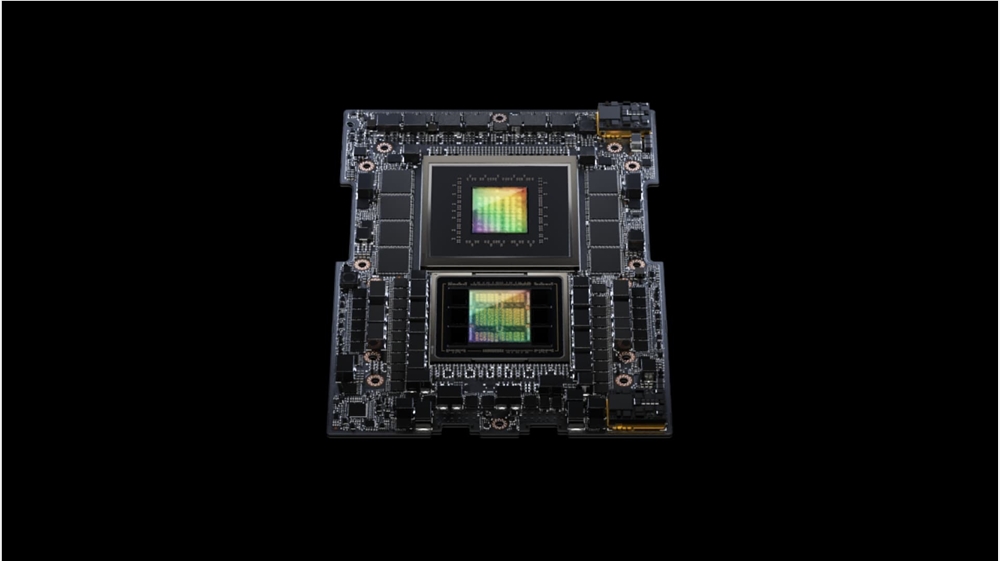

站长之家(ChinaZ.com)8月14日消息:在去年科技股市场暴跌后,所有科技行业的知名公司都在2023年实现了反弹。但有一家公司远远胜过其他所有公司,那就是英伟达。站长网2023-08-14 09:07:220001快手开源KwaiAgents系统 性能超越GPT-3.5

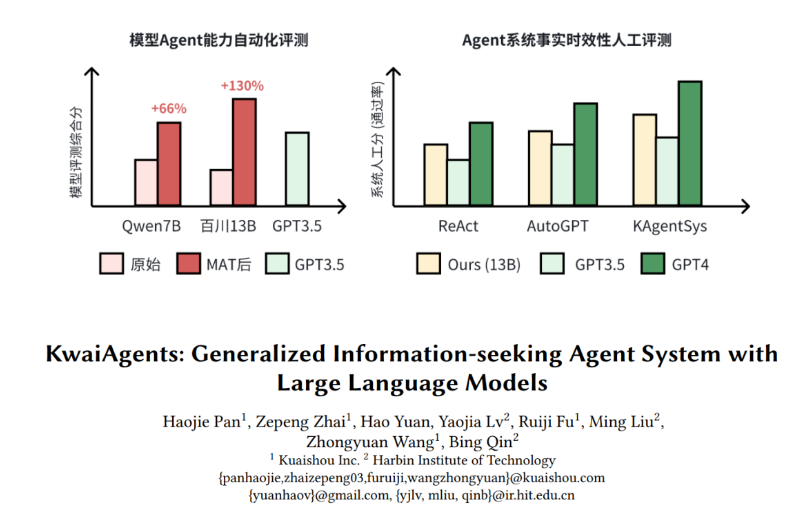

要点:1.快手与哈尔滨工业大学联合研发的「KwaiAgents」系统实现了7B/13B模型的开源,超越了GPT-3.5的效果。2.「KwaiAgents」包含轻量级AIAgents系统(KAgentSys-Lite)、具有通用能力的大模型(KAgentLMs)、以及开箱即用的自动化评测Benchmark(KAgentBench)。站长网2023-12-28 10:30:5600011000个Agent圈地模拟人类社会,北大校友创业AI版「我的世界」

北大校友打造的1000个智能体「我的世界」,火爆AI圈!随便一条推文,都能引来几十万网友围观:在这里,有着真正意义上的虚拟社会,包括文化、经济、宗教……每个智能体在GPT-4加持下,都是社会中独立自主的个体。比如这位名叫Olivia的农民,受探险故事启发,曾中途决定撂下锄头去闯荡江湖…它们以宝石(gem)作为统一货币,来完成物品交换。站长网2024-09-17 10:02:100000