Mamba带火的SSM被苹果

热点

《哪吒2》改写中国影史背后,这些配角燃爆了社交媒体

2025-02-10 03:21:53DeepSeek下棋靠忽悠赢了ChatGPT,网友:孙子兵法都用上了

2025-02-10 03:17:44字节跳动放大招!OmniHuman数字人模型即将上线:一张图+一段音频即可生成视频

2025-02-10 03:06:06专注被美图“抛弃”的女性变美赛道,这家公司扭亏为盈了

2025-02-07 16:57:05REDMI Turbo 4 Pro配置曝光:骁龙8s至尊版+7410mAh超大电池

2025-02-07 16:38:53华人研究团队揭秘:DeepSeek-R1-Zero或许并不存在「顿悟时刻」

2025-02-07 16:09:16斯坦福女神辍学再创业,获OpenAI力挺,全球首个0代码AI工程师出世

2025-02-07 15:59:18一个超实用脚本,让你的DeepSeek自动重试解放双手。

2025-02-07 15:50:58《哪吒2》登顶,谁赚麻了?

2025-02-07 15:41:39雷军去小米汽车工厂上班了:确认要进一步提产 冲击年销30万辆

2025-02-07 15:06:26

关注

消息称特斯拉Model Q年中发布:仅需人民币15万元

2025-02-05 23:25:20《哪吒2》登顶,谁赚麻了?

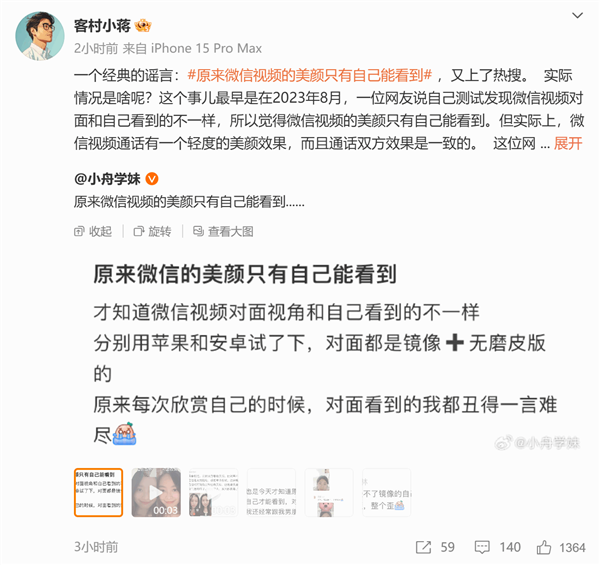

2025-02-07 15:41:39微信视频美颜仅自己能看到引热议 微信员工:谣言 双方都能见

2025-02-04 22:10:55雷军去小米汽车工厂上班了:确认要进一步提产 冲击年销30万辆

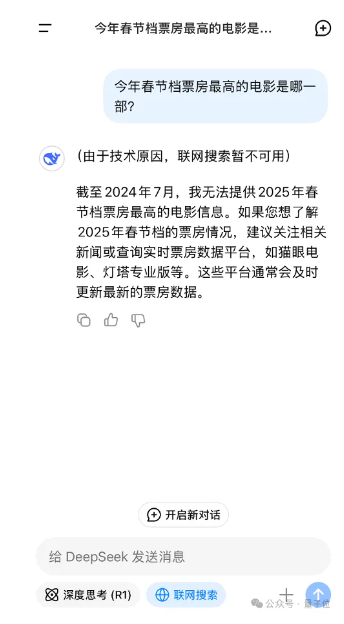

2025-02-07 15:06:26国产AI搜索接入DeepSeek-R1,深度试玩报告抢先出炉:正愁用不上官方联网搜索

2025-02-04 21:56:29小米眼镜官博上线 旗下首款AI眼镜将发布

2025-02-07 10:20:34被DeepSeek干服了!OpenAI承认闭源错误,领先优势变小

2025-02-04 20:22:14模型优惠进入倒计时 DeepSeek因服务器暂停API服务充值

2025-02-07 03:18:38用百度AI拜年,奶奶比我更上头

2025-02-04 20:17:07小米眼镜官微上线:智能眼镜赛道要爆发

2025-02-07 02:59:11