量化技术

热点

我用DeepSeek做内容,1天生产30篇小红书笔记

2025-02-14 14:02:48美团宣布超时免罚正式试点!骑手扣款改为积分制度 不影响收入

2025-02-14 11:20:04智能搜索附近美食和景点!美团App正式登陆小米汽车

2025-02-14 11:15:21三重“天时”,把《哪吒2》送进百亿俱乐部

2025-02-14 11:06:02免费短剧“上桌”春节档,小红书这波“种草”了没?

2025-02-14 09:31:12官宣!阿里巴巴确定与苹果合作,为中国iPhone提供AI

2025-02-14 09:25:01顶峰相见,奥特曼计划与DeepSeek梁文锋会面,会聊些啥?

2025-02-14 09:21:04加了AI,这款产品下载量压过赛道No.1

2025-02-14 09:15:00苹果将于2月19日发布新品 iPhone SE 4即将亮相

2025-02-14 08:25:14iPhone 17 Pro Max将首发金属超构透镜:灵动岛会变小

2025-02-13 22:10:04

关注

AI产品数据对比:一分没花的DeepSeek一骑绝尘,Kimi六小龙花钱还受伤

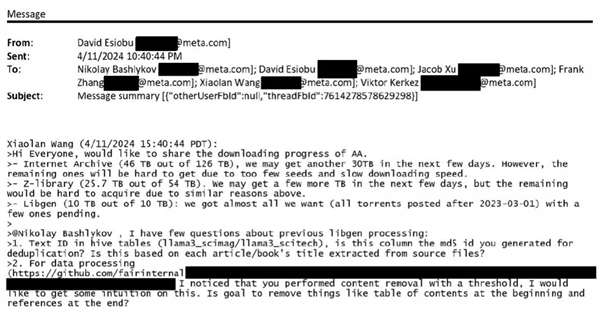

2025-02-10 08:41:45为训练AI不择手段!Meta被曝下载数十TB盗版电子书

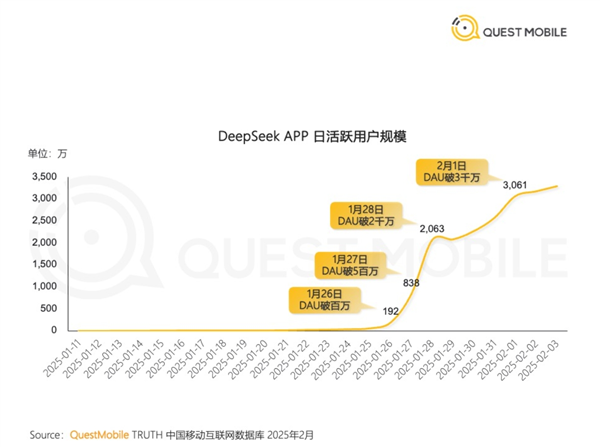

2025-02-10 08:38:57中国AI新秀爆火 DeepSeek成史上最快突破3000万日活App

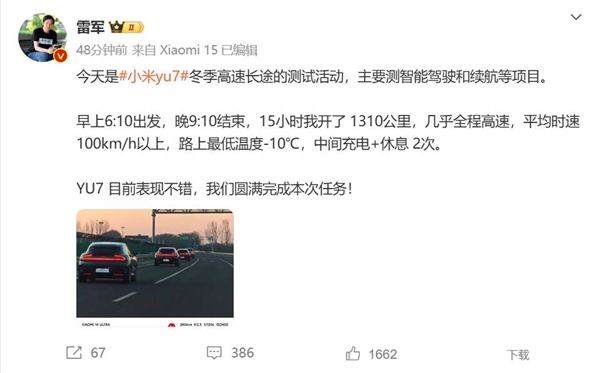

2025-02-10 08:38:56雷军驾驶小米YU7参与冬测:表现不错 测试任务圆满完成

2025-02-10 05:11:19用DeepSeek“赚钱”网课泛滥 专家:普通用户不用花钱学

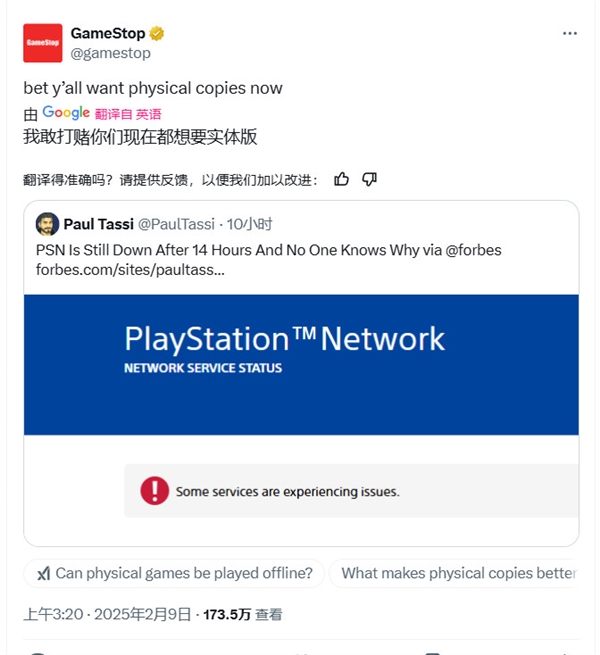

2025-02-10 05:11:18索尼PSN严重宕机!超过24小时才恢复:实体游戏零售商在线补刀

2025-02-10 05:11:17京东外卖“低佣”入局,美团回应“30%高佣”质疑

2025-02-10 05:11:12|美团开放个人摄影师入驻,搅热500亿市场?

2025-02-10 03:41:55《哪吒2》改写中国影史背后,这些配角燃爆了社交媒体

2025-02-10 03:21:53DeepSeek下棋靠忽悠赢了ChatGPT,网友:孙子兵法都用上了

2025-02-10 03:17:44