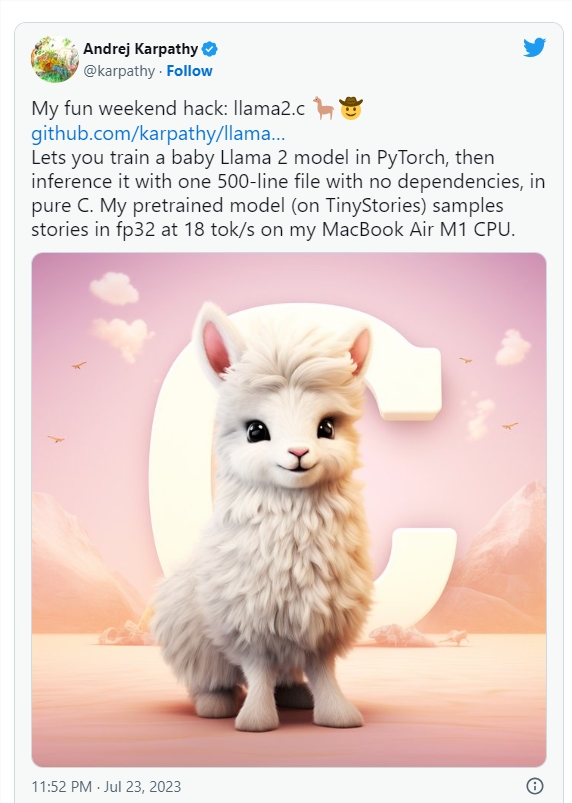

OpenAI大神Karpathy纯C代码打造简化版Llama2 已获2.2K星

OpenAI的Andrej Karpathy(其在深度学习领域的贡献而闻名)创建了一个简化版的Llama2模型_Baby-Llama,并展示了在资源受限设备上使用纯C代码运行复杂模型的可行性。

创建Llama2模型

Karpathy测试了开源项目Llama2,他在纯C编程语言中将nanoGPT调整为Llama2架构,并通过开发C代码的推理引擎“run.c”来实现。该项目在GitHub上已经获得了2.2K star。

Karpathy的方法成功地实现了高度交互率,即使使用包含数百万参数的合理规模模型,并在TinyStories数据集的1500万参数模型上进行训练。他在M1MacBook Air上报告称,Llama2模型的推理速度为每秒约100个标记,在C代码中实现了这一结果,展示了在资源受限设备上运行复杂模型的可行性。

Karpathy的Baby-Llama方法受到了Georgi Gerganov的项目llama.cpp的启发,该项目几乎与使用C和C 在MacBook上运行第一个版本的LLaMA相同。他的方法涉及使用PyTorch从头开始训练Llama2LLM架构,并将模型权重保存到原始二进制文件中。接着,他写了一个名为“run.c”的500行C文件,加载保存的模型,并使用单精度浮点数(fp32)进行推理。这种简化的方法确保了较低的内存占用,并且不需要外部库,从而在单个M1笔记本电脑上高效执行,无需GPU。

小型LLM的崛起

模型逐渐变小的最大原因是为了在较小的本地设备上进行训练和集成。Karpathy的方法不仅不需要GPU,而且为单设备上的实现提供了案例。此外,Meta与芯片制造商Qualcomm合作,旨在使Llama2在本地硬件上运行,而苹果则推出了为Apple Silicon优化的Transformers架构。Karpathy已经展示了许多可能性。

Karpathy强调这个项目是一个周末实验,并不适用于生产级部署,主要目的是展示在资源受限设备上使用纯C代码运行Llama2模型的可行性,因为长期以来,C语言在机器学习中并不常用,因为它不涉及GPU。

项目网址:https://github.com/karpathy/llama2.c

捷豹路虎宣布与 Everstream Analytics 合作 将人工智能嵌入供应链

捷豹路虎(JaguarLandRover,JLR)宣布与预测洞察公司EverstreamAnalytics合作,将人工智能嵌入其供应链。JLR将利用Everstream的人工智能实时监控供应链风险,包括自然灾害、罢工、数据泄露和出口问题等,以避免延误或中止货物发运。该技术利用人工智能、预测分析和机器学习结合「人的直觉」,帮助预防可能影响生产和增加成本的工业中断。站长网2023-06-20 16:17:500000Meta挖角Graphcore AI芯片团队,加速数据中心大规模AI和机器学习研发

据国外媒体报道,Meta从英国人工智能(AI)芯片公司Graphcore挖掘到了一支10人团队,他们此前一直在挪威开发AI网络技术,直到去年12月或是今年1月离开Graphcore,于今年2月或3月加入Meta。站长网2023-05-06 10:09:230000流量下的哈尔滨,当代城市营销的缩影

今年的哈尔滨,刷新了多个记录。据哈尔滨市文化广电和旅游局数据,截至元旦假日第3天,哈尔滨市累计接待游客304.79万人次,实现旅游总收入59.14亿元,均达历史峰值。某旅游平台数据显示,哈尔滨首次登顶最受欢迎民宿目的地,旅游订单量同比增长158%,元旦民宿预订量同比增长27倍,马迭尔冰棍3天内就卖了10万根。0000电商最后一个风口,谁在割韭菜?

一夜暴富的口号、大额数字的账户余额、包教包会的服务……跨境电商课程诱惑着用户下单购买,但迎接他们的往往是割韭菜的镰刀。举起镰刀的人大多是以往跨境电商的失败者和看准风口卖铲子的商人。海外电商淘金热下有人退出、有人继续,看到金字塔顶端成功案例的淘金者依然前赴后继。花3980元上一堂课,就能打开月入数万元的财富大门——跨境电商的风口之下,李晴被这个诱人的机会吸引了。站长网2023-05-09 14:00:150001苹果放大招!WWDC 2024详细日程出炉:史上最强iOS 18来了

快科技5月29日消息,苹果WWDC2024全球开发者大会将于北京时间6月11日至15日在线举行,大会宣传语大招码上来”。今日,苹果公布了开发者大会详细日程,包括主题演讲和PlatformsStateoftheUnion。北京时间6月11日凌晨1点Apple主题演讲:WWDC24正式开幕,届时将首次揭晓将于今年晚些时候登陆Apple各大平台的开创性更新。站长网2024-05-29 17:27:430000