MosaicML和Together推出可商用开源大模型 性能不输LLaMA

站长网2023-05-08 10:07:084阅

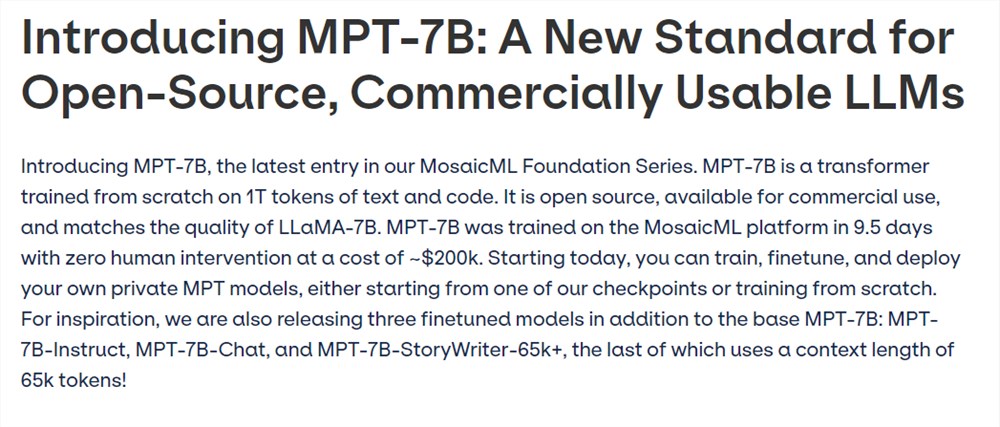

虽然Meta的LLaMA已经成为开源AI重要力量,但由于其只可用于研究用途,而且申请麻烦而被业界诟病。现在,MosaicML和Together推出可商用开源大模型,性能不输LLaMA。

MosaicML的MPT系列模型支持84k tokens超长输入,并用FlashAttention和FasterTransformer方法针对训练和推理速度做过优化。其中70亿参数版在性能测试中与LLaMA打个平手。

除了MPT-7B Base基础模型外还有三个变体。MPT-7B-Instruct,用于遵循简短指令。MPT-7B-Chat,用于多轮聊天对话。MPT-7B-StoryWriter-65k ,用于阅读和编写故事,支持65k tokens的超长上下文,用小说数据集微调。

Together的RedPajama系列模型在5TB的同名开源数据上训练而来,除了70亿参数基础模型外,还有一个30亿参数版本,可以在5年前发售的RTX2070游戏显卡上运行。

据了解,MosaicML由前英特尔AI芯片项目Nervana负责人Naveen Rao创办,致力于降低训练神经网络的成本。RedPajama由苹果前高管Vipul Ved Prakash,斯坦福大模型研究中心主任Percy Liang,苏黎世联邦理工大学助理教授张策等人联合创办。

这些开源大模型的推出,标志着开源大模型生态有了寒武纪大爆发的早期迹象。这将有助于降低人工智能技术的门槛,促进人工智能的发展。也将有助于加强人工智能技术的透明度和可解释性,避免人工智能技术被滥用。

0004

评论列表

共(0)条相关推荐

马克龙会见 Meta、谷歌人工智能专家 法国生成式 AI 蓝图本周公布

马克龙总统日前与Meta和Alphabet旗下的Google等人工智能专家会面,讨论法国在AI研究和监管中的角色。站长网2023-06-12 16:57:390000微软因安全问题暂时禁止员工使用ChatGPT

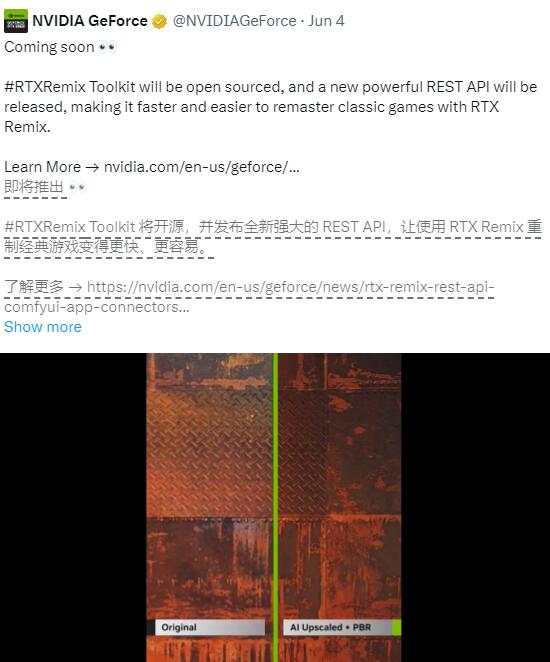

**划重点:**1.🌐微软暂时禁止员工使用ChatGPT,引起关注。2.💰尽管是OpenAI最大的投资者,微软提到ChatGPT是第三方服务,存在安全隐患。3.⚡️禁用行为被迅速撤销,微软称之为失误,强调推荐使用更安全的BingChatEnterprise和ChatGPTEnterprise。站长网2023-11-10 18:01:200000英伟达RTX Remix modders推出对应Comfyui节点 可对游戏资产放大和重绘

英伟达的RTXRemixmodders最近推出了与Comfyui兼容的新节点,这标志着游戏模组制作和资源增强方面的一大进步。通过这个新节点,模组制作者现在可以直接在Comfyui界面中对已有的游戏资产进行放大和重新绘制,这大大简化了游戏资源的编辑和升级过程。站长网2024-06-05 15:41:180001微信淘宝小红书等App试点网络身份证:认证后不再输入姓名、身份证号

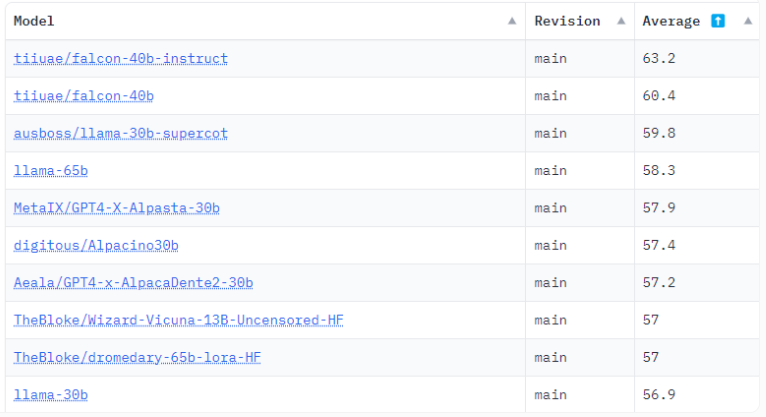

快科技8月2日消息,申领和使用网号”、网证”的应用国家网络身份认证App”已在应用商店上线。据悉,申领了网证之后,用户会得到一张虚拟的网络身份证”,它可以向需要实名认证的互联网平台进行认证,不再需要输入姓名和身份证号等信息。值得注意的是,申领注册网号”网证”需要使用身份证以及人脸识别,并关联手机号,设置网络身份口令,授权网络身份在用户手机使用。站长网2024-08-02 08:58:130002最强大开源语言模型?FalconLM号称性能击败Meta的LLaMA

当下,开源语言模型如雨后春笋般的冒出,其中有部分号称性能比Meta、谷歌等大科技公司开发的产品更优秀。最近,一款名为FalconLM开源语言模型就号称提供了比Meta的LLaMA更好的性能,也可以用于商业。但如果收入超过100万美元,则商业用途需要缴纳特许权使用费。站长网2023-05-30 10:48:090000