“百模大战”家家第一,大模型“跑分”作弊何时休?

今天在朋友圈看到一张图:国内的“百模大战”已升级成“两百模大战”,据不完全统计,今年1-7月国内共发布了64个大模型,截至目前叫得出名字的国产大模型已接近200家。这么多大模型,哪些是真能打的?在每天冒出来的各类“榜单”上出现了“家家第一”的情况,甚至已不止一款国产大模型“碾压”了GPT-4,且很多“世界顶级”大模型是出自刚成立的团队之手。

然而国产大模型在国外的境遇,却是冰火两重天。前段时间《时代周刊》公布2023年AI领域最有影响力100人,中国面孔十分罕见,有媒体评论“百模大战打了个寂寞”;日前,开源AI社区代表Hugging Face发布最受欢迎开源大模型机构TOP15榜单,在大名鼎鼎的Stability AI、Meta AI、Runway、OpenAI、谷歌、微软等海外机构外,只有一家机构来自中国:KEG实验室(全称为清华大学知识工程实验室,成立于1996年),其凭借今年开源的模型ChatGLM-6B上榜。

这种反常现象的背后,是大模型行业日益严重的“跑分乱象”。在让人眼花缭乱的大模型榜单上,似乎每一个大模型都曾拿过第一,都可分分钟碾压GPT-4。这不禁让人怀疑,国产大模型技术真的这么强?大模型技术门槛真的这么低?

大模型榜单,家家第一?

如果搜索“大模型,超越GPT-4”可以发现,多家国产大模型号称在多个维度已超越OpenAI旗下的GPT-4,且有模有样地晒出对应的大模型评测榜单“跑分”,比如某大模型宣称“基模型12项性能超越GPT-4”。相对来说,源自顶尖学术机构的大模型对自己的水平更严谨一些,它们往往不会过度强调排名数据,而科技巨头虽然会有一些“包装”但也不会太离谱,顶多只会宣称“明年挑战GPT-4”“已达到GPT3.5的水平”。

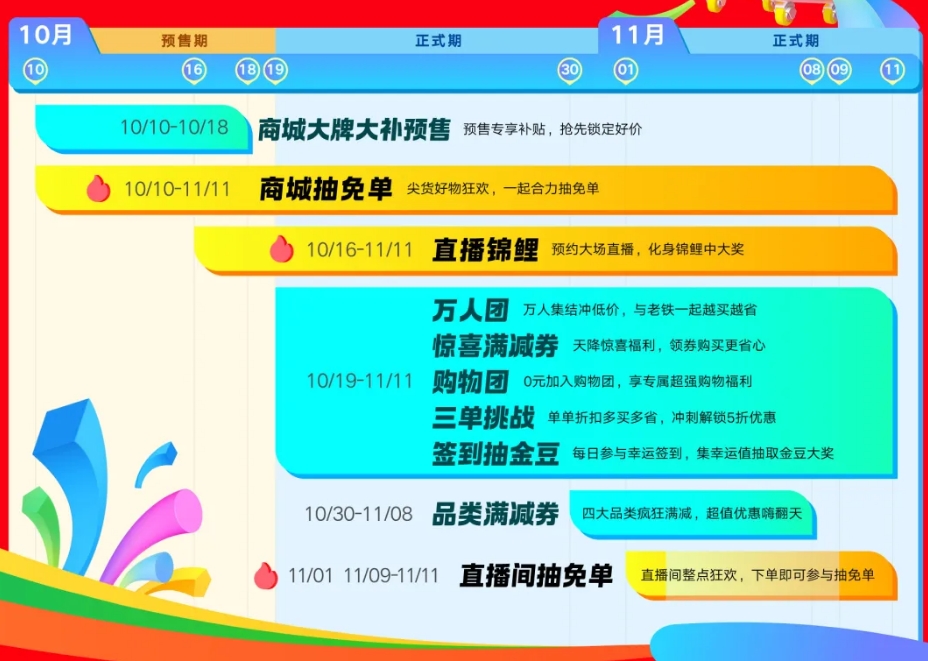

大模型“家家都是第一”的乱象,跟双11结束后的品牌战报有些相似。每个品牌都能定制一个让自己看上去“最厉害”的双11榜单,GMV不行可以说销量,两者都不行可加前缀限定到细分品类如“XX元内XX吋采取XX屏幕的电视之第一”,实在不行还能说自身同比增速行业第一。

大模型是纯技术产品,衡量其水准理论上要用专业技术评测体系,“让专业的归专业”,当前,在PK技术参数这件事上,大模型榜单存在不少问题。

前些年行业流行“参数规模越大,大模型却强大”,大模型狂卷参数,最高已过千亿。今天大模型不能再单拼参数了,因为行业都知道,参数大的大模型不一定真强大。大模型要证明实力,离不开“跑分”,就是去跑一些机构的大模型评测体系的测试数据集来“拿分”再排名。

当下,市面上的评测工具(系统)不下50个,既有来自专业学术机构的,也有来自市场运作组织的,还有一些媒体也推出了对应的大模型榜单。

在不同大模型“跑分”榜单中,同一个大模型的表现可能相差甚大,比如前段时间被质疑“基于开源大模型伪原创”的某大模型宣称超越GPT-4“勇夺全球开源评测双料冠军”,在其公布自身第一的榜单上,百度文心一言连TOP20都无法进入,但在8月15日某权威媒体研究机构发布的《人工智能大模型体验报告2.0》,百度文心一言又能排第二,第一是讯飞星火大模型;在8月28日,SuperCLUE发布的中文大模型8月榜单,GPT-4排名第一,百川智能的Baichuan-13B-Chat排在中文榜单首位;在9月的开源评测榜单C-Eval最新一期排行榜中,云天励飞大模型“云天书”排在第一,GPT-4名列第十。

不同大模型的“智力”表现,在不同榜单相差巨大,明眼人一看就知道其中暗藏玄机。

更离奇的是,就算在同一榜单中,也经常出现多个大模型共同认领第一的情况。比如某手机厂商宣布,其“自研大模型在C-Eval全球中文榜单中排名第一。此前其自研大模型已取得C-Eval百亿内大模型榜单第一,CMMLU全球中文榜单第一以及其百亿内大模型榜单第一的好成绩。”同一时间,某互联网巨头旗下的创新业务宣称其“千亿级参数的大模型登顶C-Eval和CMMLU两大权威评测榜单,多项性能优于GPT-4。”看到这里很多人肯定会有疑问:为什么在C-Eval和CMMLU这两大“权威评测榜单”中,均会同时出现两个第一?——如果继续搜索恐怕还能找到更多认领第一的情况。

只要前缀用得好,家家都是大模型王者,国产大模型秒杀GPT-4、碾压人类智商都不是事儿。

问题在于,当家家都宣称自己是大模型“王者”后,这样的“金牌”含金量到底有多少?我们不由要问:大模型评测体系到底出了什么问题?

大模型评测体系,问题在哪?

百模大战如火如荼。不同大模型都有着分出个高低的强烈需求,在这样的背景下,市面上快速出现了大量的大模型排行榜,它们可被分为三类:一类是大学等机构主导的学术类榜单,一类是第三方公司运作的市场类榜单,还有一类是媒体等非技术机构推出的评测榜单。

用手机行业来类比,第一类、第二类就像是安兔兔、dxomark这样的跑分平台,芯片、相机好不好用技术评测数据说话;第三类更像是评测体验博主,他们站在用户角度去设计榜单。真正能够衡量大模型技术实力的是第一类、第二类“跑分”榜单。

不论是学术界还是产业界的大模型榜单,当前的“跑分”原理都是一致的:设计一套评测数据集去让大模型给出答案,再阅卷打分,本质就是让大模型“做题”拿分。大模型本质是机器学习技术,其目的是提升机器的智能程度以为人类所用,因此用衡量人的能力的手段即“考试做题”来评估大模型的水准,本身不存在什么问题。

然而,大模型大规模爆发才不到一年时间,当前的大模型跑分评测体系才刚发展出来,整体很不成熟,这导致了一些大模型玩家投机取巧,靠“刷分”夺冠。

大模型评测基础体系并不复杂。用最权威的考试体系高考来对标的话:评测数据集相当于“题库”;评测工具与过程则对应到高考考试工具与过程,比如笔试用的试卷,英语听力用的广播;打分体系相当于高考的阅卷体系,比如语文作文会有多名老师阅卷再算平均分,以确保公平。

这样看的话,当前的大模型跑分评测体系问题有三:

第一、开源评测数据集题目全公开,“刷题”最流行。很多大模型评测榜单的数据集是公开的,针对此出现了普遍的“刷题”现象,有的公司会雇佣人类“数据标注员”来做题将答案给到大模型,还有的公司会让GPT-4来答题再将答案用来训练自家大模型,大模型做题就可以“满分”了。许多大模型刚推出就可以拿满分“排第一”碾压GPT-4,玄妙正在于这里。

开源评测数据集相当于高考搞“开卷考试”一样,除非是特别开放的问题(如职场面试),否则被试者完全可以提前针对性地刷题背答案,最终得分自然完全无法反映出其真实水平。

第二,评测数据不开源、全过程封闭评测,引发了公平性问题。既然将评测数据集开源会引发“刷题”,为什么评测机构要开源呢?答案在于:评测的公平性。如果机构在评测时用什么问题以及对应什么答案是什么一直不公开,如果机构的评测逻辑与工具、评分方法与过程是封闭的“黑盒子”,得出的任何结果都难免会被质疑。只有公开,才有公平公正,才能让人信服。因此,评测机构开放与不开放都难。

第三,评测数据集本身存在不够科学的情况。比如用中文数据集去考核英文大模型,跟让老外直接来参加高考一样不靠谱;再比如用通用评测数据集去评测医疗、金融、工业、科学等产业大模型,跟让体育特长生去参加普通高考一样,没太大意义。

更讽刺的是,现在行业出现了一些“随心所欲的主观榜单”,排名者不知道是谁,也不会用什么评测数据集来测试大模型,而是“我觉得谁第一谁就是第一”,比如这几天某大模型榜单,一看排名依据竟然是依据“开放程度”“技术专利”“全平台访问指数”和“热度指数”,这并不科学。

有的大模型靠“刷分”去拿第一“碾压GPT-4”,好歹还是花了点功夫去准备的,比如会让数据标注员去做题,顶多算考试舞弊“小抄”。但是搞一些排名机构都不知道是谁、连评测数据集都没有的主观榜单来宣称“第一”的玩家,简直就跟花钱去野鸡大学买学历的差不多——更准确的说法应该是,“办假证”,就算野鸡大学也要去像模像样学习一番。

没有任何证据表明有大模型创业者“花钱买榜”的情况,但当前大模型榜单确实存在严重问题,市场亟待一套类似于高考一样的权威的大模型评测体系,在公平公正公开的同时,科学、全面、有效地衡量大模型的综合水平。

市场需要怎样的大模型评测体系?

从隋唐时期出现的科举考试到今天的高考,从中国的四六级英语考试再到国外的GRE、托福、雅思……“考试”让每个人都可以公平地被衡量,进而得到对应的成长机会。

同理,大模型评测体系对大模型的发展也不可或缺:

一方面,如果评测相对准确、靠谱、权威,可以科学、全面、有效地衡量孰优孰劣,对市场所有大模型玩家来说无疑是好事。如果评测不准确,阿猫阿狗的大模型都可以“第一”“夺冠”“屠榜”,对真正拥有顶尖人才、投入巨大资源、攻坚技术卡点的大模型团队无疑是十分不公平的。榜单排名不只是决定市场认知,往往也意味着人才、资金等资源的凝聚能力。

另一方面,只有评测结果相对准确,大模型研发者才能知道自己产品的市场水平在哪,优缺点在哪,进而查漏补缺,沿着正确的方向钻研算法、提升技术、加强训练,不断攻克难点不断升级迭代,这样的过程就像高中同学们参加“模拟考试”或者“摸底考试”的意义一样。

那么,大模型评测体系怎样才能成为“高考”一样的权威评测体系呢?

首先,“假学历”、“野鸡大学学历”这一类“野鸡榜单”应该被彻底反对,“买榜单”“买排名”这样的做法应该被坚决鄙视。让技术的归技术,大模型技术实力只能且必须用技术说话,搞一些跟技术没关系的评估维度来生拉硬套“造榜单”跟“买假学历证”的行为没什么区别,行业对这类榜单应该毫不犹豫地唾弃。

其次,大模型要证明技术水平就要尊重“考试”规则,参加“高考”,当前的大模型“高考”体系有待改进:

1、评测过程全开放,数据应该“开/闭结合”。机构的评测工具、评测过程、评测方法以及评分体系应该毫无保留地开源,确保公平公正公开。评测数据集则应“开/闭结合”,开源历史题目让大模型训练,但正式的评测数据集应该封闭以杜绝“刷榜”,在评测结束后再开放避嫌“暗箱操作”,同时也可以让大模型研发者有的放矢地去发现问题和改进技术。此外,机构也可以开源类似于面试求职一样的开放题目,再配套对应的评测体系来衡量大模型表现。

参考高考作文题目打分来看,评测机构甚至可以多家联合评测,最大化规避主观问题和随机因素,尽可能真实地衡量大模型的水平。

2、评测体系更全面,评测方式多元化。除针对大模型在性能与泛化评测等表现设计评估体系外,更多兼顾到大模型的能效、鲁棒性、安全性等综合能力评测。与此同时,针对不同类型的大模型设计对应的评测体系,比如金融大模型强化金融级安全评测,比如工业大模型则要评估其在恶劣环境下的极限表现。

3、评测数据集更专业,不断丰富评测数据。评测数据集的建立过程本质是“命题”,参考高考来看,这是一个系统而科学的工程。针对大模型的评测数据集应该不断完善,随着大模型的迭代而迭代,比如GPT-4强化多模态能力,评测数据集也应该配套强化音视频等多媒体内容理解与生成相关评测数据集;再比如针对金融等专业大模型,评测数据集应该有对应的专业题库。每年高考作文命题都会贴合实时,正是因为相关题目不可能存在历史题目,大模型评测数据集同样可与时俱进,结合最新的实时知识去完善,让大模型不可能靠刷题、刷分得高分。

如何准确测量一个大模型的能力,这实际上还是一个非常有争议的问题,因为目前我们其实还并不能确切地指出大模型智能涌现的原因。很多时候,模型运作本身是一个黑箱过程,这就意味着对大模型的测评某种意义上讲是管中窥豹——它的完善就如同大模型能力的提升一样,都将是一个长期的过程。

世界上不会有完美的大模型评测体系,但随着技术的迭代,当前的大模型评估体系需要升级,贴合市场需求,回归技术本身,让大模型开发者们可以沿着正确的方向前进。

对于大模型开发者来说,任何榜单的排名是技术进化的自然结果,而不应该被当成目的。大模型团队的资源是有限的,如果花心思、资源与精力去定制榜单搞排名追求“虚假强大”,哪怕拿遍行业第一都没什么意义,这是缘木求鱼。不论怎样证明自己第一都是没有用的,不断精进技术,加速技术产品化的步伐,让技术进入场景才是大模型团队的大事。有没有B端客户买单?真实下载量、用户数到底如何?行业内的真实口碑如何?学术圈的技术评价怎样?能不能实现商业化?这些评估体系远比任何榜单的排名重要得多。

IBM将在安全智能平台QRadar中引入生成式AI

**划重点:**-🌐QRadar,由IBM于2011年收购Q1Labs而获得,是安全信息与事件管理(SIEM)领域的顶级产品。-🤖IBM计划通过引入Watsonx产品线的GenAI功能,将生成式AI整合到QRadar中,以自动化报告、威胁猎捕、数据解释和数据整理等任务。-🚀这项技术升级预计将于2024年第一季度推出,旨在减轻安全分析师的负担,使其能够专注于更重要的工作。站长网2023-11-13 18:54:160000泰国皇家集团索赔中国瑞幸100亿 瑞幸:未接通知

据泰国媒体报道,泰国皇家50R集团向法院提交诉讼,要求中国瑞幸咖啡赔偿100亿泰铢经济损失。法院已立案受理。文件显示,50R集团2020年向泰国商务部注册瑞幸商标,获准使用经营咖啡店。但中国瑞幸向法院提起诉讼,指控其恶意注册。初审判决50R败诉。50R不服提出上诉,12月1日二审胜诉。对此,瑞幸咖啡未就此事置评。瑞幸客服表示,未收到通知。0000苹果内部已经在使用其聊天机器人Apple GPT辅助工作

据彭博社报道,苹果正在内部使用聊天机器人AppleGPT进行工作。这个聊天机器人可以帮助员工设计未来功能的原型、总结文本并根据训练过的数据回答问题。尽管苹果尚未确定AppleGPT项目在面向客户方面的用途,但据报道,苹果正在寻找方法在其组织内扩大生成式AI的使用。其中一个可能的应用是将这个工具提供给AppleCare支持人员,以更好地帮助客户处理问题。站长网2023-07-24 14:03:420000百度在万象大会宣布开启内测“AI伙伴” 将支持多轮对话、实时搜索

今天,在2023万象·百度移动生态大会上,百度透露正在内测的"AI伙伴"和"AIBOT"等功能,并展示了内测产品NEWAPP。在今年618电商节到来之际,百度推出全新智能电商品牌"百度优选",发布了一系列智能商家经营方案,包括AI导购助手、电商AI主播制作平台、商家经营能力模型等。站长网2023-05-25 14:08:190000小米汽车官网“xiaomiev.com”正式上线

随着小米su7的发布,小米汽车官网“xiaomiev.com”也已正式上线。小米汽车在今天的技术发布会上预发布了其首款车型小米SU7。站长网2023-12-28 17:47:080001