南加州大学提出通道式轻量级重编码CLR 解决大语言模型灾难性遗忘问题

要点:

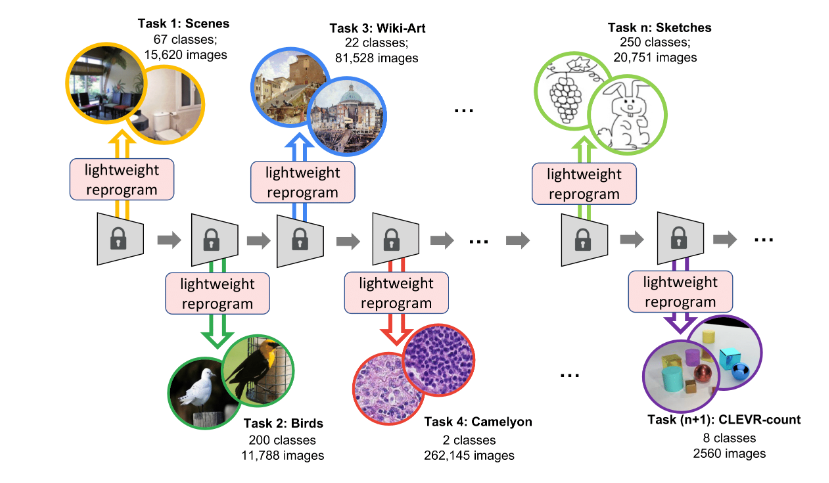

1. 南加州大学和Google Research提出了通道式轻量级重编码(Channel-wise Lightweight Reprogramming)方法,用于解决持续学习问题,通过在固定任务不变的模型背骨干中添加轻量级可训练模块,对每层通道的特征图进行重编程,以适应新任务,仅占0.6%的额外参数。

2. 通道式轻量级重编码方法采用动态网络方式,可以持续学习多个新任务而不会出现灾难性遗忘,使模型在不同任务之间灵活转换。

3. 这项研究的动机是持续学习中的遗忘问题,提出了一种更轻量级但更强大的重编程方法,通过通道线性映射和卷积核的重编码,使模型能够适应多个新任务,实现更好的性能。

在持续学习领域,南加州大学和Google Research提出了一项创新的方法,通道式轻量级重编码(Channel-wise Lightweight Reprogramming,CLR),旨在解决模型在持续学习新任务时出现的灾难性遗忘问题。持续学习的关键挑战是如何在学习新任务后仍然保持对旧任务的性能,而CLR方法提供了一种有前景的解决方案。

与传统的多任务学习不同,持续学习是在一个接一个的任务中进行学习,模型需要逐个适应新的任务,同时尽量避免遗忘之前学到的知识。

论文地址: https://arxiv.org/pdf/2307.11386.pdf

项目地址: https://github.com/gyhandy/Channel-wise-Lightweight-Reprogramming

数据集地址: https://ilab.usc.edu/andy/skill102

CLR的创新之处在于它通过在模型的固定骨干(backbone)中引入可训练的轻量级模块,对每一层的通道特征图进行重编程,使其适用于新任务。这些轻量级模块仅占整个模型的0.6%额外参数,但为每个新任务提供了定制的特征。这意味着模型可以连续学习无数个新任务,而不会受到灾难性遗忘的困扰。

CLR方法采用了动态网络的方式,通过通道线性映射对卷积核产生的特征图进行重编程,实现了多个新任务之间的平滑切换。该方法的灵活性使其在持续学习中表现出色,即使面对众多新任务,每个轻量级模块所需的训练参数仍然非常有限,这使得模型的规模保持相对较小。

CLR方法通过引入轻量级重编程参数,使模型能够以更轻量级但更强大的方式适应不同的新任务。它解决了持续学习中的遗忘问题,为模型提供了更好的性能和灵活性。

通道式轻量级重编码(CLR)方法为持续学习领域带来了新的机会,使模型能够在不断学习新任务的同时,有效地保持对旧任务的性能,为多任务学习领域带来了新的突破。这一创新方法有望为未来的持续学习研究和应用提供更多的可能性。

国产AI天花板!讯飞星火iOS内测版上线:已覆盖PC、手机等主流系统

前不久,科大讯飞星火认知大模型V1.5正式发布,各项能力达到了国产AI的天花板级别。6月13日,讯飞星火认知大模型再次迎来更新升级iOS内测版本正式上线。至此,讯飞星火在国产大模型中抢先实现PC、iOS、安卓、小程序与H5”主流系统的全覆盖,并支持跨设备历史记录同步,用户可在主流系统平台自由切换。站长网2023-06-15 09:55:310000新NeRF技术:将视频转化为可控制的3D模型 创建数字人更简单了

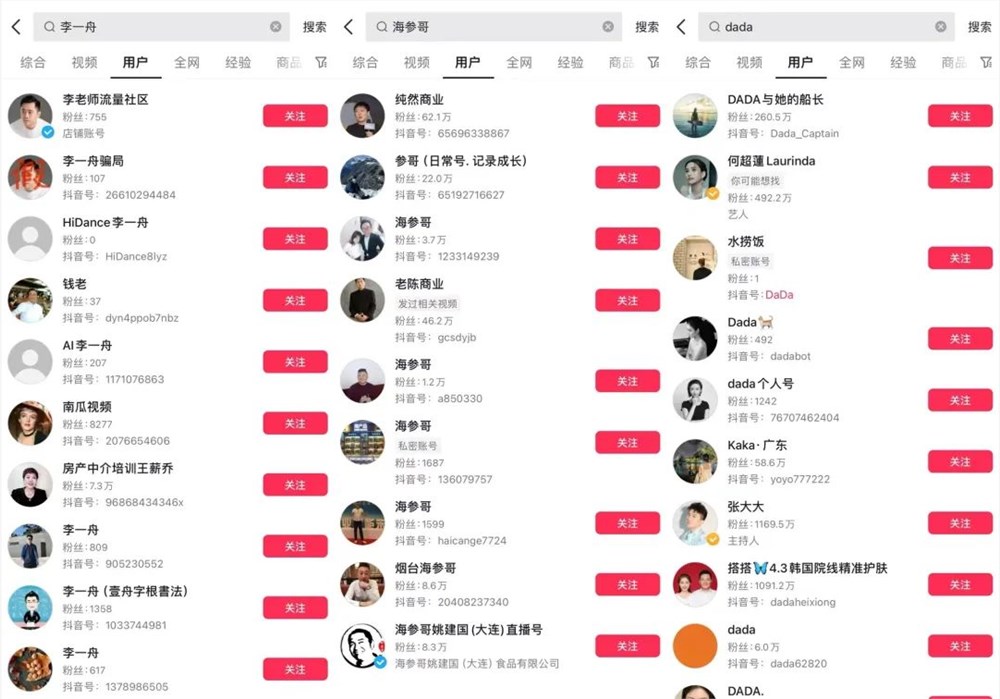

划重点:1.🤖FraunhoferHeinrichHertz研究团队引入新技术,使用神经辐射场(NeRF)将标准RGB视频转化为可控制的3D人体模型,简化了数字人物创建过程。2.👥这一创新有望在电影、游戏、虚拟现实等领域,降低数字人物模型制作成本,提供更多应用可能。3.🖼️NeRF技术通过预测光线与场景的交互来创建逼真的3D图像,为实现从不同角度的人物动作提供了新途径。站长网2023-11-08 11:08:340001短视频网红博主遭小程序“AI换脸” 法院判决后者侵犯肖像权

据江苏高院公众号消息,近日,江苏高院公布了一起因“AI换脸”技术引发的肖像权纠纷。小林是某短视频平台的小网红,拥有一定数量的关注者,日常在平台上发布自己出镜的国风短视频。站长网2023-07-04 14:40:290000这个五一档,韩寒赢麻了

如果不是这个五一档,大概很多人已经想不起韩寒了。他在大众脑海中的形象,被定格在2022年春节档《四海》的见面会“四海歌会”上。那时,他穿着毛衣,把头发剪成圆寸,戴着黑框眼镜,站在舞台最左侧,卖力地和曾经合作过的演员们合唱,为即将在春节档上映的《四海》宣传。站长网2023-05-07 09:25:440002